Когда мы говорим о проверке возможностей ИИ в инженерии машинного обучения, чаще всего всплывают статичные бенчмарки: однажды собранные организаторами конкурсы, единый датасет, фиксированная метрика. Это удобно, но плохо масштабируется. Каждую задачу приходится долго выверять, приводить к общему формату и обновлять вручную. В результате мы получаем ограниченный мир задач, тогда как реальный поток данных куда разнообразнее. Исследование MLE-Smith предлагает переломить ситуацию: превратить сырые датасеты в живые соревновательные задачи автоматически — с сохранением структуры, смысла и практической ценности.

Зачем это нужно

Статичные наборы тормозят прогресс по трем причинам. Во‑первых, они быстро устаревают: индустрия движется, а бенчмарки — нет. Во‑вторых, они узко покрывают модальности и домены, потому что ручная подготовка дорогая. И наконец, такие задачи часто теряют реализм: из них вычищены шероховатости, с которыми сталкивается инженер на практике. Если научиться генерировать задачи автоматически, можно открывать все новые и новые участки пространства данных и одновременно держать высокую планку качества.

Как устроен конвейер

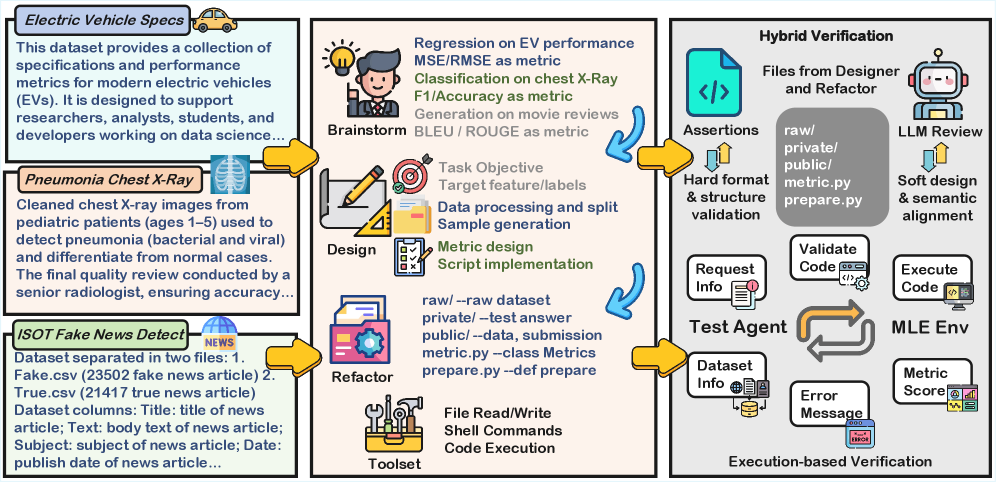

В основе MLE-Smith — мультиагентная система, которая работает по схеме генерация — проверка — исполнение. Роли распределены так:

-

Brainstormer изучает сырые данные, предлагает несколько постановок с целями, метриками и планом подготовки признаков. Главное правило — опираться только на то, что реально есть в данных.

-

Designer превращает идею в полный, исполнимый пакет соревнования: от скрипта подготовки до метрики, описания и тестов.

-

Refactor приводит всё к единому стандарту: строгое дерево каталогов, образец отправки, ответы тестовой части, проверка целостности.

От идеи к работающему соревнованию

На выходе появляется стандартный набор артефактов: описания, публичная часть данных, приватные ответы для скоринга, единый протокол оценки. prepare.py детерминированно собирает train/test и гарантирует отсутствие утечек. metric.py валидирует формат предсказаний и считает качество. Все это сопровождается автотестами и строгими проверками интерфейсов — чтобы задачу можно было запускать без ручной подгонки.

Проверки без поблажек

Проверка идет в три слоя. Сначала жесткие утверждения: структура каталогов, сигнатуры функций, успешный прогон подготовки и метрики, корректность образцов. Затем мягкая семантическая ревизия: ясность формулировок, уместность метрики, отсутствие тривиальных путей к ответу. И наконец, испытание боем — запуск в интерактивной среде, где агент пишет и исполняет код, получает обратную связь и улучшает решения. Проходишь все три — попадаешь в финальную коллекцию.

Где масштаб и сколько это стоит

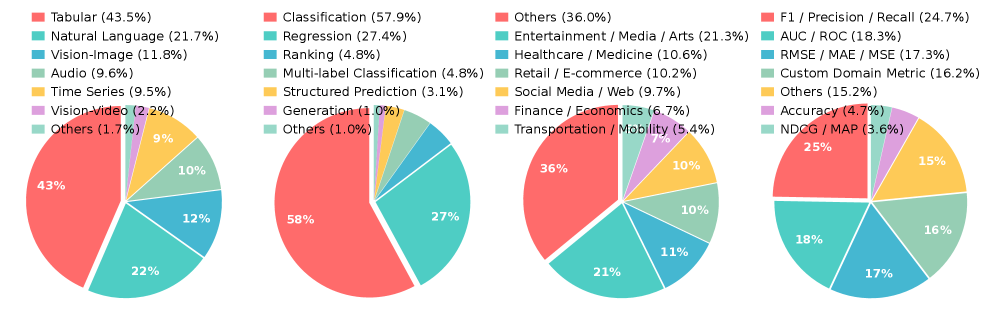

Система прогнала 300 датасетов и собрала 807 черновых задач. После всех проверок верифицированными стали 606 задач на 224 датасетах — в среднем почти три на набор данных. Подготовка одной задачи занимает около 7 минут на генерацию артефактов плюс до 10 минут на прогон в среде (варьирует по модальностям и железу). Средняя стоимость — менее доллара за задачу. Покрыты таблицы, текст, изображения, видео, аудио, ряды; формулировки — классификация, регрессия, ранжирование, мульти‑лейбл и даже генерация. Метрики тоже разнообразны: от F1 и AUC до NDCG и доменно‑специфичных.

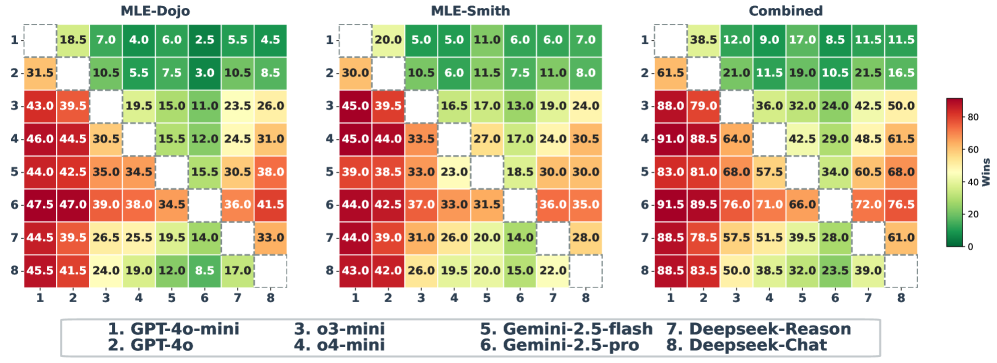

Что показали эксперименты

Авторы собрали комбинированный набор из 100 задач: 50 человеческих из MLE-Dojo и 50 автоматически созданных. Восемь современных LLM-агентов соревновались в одинаковой интерактивной среде. Ранжирование по Elo оказалось практически идентичным на реальных и сгенерированных задачах: корреляции близки к единице, совпадает и верхушка таблицы лидеров. Это важный маркер — искусственно созданные задания не упрощают жизнь моделям и так же хорошо различают сильных и слабых.

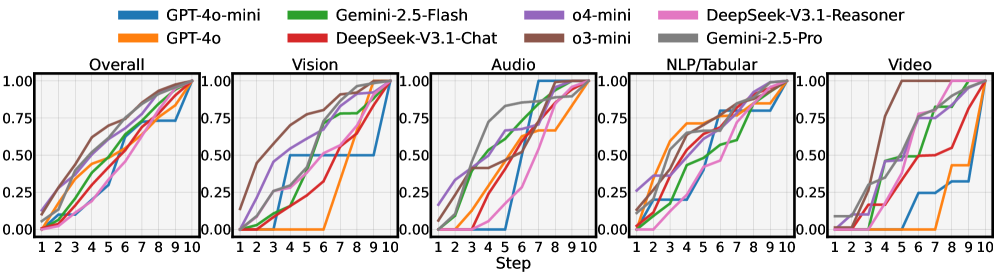

Еще один интересный ньюанс — динамика по шагам. Агент действует по циклу запрос информации — напиши код — запусти — исправь. Нормализованные кривые качества монотонно растут от шага к шагу, что показывает чувствительность задач к инженерному прогрессу: лучше код и пайплайн — выше результат. Это именно то поведение, которое мы ждем от реалистичных MLE‑сценариев.

Что это меняет для сообщества

MLE-Smith демонстрирует, что автоматическая фабрика задач возможна. Важно не только количество, но и процедурные гарантии: структурная целостность, семантическая корректность и подтвержденная исполнимость. Такая фабрика позволяет быстро наращивать покрытие доменов и модальностей, обновлять задания без ручной рутины и, главное, сравнивать агентов на постоянно свежем и честном поле. Когда оценки на синтетически созданных задачах неотличимы от человеческих бенчмарков, мы получаем новый стандарт масштабируемой оценки и тренировки агентов, включая те, что опираются на модель мира и сложные цепочки действий.

Вместо послесловия

Авторы не пытаются заменить все живые конкурсы. Они создают инфраструктуру, где новые данные превращаются в отлаженные испытания без потери качества. Это ровно тот случай, когда автоматизация не обедняет, а расширяет реальность: задач больше, они разнообразнее и при этом так же хорошо меряют способности моделей и команд.

***

Если вам интересна тема ИИ, подписывайтесь на мой Telegram‑канал — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist