Google представили архитектуру Titans и фреймворк MIRAS, которые позволяют моделям ИИ работать гораздо быстрее и обрабатывать большие объемы данных за счет обновления основной памяти во время ее активной работы.

В двух новых статьях, Titans и MIRAS , Google представила архитектуру и теоретическую схему, сочетающие скорость рекуррентных нейронных сетей (РНС) с точностью трансформеров. Titans – это конкретная архитектура (инструмент), а MIRAS – теоретическая основа (схема) для обобщения этих подходов. Вместе они развивают концепцию запоминания во время тестирования – способности модели ИИ поддерживать долговременную память за счёт включения более мощных метрик-сюрпризов (то есть неожиданных фрагментов информации) во время работы модели и без специального офлайн-обучения.

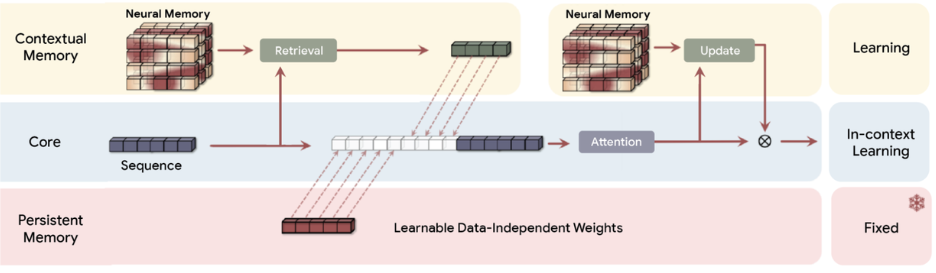

Эффективная система обучения требует отдельных, но взаимосвязанных модулей памяти, отражающих разделение человеческого мозга на кратковременную и долговременную память. Хотя механизмы внимания превосходны для точной кратковременной памяти, Titans представляет новый нейронный модуль долговременной памяти , который, в отличие от векторной или матричной памяти фиксированного размера в традиционных рекуррентных нейронных сетях, действует как глубокая нейронная сеть (в частности, многослойный персептрон). Этот модуль памяти обеспечивает значительно более высокую выразительную способность, позволяя модели обобщать большие объёмы информации, не теряя важного контекста. Модель не просто делает заметки. Она понимает и синтезирует всю историю.

Важно отметить, что Titans не просто пассивно хранит данные. Он активно обучается распознавать и сохранять важные взаимосвязи и концептуальные темы, связывающие токены по всему объёму входных данных. Ключевым аспектом этой способности является то, что Google называет «метрикой неожиданности». В психологии человека известно, что мы быстро и легко забываем привычные, ожидаемые события, но запоминаем то, что нарушает шаблон – неожиданные, удивительные или очень эмоциональные события.

В контексте Titans «метрика неожиданности» – это обнаружение моделью большой разницы между тем, что она помнит в данный момент, и тем, что сообщают ей новые входные данные.

-

Низкий уровень удивления: если новое слово – кошка, а состояние памяти модели уже предполагает наличие слова, обозначающего животное, градиент (удивление) низкий. Модель может спокойно пропустить запоминание этого слова в своем постоянном долгосрочном состоянии.

-

Высокая степень неожиданности: если состояние памяти модели представляет собой обобщение серьёзного финансового отчёта, а новые входные данные представляют собой изображение банановой кожуры (неожиданное событие), градиент (неожиданность) будет очень высоким. Это означает, что новые входные данные важны или аномальны, и им необходимо придать приоритет для постоянного хранения в модуле долговременной памяти.

Уникальность и практичность MIRAS обусловлены его подходом к моделированию ИИ. Вместо того, чтобы рассматривать различные архитектуры, MIRAS видит различные методы решения одной и той же задачи: эффективное сочетание новой информации со старыми воспоминаниями, не допуская забвения основных концепций .

MIRAS определяет модель последовательности с помощью четырех ключевых вариантов проектирования:

-

Архитектура памяти: структура, которая хранит информацию (например, вектор, матрица или глубокий многослойный персептрон, как в Титанах).

-

Смещение внимания: внутренняя цель обучения, которую оптимизирует модель и которая определяет ее приоритеты.

-

Механизм запоминания: регуляризатор памяти. MIRAS переосмысливает механизмы забывания как особые формы регуляризации , которые обеспечивают баланс между новым обучением и сохранением прошлых знаний.

-

Алгоритм памяти: алгоритм оптимизации, используемый для обновления памяти.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: MrRjxrby