В разработке мне регулярно нужны картинки “вокруг кода”: обложки к техпостам/README, иллюстрации в документацию, а иногда — быстрые ассеты/референсы для пет-проектов.

В рамках сезона решил протестировать Kandinsky 5.0 на типовых сценах и сравнить ощущения с привычным пайплайном на Stable Diffusion: где быстрее получить годный результат без плясок с промптом, а где лучше иметь “запасной аэродром”.

Под “разработческими задачами” здесь я имею в виду не генерацию кода, а задачи вокруг продукта: обложки к постам/README, иллюстрации к документации и быстрые прототипы визуалов/ассетов для пет-проектов.

Методика и сетап

Сразу обозначу вводные, чтобы было проще воспроизвести результат и чтобы сравнение было честным в рамках того, как я это реально использую.

Железо: Ryzen 7 7800X3D + RTX 3070 + 64 GB DDR5.

Модели и режимы:

-

Kandinsky:

-

для Фотореалистичных-сцен — стиль не выбирал,

-

для Аниме/иллюстативных-сцен — стиль “аниме”,

-

генерировал в 1024×1024,

-

делал только позитивный промпт (негативные промпты в интерфейсе не предусмотрены).

-

-

Stable Diffusion:

-

для Фотореалистичных-сцен —

realisticVisionV60B1_v51HyperVAE, -

для Аниме/иллюстативных-сцен —

waiIllustriousSDXL_v150, -

генерировал в 512×512,

-

использовал позитив + негатив,

-

настройки “по умолчанию”, менял только seed на

123456789, чтобы можно было воспроизвести.

-

Почему так: я сознательно сравнивал инструменты в тех режимах, в которых реально ими пользуюсь на своём ПК, а не пытался идеально выровнять условия. Kandinsky у меня запускался в 1024×1024 и сразу отдавал 4 варианта на один промпт — это удобно для “быстрого выбора лучшего” (выбирал наилучшее изображение из предложенных). Stable Diffusion я гонял в 512×512 с теми настройками по умолчанию, которые обычно используют для быстрого прогона на RTX 3070; при желании картинку можно апскейлить и/или крутить дольше, но цель теста была “что получится без плясок”.

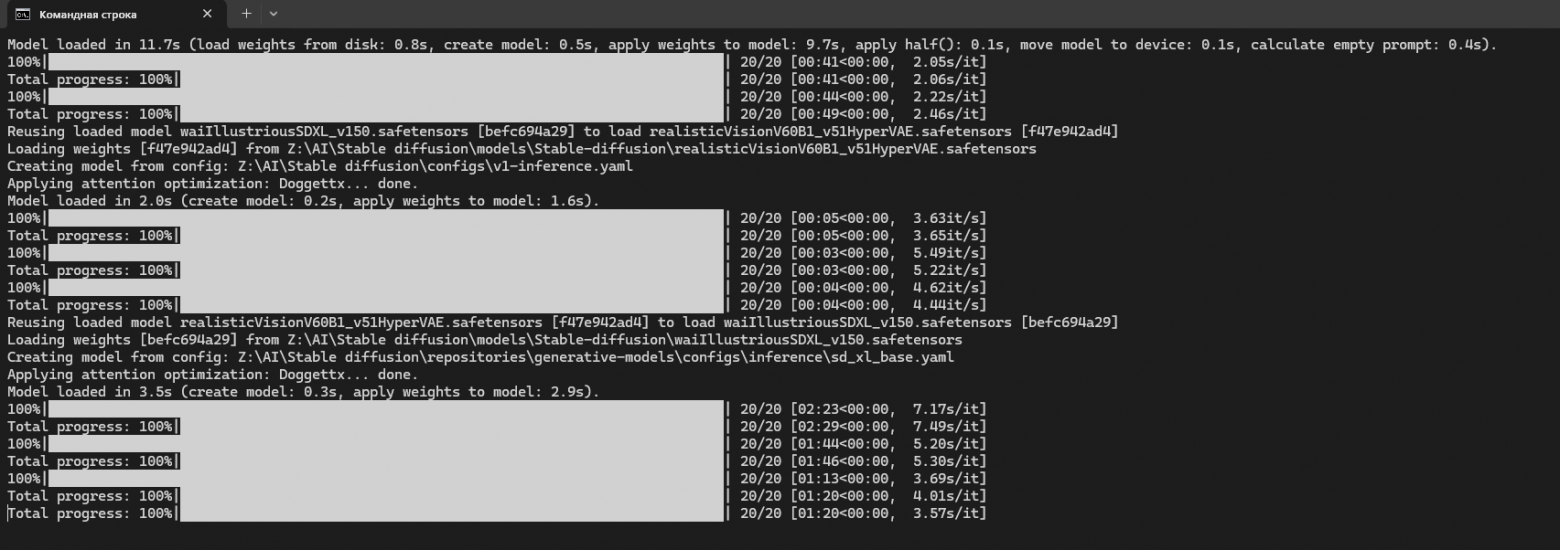

По времени (очень грубо, чтобы понимать порядок): Kandinsky в моём режиме делал 4 изображения примерно за ~20 секунд. Для Stable Diffusion скорость сильно зависела от модели: на SD1.5‑ветке (realisticVision) прогон 20 шагов занимал порядка 3–5 секунд на изображение, а на SDXL‑ветке (waiIllustriousSDXL) те же 20 шагов — уже примерно 40–150 секунд на изображение (в моих логах встречались прогоны ~41–49 секунд и вплоть до ~2:23). Отдельно стоит помнить, что первая загрузка модели тоже занимает время: в логах было ~11.7 секунд на стартовую загрузку.

Логи генерации Stable Diffusion (время и загрузка моделей)

– Kandinsky:

– SD: картинка

Важно: сравнение не «лабораторное» (разные разрешения и разные пайплайны), но именно так это и происходит в реальной жизни: каждый запускает тем способом, который ему удобнее, и выбирает то, что быстрее даёт приемлемый результат.

Результаты по сценам

Фотореалистичные сценарии:

«Разработчик и два монитора»

Что ожидалось: офисный разработчик за столом + два монитора, на них — что-то похожее на код (идеальная картинка для техматериала).

Промпты, которые я использовал для генерации картинок:

-

SD prompt:

ultra realistic photo, 35mm lens, shallow depth of field, a software engineer at a desk in a modern office, dual monitors, dark theme IDE with C# code, mechanical keyboard, warm evening light, realistic hands on keyboard, natural skin texture, sharp details, HDR; negative:lowres, blurry, bad anatomy, bad hands, extra fingers, deformed, watermark, logo, text, jpeg artifacts, cartoon, anime, 3d render -

Kandinsky prompt:

Фотореалистичная фотография: разработчик за рабочим столом в современном офисе, два монитора, тёмная тема IDE, код на C#, механическая клавиатура, тёплый вечерний свет, реалистичные руки на клавиатуре, высокая детализация, HDR

Что увидел:

Kandinsky

-

В версии Kandinsky сцена воспринимается как “человек реально работает”: оба монитора выглядят цельно, на основном читается окно редактора кода, на втором тоже виден код, при этом нет явных “сломов” интерфейса или случайных артефактов. Руки выглядят проработанными — в моём варианте были заметны даже мелкие детали вроде вен, что редко бывает в офисных сценах без дополнительных итераций. Отдельно понравилось, что модель добавила естественный источник света (солнечный свет со стороны второго монитора), и из‑за этого картинка выглядит менее “плоской”.

Stable Diffusion

-

У Stable Diffusion общая идея “два монитора + человек” тоже считывается, но персонаж выглядит менее вовлечённым в работу: он не смотрит на экраны, рабочее место кажется менее логичным (например, у меня не было видно мыши), а детали периферии и второго монитора выглядят менее уверенно. Из‑за этого сцена воспринимается скорее как “человек рядом с мониторами”, а не “разработчик пишет код”.

Вывод: для “обложек под разработку” Kandinsky в моём тесте оказался ближе к ожидаемой сцене без дополнительных итераций: хорошо держит смысл “человек работает”, уверенно рисует два экрана и даёт правдоподобные детали рук и света. При этом именно в таких сюжетах важны мелочи вроде “что на мониторах” и насколько логично выглядит рабочее место — здесь Kandinsky выглядел убедительнее. Stable Diffusion идею тоже считывает, но чаще требует дополнительной доводки, чтобы персонаж выглядел вовлечённым, а рабочее место — более “рабочим”.

«Портрет крупным планом»

Что ожидалось: максимально нейтральный “реальный” портрет без неестественных артефактов (аватар/иллюстрация персонажа).

Промпты, которые я использовал для генерации картинок:

-

SD prompt:

ultra realistic portrait photo of a 28 year old male software engineer,soft studio lighting, 85mm lens, shallow depth of field, natural skin pores, realistic eyes, high detail, neutral background; negative:lowres, blurry, bad anatomy, deformed face, asymmetry, uncanny, bad teeth, extra eyes, watermark, logo, text -

Kandinsky prompt:

Фотореалистичный портрет крупным планом мужчины 28 лет, мягкий студийный свет, объектив 85мм, натуральная кожа и поры, реалистичные глаза, высокая детализация, нейтральный фон

Что увидел:

Kandinsky

-

У Kandinsky портрет выглядит “дороже” по микродеталям: заметна щетина, аккуратно проработаны брови, нос и губы, а в глазах видно отражение (это добавляет реализма). Явных дефектов лица не заметил; максимум — небольшой артефакт на нижних ресницах одного глаза, но он не бросается в глаза при обычном просмотре.

Stable Diffusion

-

У Stable Diffusion портрет в целом узнаваемый и с отражением в глазах, но есть несколько “красных флажков”, которые портят впечатление: щетина выглядит странно, возле рта/на лбу появляются участки неестественного оттенка (у меня это выглядело как синяки), и много красных “веснушек”, которые выглядят не как кожа, а как артефакт. Ресницы при этом могут быть даже аккуратнее, но брови выглядят менее естественно, и в сумме лицо кажется менее реалистичным.

Вывод: в портретах Kandinsky у меня чаще давал результат, который можно сразу использовать как аватар/иллюстрацию персонажа: меньше заметных артефактов кожи и более “дорогая” проработка микродеталей (щетина, черты лица, блики/отражения). Stable Diffusion в этом тесте выглядел более капризным: при тех же исходных настройках проявились дефекты оттенков кожи и “шум” на лице, из‑за чего портрет воспринимается менее естественно. Для SD такой результат обычно лечится временем: перебором seed, усилением негатива и/или выбором другого чекпоинта под портреты.

«Обложка: ноутбук и боке города»

Что ожидалось: спокойная “стоковая” обложка для техстатьи — ноутбук на переднем плане, на фоне город в боке.

Промпты, которые я использовал для генерации картинок:

-

SD prompt:

minimalistic realistic photo, clean composition, a laptop on desk with warm light, blurred city lights bokeh in background, professional tech article cover style, no people, high detail; negative:text, watermark, logo, messy composition, clutter, lowres, blurry, cartoon, anime -

Kandinsky prompt:

Минималистичная фотореалистичная обложка: ноутбук на столе, тёплый свет, боке огней города на фоне, чистая композиция, профессиональный стиль, без людей, высокая детализация

Что увидел:

Kandinsky

-

У Kandinsky ноутбук выглядит реалистично, модель даже попыталась добавить отражение на экране, а фон даёт ожидаемое боке. При этом в моём варианте были мелкие нюансы: клавиатура почти не читается, а тень от ноутбука выглядит немного неестественно.

Stable Diffusion

-

У Stable Diffusion ноутбук и фон тоже получились аккуратно, и картинка воспринимается более “обложечно”: боке читается, а экран сделан нейтрально (без лишних деталей). Но у меня появилось ощущение, что геометрия сцены слегка “плывёт” — как будто стол или сам ноутбук немного изогнут. В общем случае это не критично для иллюстрации, но если присматриваться, заметно.

Если бы я дорабатывал этот сценарий дальше, то для Kandinsky я бы попробовал чуть точнее задавать “материальность” и контакт с поверхностью (например, уточнить тень/положение ноутбука), а для Stable Diffusion — контролировать геометрию (чтобы не появлялось ощущения “изгиба” стола/ноутбука). Но даже без тюнинга оба результата уже близки к формату “обложка для техстатьи”.

Вывод: в этом сценарии оба инструмента уже “из коробки” дают результат, близкий к обложке, но по разным причинам. Kandinsky выглядит выразительнее за счёт попытки добавить отражение/атмосферу кадра, однако может потребовать небольших уточнений, если важны тень и “материальность” предмета. Stable Diffusion лучше подходит, когда нужна максимально спокойная, нейтральная обложка без лишних деталей — но стоит контролировать геометрию, чтобы не появлялось ощущение “плывущего” стола или корпуса. В практическом пайплайне я бы выбирал инструмент по конкретной сцене: что важнее — выразительность или нейтральность.

Иллюстрации в стиле аниме:

«Аниме-постер: неоновая улица и дождь»

Что ожидалось: красивая атмосферная иллюстрация (постер/обложка/арт под пет-проект).

Промпты, которые я использовал для генерации картинок:

-

SD prompt:

masterpiece, high quality, anime illustration, full-body, young game developer, hoodie, headphones around neck, laptop in hand, rainy neon street at night, wet asphalt reflections, cinematic lighting, detailed eyes and hair, key visual poster; negative:lowres, blurry, bad anatomy, bad hands, extra limbs, deformed, text, watermark, logo, frame, nsfw -

Kandinsky prompt:

Аниме-иллюстрация высокого качества: персонаж в полный рост, молодой разработчик игр, худи, на шее наушники, в руке ноутбук, ночная дождливая улица с неоном, отражения на мокром асфальте, кинематографичный свет, детализированные глаза и волосы, постерный стиль

Что увидел:

Kandinsky

-

В версии Kandinsky картинка выглядит более цельной: персонаж проработан (лицо читается, пропорции выглядят уверенно), дождь воспринимается как дождь, а не как набор параллельных линий. Мне ещё понравилось, что модель справилась с деталью “ноутбук Apple”: логотип на крышке выглядит узнаваемо и не разваливается на артефакты, а на фоне много людей, при этом они не превращаются в “кашу” и не выбиваются из сцены.

Stable Diffusion

-

У Stable Diffusion в моём варианте как раз ломается атмосфера: освещение выглядит пересвеченным и перенасыщенным, дождь часто превращается в полосы, и из‑за этого картинка теряет реализм и настроение “ночной неоновой улицы”. Персонаж и фон тоже выглядят менее уверенно: детали заднего плана упрощаются, а общий стиль становится менее цельным.

Справедливости ради: подозреваю, что часть проблем Stable Diffusion тут лечится — подбором другого чекпоинта/LoRA и более жёстким негативом на “oversaturated/overexposed”, а дождь можно делать более правдоподобным через другой пайплайн (или постобработку). Но в этом сравнении я фиксировал дефолтный подход “вставил промпт → получил картинку”, потому что именно так чаще всего и происходит, когда картинка нужна быстро “под задачу”.

Вывод: для постерных аниме‑сцен Kandinsky в моём тесте оказался более надёжным “по первой попытке”: лучше держит атмосферу кадра и аккуратнее справляется с дождём, светом и насыщенным фоном. Такие сцены часто ломаются на пересвете/перенасыщенности и превращают дождь в “полосы” — именно это я чаще видел у Stable Diffusion на дефолтных настройках. При желании SD можно довести до сопоставимого качества, но это уже отдельная работа: подобрать модель/LoRA под нужный стиль и сильнее контролировать свет/насыщенность негативом.

«Динамика: тот же персонаж “бежит”»

Изменение было минимальным: я добавил в промпт слово «бежит».

Промпты, которые я использовал для генерации картинок:

-

SD prompt:

masterpiece, high quality, anime illustration, full-body, young game developer, hoodie, headphones around neck, laptop in hand, rainy neon street at night, wet asphalt reflections, running, cinematic lighting, detailed eyes and hair, key visual poster; negative:lowres, blurry, bad anatomy, bad hands, extra limbs, deformed, text, watermark, logo, frame, nsfw -

Kandinsky prompt:

Аниме-иллюстрация высокого качества: персонаж в полный рост, молодой разработчик игр, худи, на шее наушники, в руке ноутбук, ночная дождливая улица с неоном, отражения на мокром асфальте, бежит, кинематографичный свет, детализированные глаза и волосы, постерный стиль

Что увидел:

Kandinsky

-

Kandinsky на этом шаге генерацию не продолжил и предложил изменить описание; отказ произошёл из‑за минимального изменения промпта («бежит»). Это показывает, что в динамичных сценах результат может зависеть даже от небольших правок формулировки, и предсказуемость пайплайна снижается.

Stable Diffusion

-

В Stable Diffusion сцена действительно стала более “динамичной”, но качество в моём случае оказалось ниже ожидаемого: лицо получилось неестественным, цвета — перенасыщенными, дождь — неестественным, а фон — менее удачным. Дополнительно появились артефакты вроде “ауры” вокруг персонажа, руки выглядят недоработанными, а контакт с поверхностью (шаг в лужу) ощущается неестественным — как будто ноги и земля не согласованы по перспективе.

Вывод: Сценарии с действием оказались самыми “хрупкими”: либо качество результата заметно плавает даже при небольшом изменении промпта, либо инструмент может потребовать дополнительной переформулировки. Поэтому для таких задач лучше заранее закладывать больше итераций на промпт и проверку результата.

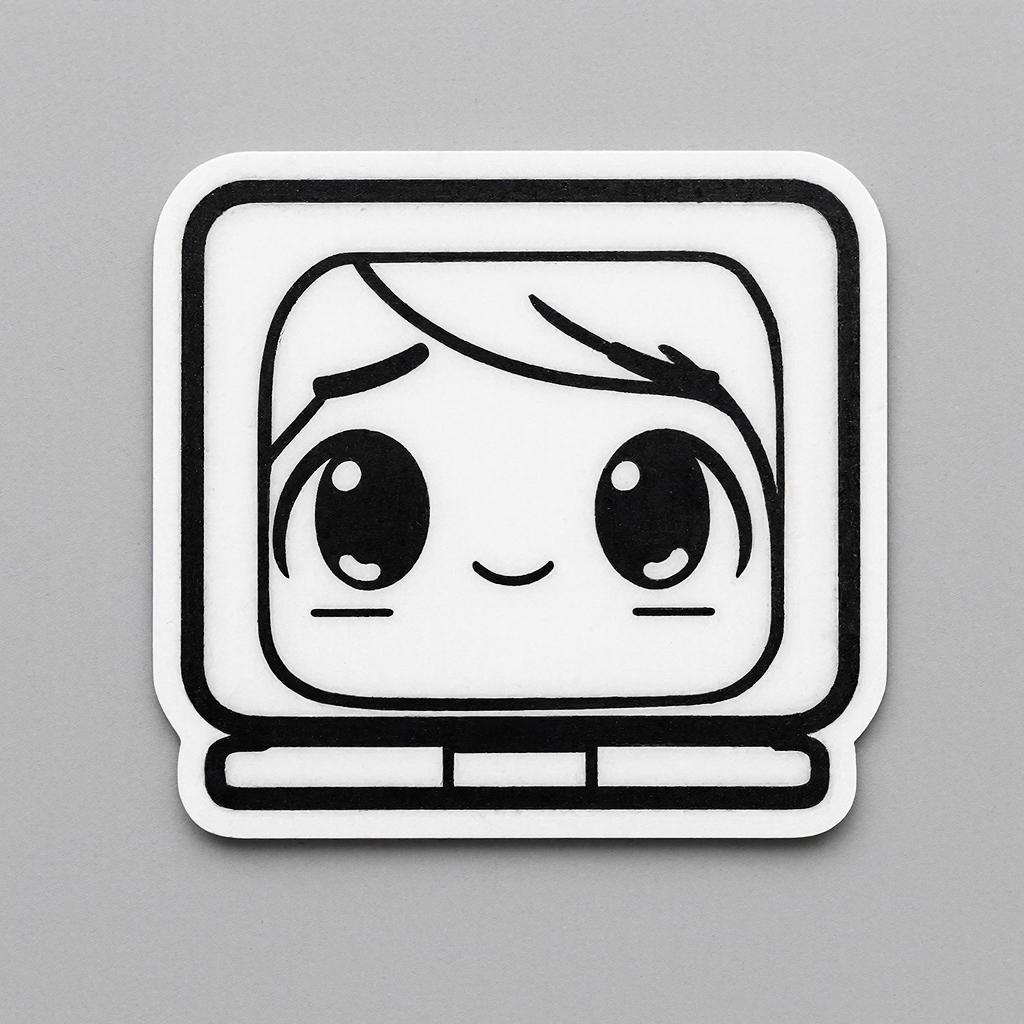

«Иконка/стикер: маскот-ноутбук»

Что ожидалось: простой милый маскот, чистая картинка под иконку/стикер/заглушку.

Промпты, которые я использовал для генерации картинок:

-

SD prompt:

high quality anime sticker icon, chibi style (slight), clean outline, cute laptop mascot, simple background, flat colors, vector-like, centered composition; negative:lowres, messy lines, blurry, watermark, logo, text, photorealistic -

Kandinsky prompt:

Аниме-стикер/иконка: милый маскот-ноутбук, чистый контур, простые плоские цвета, минималистичный фон, композиция по центру, квадратная картинка

Что увидел:

Kandinsky

-

В Kandinsky маскот получился аккуратным и “милым” без лишней возни: композиция читается, палитра у меня была спокойная (чёрно‑белая), и картинка выглядит как готовая заглушка под стикер/иконку.

Stable Diffusion

-

В Stable Diffusion в моём варианте идея уехала в сторону (получилось что-то вроде “панды на экране”), сам ноутбук выглядит менее удачно, а цвета снова слишком яркие. В результате картинка хуже подходит именно под “иконку/стикер”, потому что теряется читаемость и аккуратность формы.

Вывод: для задач “быстро сделать маскота/иконку” Kandinsky у меня чаще выдавал аккуратную читаемую форму и спокойную палитру, то есть результат ближе к “готовому ассету”. Для Stable Diffusion в таком формате важнее контроль простоты: чтобы идея не уезжала в лишние детали и не появлялась перенасыщенность — иначе картинка теряет читаемость в маленьком размере. Если планируется делать серию иконок в одном стиле, SD может быть удобен за счёт тонкой настройки, но на старте Kandinsky быстрее даёт понятный базовый вариант.

Что это значит на практике

В моих сценариях Kandinsky чаще давал “готовый к использованию” результат без дополнительных итераций — особенно в портретах, постерных иллюстрациях и иконках/стикерах.

В фотореалистичных сценах картина смешанная: в “разработчик и два монитора” Kandinsky лучше попал в смысл и детали, а в “обложке с ноутбуком и боке” оба инструмента дали близкий к нужному результат, но с разными компромиссами (у Kandinsky — более выразительная картинка, у SD — более нейтральная и предсказуемая “обложечность”).

Отдельно отмечу сценарии с динамикой: Stable Diffusion в моём тесте продолжал генерацию при минимальном изменении промпта, но качество результата могло быть ниже ожидаемого, а Kandinsky в одном из таких случаев попросил изменить описание и не продолжил генерацию.

Мини-чеклист по выбору:

-

Если нужен быстрый “красивый” результат и можно просто выбрать лучший из нескольких вариантов — Kandinsky часто удобнее.

-

Если важна устойчивость пайплайна (чтобы генерация почти всегда продолжалась) и есть готовность дольше тюнить промпт/негатив или менять модель — Stable Diffusion остаётся хорошим запасным вариантом.

-

Для обложек, где критична нейтральность и отсутствие неожиданных деталей, имеет смысл отдельно проверять “чистоту” кадра (текст/артефакты/геометрию) и выбирать инструмент по результату конкретной сцены, а не “в целом”.

Автор: Efrosim123