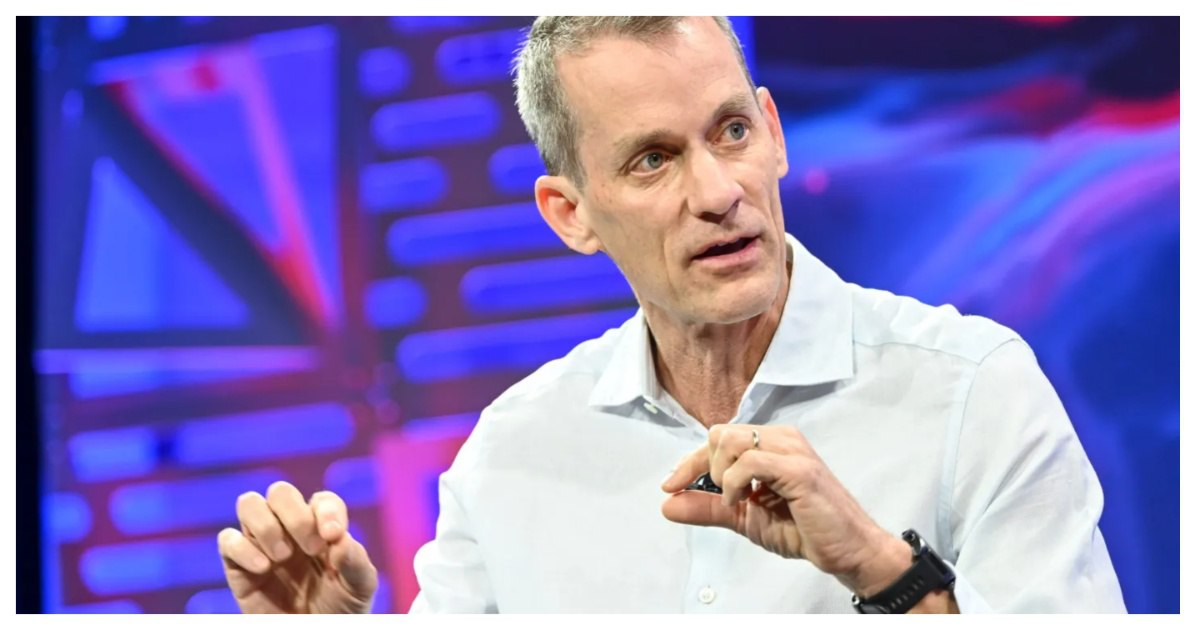

Легендарный инженер Google Jeff Dean, один из архитекторов инфраструктуры ИИ компании, рассказал на встрече Stanford AI Club историю возникновения Tensor Processing Units (TPU) – собственных специализированных чипов Google для машинного обучения. Эта история началась с простой, но ключевой проблемы, с которой столкнулась компания ещё в середине 2010‑х годов: как масштабировать высококачественное распознавание речи для миллионов пользователей.

По словам Дина, команда создала модель для распознавания речи с заметно более низким уровнем ошибок, чем существующая система. Но когда он посчитал, сколько вычислительных ресурсов потребуется, чтобы обслужить сотни миллионов пользователей, использующих эту модель всего по три минуты в день, стало ясно, что обойтись существующими CPU в дата‑центрах Google невозможно. Для такой нагрузки пришлось бы удвоить число серверов, что было бы крайне неэффективно и дорого.

Это осознание подтолкнуло Google к мысли о необходимости специализированного оборудования. Neural сети для задач машинного обучения, включая распознавание речи, построены на линейной алгебре: матричных умножениях и векторных операциях. Их можно выполнять с меньшей точностью, чем в классических CPU, но многократно быстрее, если использовать специализированный дизайн. Именно так родилась идея Tensor Processing Unit – чипа, ориентированного на эффективное выполнение операций с низкой точностью, характерных для ИИ‑вычислений.

TPU v1, разработанный Google и развернутый в 2015 году, был на порядок быстрее и эффективнее существовавших CPU и GPU: он показывал от 15 до 30 раз более высокую скорость и от 30 до 80 раз лучшую энергоэффективность в задачах инференса ИИ по сравнению с традиционными решениями того времени. Этот успех был настолько значительным, что статья о первых TPU стала одной из самых цитируемых на конференции ISCA в 2017 году, а сама технология быстро стала основой вычислительной инфраструктуры Google для ИИ.

Решение создать TPU изначально было прагматичным: задача масштабного распознавания речи требовала ресурсов, которые было невозможно предоставить с помощью стандартного железа. Но со временем этот шаг превратился в стратегическое преимущество Google. Собственные чипы позволили компании поддерживать собственные модели ИИ без зависимости от сторонних производителей процессоров и ускорителей, а сама концепция ASIC‑акселераторов для ИИ стала стандартом в индустрии, – крупные технологические игроки, включая Amazon и Microsoft, начали развивать свои собственные аппаратные решения для ИИ.

Таким образом, простой расчёт потребности в вычислительной мощности для одной функции распознавания речи на миллионы пользователей привёл к десятилетию развития собственных чипов Google и сформировал основу инфраструктуры, на которой сегодня обучаются и запускаются крупнейшие модели компании.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn