IQuestCoder-40B – это специализированная модель для генерации кода. Не очередной чат-бот, а инструмент, заточенный именно под программирование. Эта модель сочетает в себе мощь 40 миллиардов параметров с уникальной рекуррентной архитектурой Loop, которая кардинально отличается от классических трансформерных решений.

Loop-архитектура использует двухитерационный механизм прохода через 80 слоев, что позволяет модели эффективно перерабатывать информацию, не жертвуя производительностью. Такой подход оптимизирует баланс между вычислительной мощностью и скоростью развёртывания, что делает модель особенно привлекательной для коммерческого и инженерного применения.

Одним из главных преимуществ данной архитектуры является способность сохранять контекстуальную целостность даже при работе с длинными последовательностями. Благодаря рекуррентной структуре, модель способна «помнить» предыдущие шаги выполнения, что критично при решении сложных задач, требующих многоэтапного анализа.

Ключевые технические особенности

-

Нативная поддержка контекста до 128K токенов – позволяет обрабатывать огромные файлы, целые проекты и сложные архитектуры без разбивки.

-

Grouped Query Attention – улучшает скорость генерации и снижает нагрузку на память, сохраняя при этом качество внимания.

-

Увеличенный словарь из 76 800 токенов – обеспечивает более точное кодирование редких символов, идентификаторов и специфичных конструкций языков программирования.

-

Специализация на инструкциях – модель тонко настроена под выполнение пользовательских команд, что делает ее идеальной для интеграции в IDE и CI/CD-пайплайны.

Эти характеристики делают IQuest-Coder-V1-40B-Loop-Instruct не просто еще одной LLM для написания кода, а полноценным агентом разработки, способным работать в условиях реального цикла разработки программного обеспечения.

Обучение по принципу code-flow: как модель думает как настоящий разработчик

Традиционные модели обучаются на статических срезах кода – файлах, репозиториях, примерах из GitHub. IQuest-Coder-V1-40B-Loop-Instruct пошла дальше: ее обучение строилось на основе динамических изменений в коде. Метод Code-Flow позволяет модели понимать не только что написано, но и как это изменялось с течением времени.

Обучение проводилось на: истории коммитов в репозиториях, паттернах рефакторинга кода, циклах исправления багов и добавления фич, эволюции архитектуры проектов. Такой подход дает модели уникальное преимущество: она начинает думать, понимая, зачем были сделаны те или иные изменения, какие ошибки типичны, и как разработчики реагируют на требования.

Практические преимущества подхода

-

Лучшее понимание требований к коду

-

Умение предложить логичные правки, соответствующие стилю проекта

-

Способность к рефакторингу без потери функциональности

-

Автоматическое исправление багов с учетом истории изменений

Модель обучалась на эволюции реальных open-source проектов, что позволило ей выйти за рамки шаблонного программирования и начать генерировать код, который естественно встраивается в существующую кодовую базу.

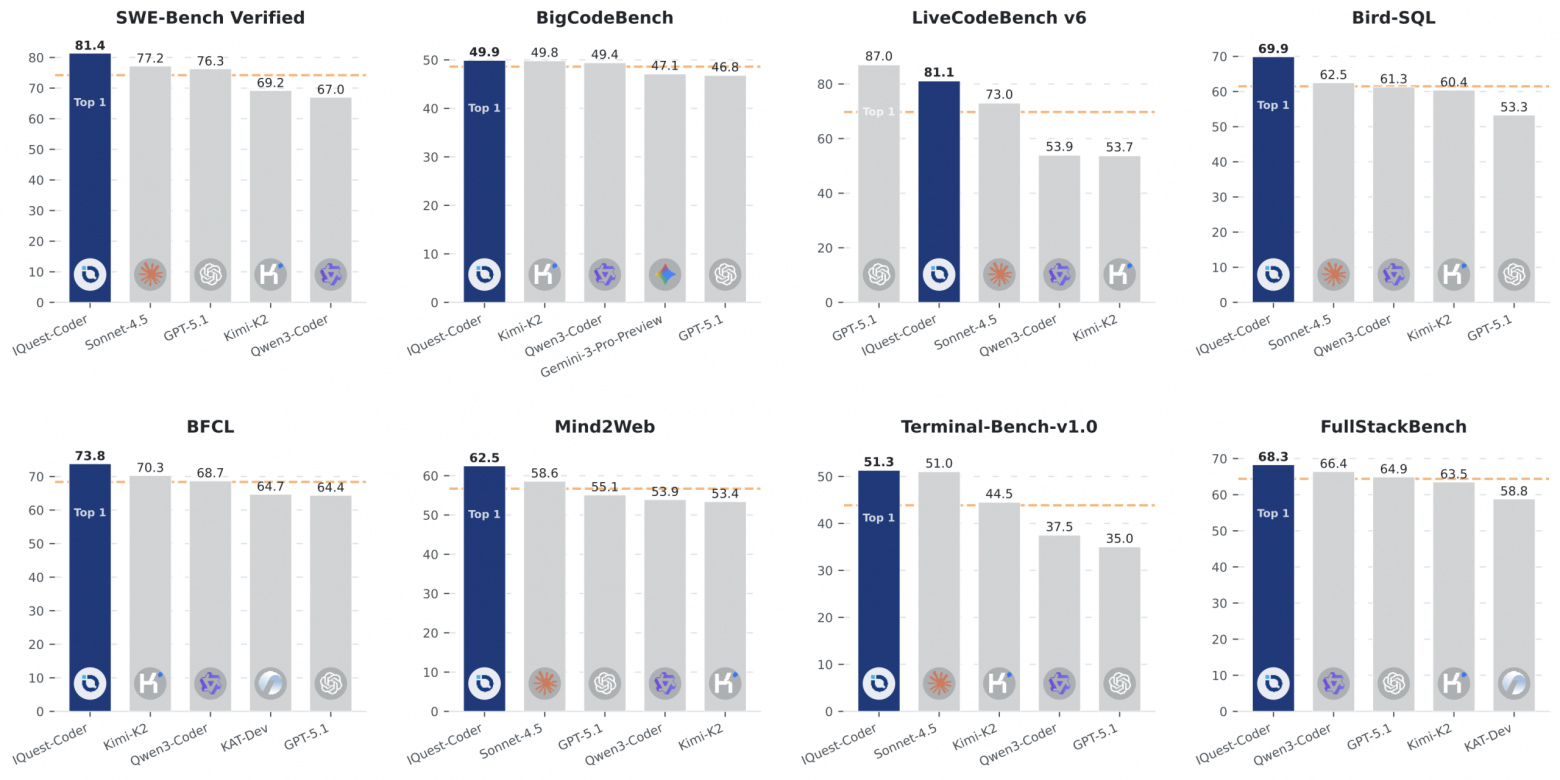

Производительность на бенчмарках: доказанная эффективность

IQuest-Coder-V1-40B-Loop-Instruct показывает впечатляющие результаты в независимых тестах, подтверждающих её лидирующие позиции в области генерации и анализа кода.

Результаты тестирования:

-

SWE-Bench Verified: 81.4% – модель успешно решает реальные задачи инженерных команд, включая исправление ошибок, рефакторинг и интеграцию новых функций в сложные проекты.

-

BigCodeBench: 49.9% – результат в топе среди моделей с аналогичным числом параметров, особенно в задачах с высокой логической сложностью.

-

LiveCodeBench v6: 81.1% – актуальные данные на 2026 год показывают, что модель уверенно работает с современными фреймворками, инструментами и стандартами.

Эти показатели свидетельствуют о том, что модель не просто знает синтаксис, а может эффективно заменять или дополнять работу реальных разработчиков.

Работа с моделью: как достичь лучших результатов

Для максимальной производительности рекомендуется использовать следующие параметры генерации:

-

Temperature: 0.6 – баланс между креативностью и предсказуемостью

-

TopP: 0.85 – устойчивый выбор наиболее вероятных токенов

-

TopK: 20 – фильтрация маловероятных вариантов

Модель полностью совместима с vLLM, что позволяет: развертывать ее на собственных серверах, создавать OpenAI-совместимые API-эндпоинты и интегрировать в существующие dev-инструменты и платформы

Модель есть на Hugging Face и GitHub.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссы��ке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: MrRjxrby