Внезапно, но факт: свежая MiniMax-M2 от китайской команды MiniMaxAI догнала Grok 4 Fast и Gemini 2.5 Pro. MoE-модель с всего 10B активных параметров обошла многих топ-игроков — от Claude до Gemini и GLM.

MiniMax-M2 — это компактная, но безумно мощная система, созданная специально для кода и агентов.

Что умеет MiniMax-M2:

-

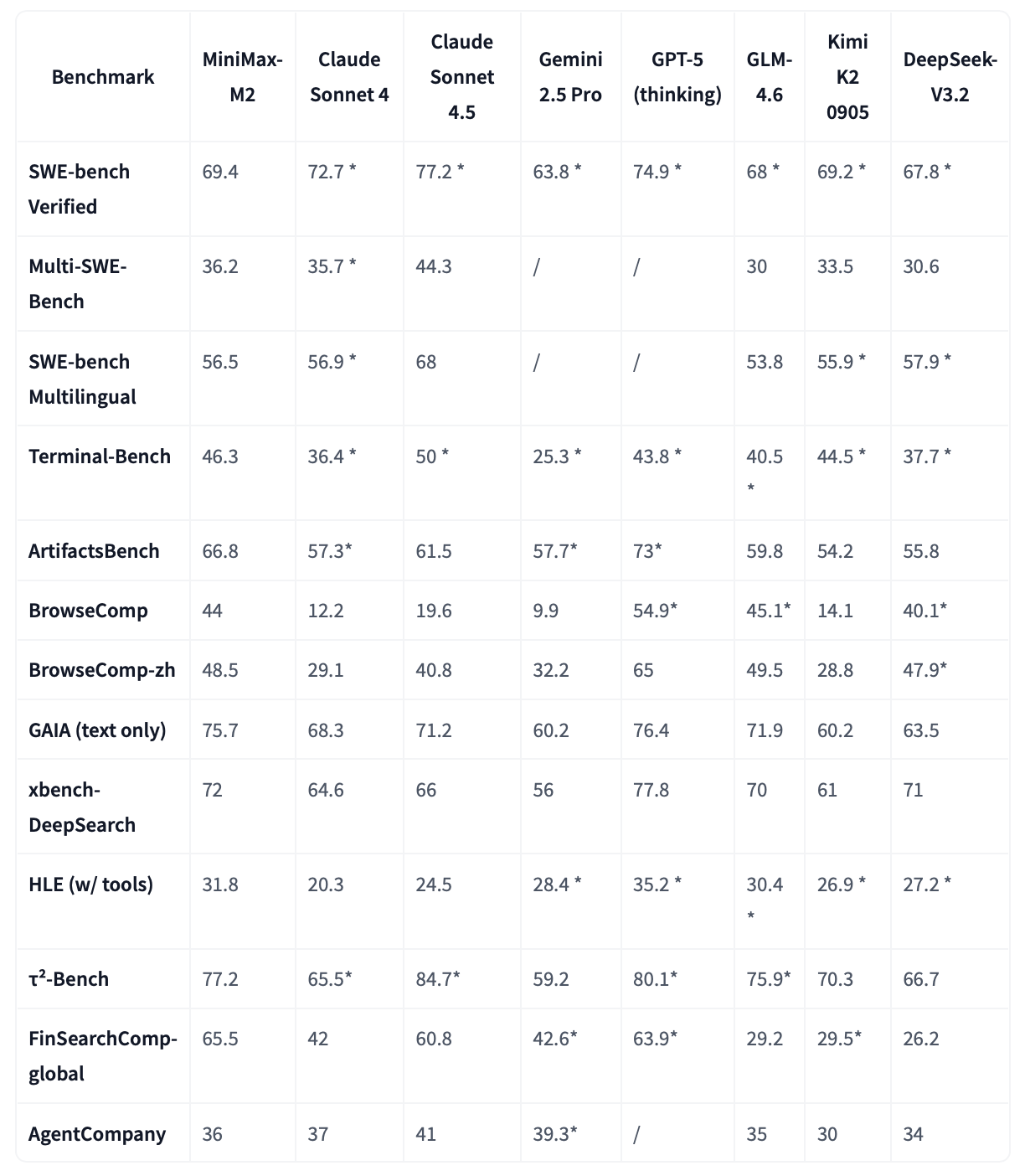

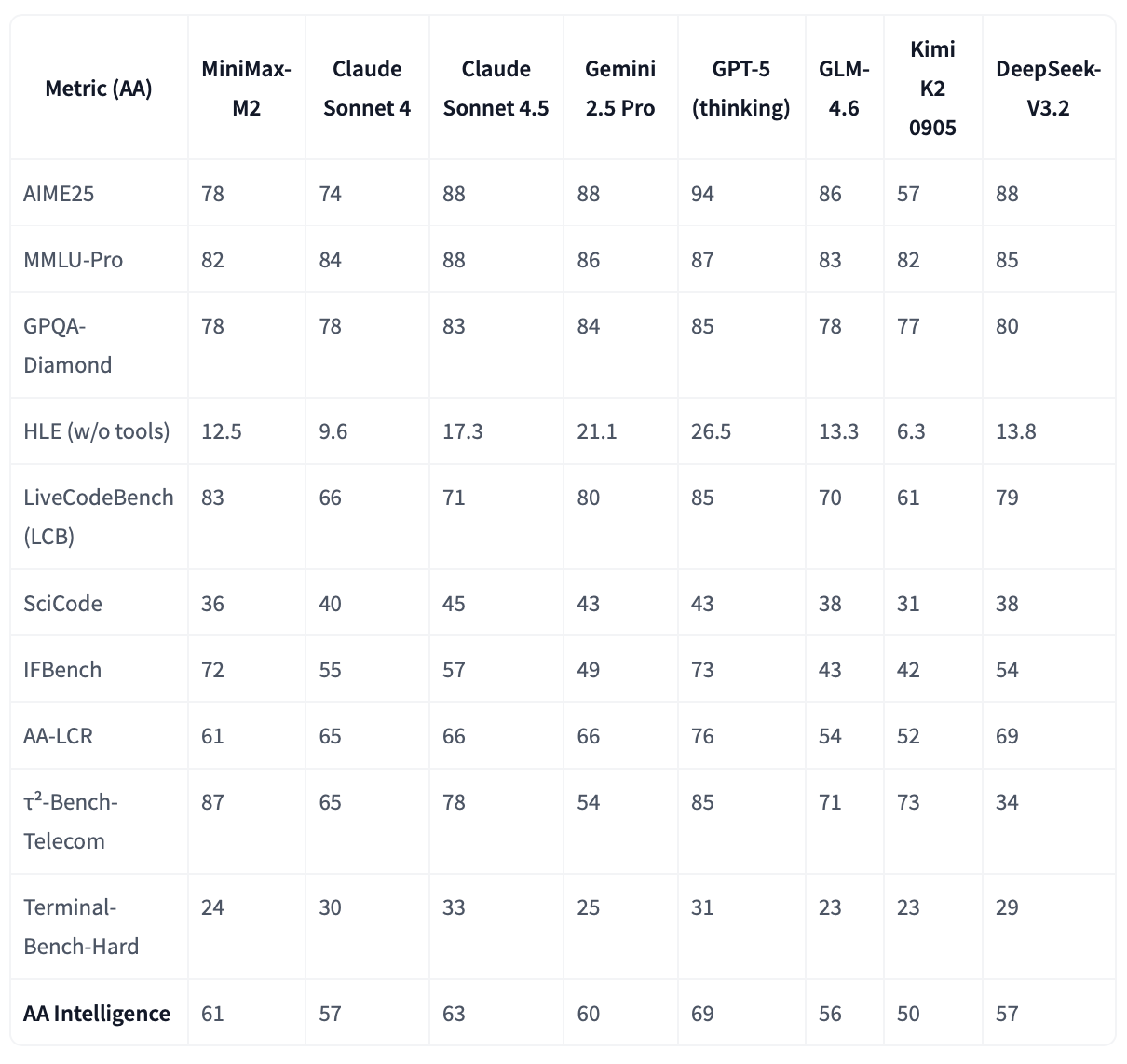

Интеллект: #1 среди open-source моделей по метрике Artificial Analysis Intelligence — обходит даже DeepSeek и Kimi.

-

Кодинг: Лучшие результаты в SWE-Bench, Terminal-Bench и ArtifactsBench — превосходит Claude 4 и Gemini 2.5 Pro.

-

Агентность: В BrowseComp-тестах M2 находит скрытые источники, планирует цепочки действий и хорошо разбирается в ошибках.

-

Эффективность: Всего 10B активных параметров → низкие задержки, высокая пропускная способность и дёшево в проде.

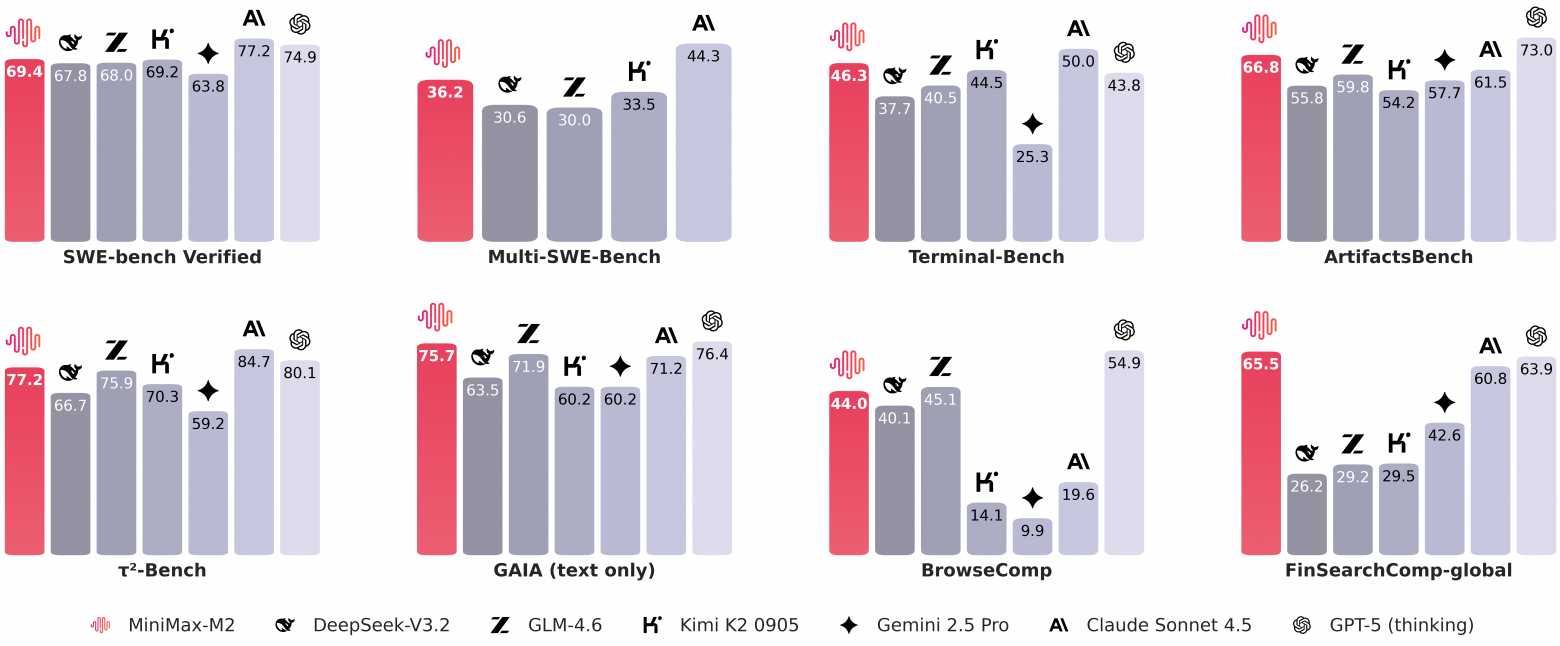

В сравнении с топовыми гигантскими моделями:

-

SWE-Bench Verified: 69.4 против 63.8 у Gemini 2.5 Pro

-

Terminal-Bench: 46.3 против 36.4 у Claude 4

-

BrowseComp: 44 против 19.6 у Claude 4.5

-

GAIA (text only): 75.7 против 60.2 у Gemini

Да, GPT-5 всё ещё впереди — но MiniMax-M2 догоняет, оставаясь open source.

Русскоязычное сообщество про AI в разработке

Друзья! Эту новость подготовила команда ТГК «AI for Devs» — канала, где мы рассказываем про AI-ассистентов, плагины для IDE, делимся практическими кейсами и свежими новостями из мира ИИ. Подписывайтесь, чтобы быть в курсе и ничего не упустить!

Автор: python_leader