Всё чаще аналитики бизнес-процессов используют LLM для поиска неэффективностей. Звучит логично: большие языковые модели умеют искать паттерны, а Process Mining как раз об этом. Но на практике результаты пляшут так, что становится понятно: не все LLM одинаково полезны для операционной аналитики. Решил разработать методологию тестирования LLM на предмет релевантности использования для задач анализа процессов.

Было подготовлено три теста, имитирующих реальные сценарии анализа:

Тест 1. Сырой лог событий.

Сгенерировал журнал в классическом формате: id экземпляра процесса, название этапа, временная метка завершения. Всего 20,5 тысяч записей, 1,6 тысячи экземпляров процесса. Внутри спрятал 200 типовых аномалий: зацикливания, bottle neck, избыточные этапы и т.д. Модель получала таблицу «как есть» – без подсказок и форматирования. Оценка: +1 балл за верно найденный кейс, -0,25 за ложное срабатывание. Итог рассчитывался как процент от максимально возможных 200 баллов. Если модель трижды молчала или выдавала «всё идеально» или какую-то ерунду, то стравился ноль.

Тест 2. Регламент с шумом.

Текстовый документ с описанием процесса: этапы, роли, условия переходов. Но также там было добавлено и много “воды” слабо относящейся к самому процессу. К этом тексте “регламенте” было спрятано 100 неэффективностей. Та же система баллов, рассчитывалась доля найдыных кейсов, за галюцинирование штрафы по минус 0,25 балла за каждую галюцинацию.

Тест 3. Визуальная схема.

PNG с диаграммой BPMN: 20 блоков, около сотни переходов. На схеме было 20 логических ошибок: циклы без условия выхода, неиспользуемые шлюзы, избыточные маршруты, повисшие этапы и т.д.. Проверял, система оценки таже +1 балл за найденный кейс, -0,25 балла за глюс, и считался процент от всех спятаных проблем.

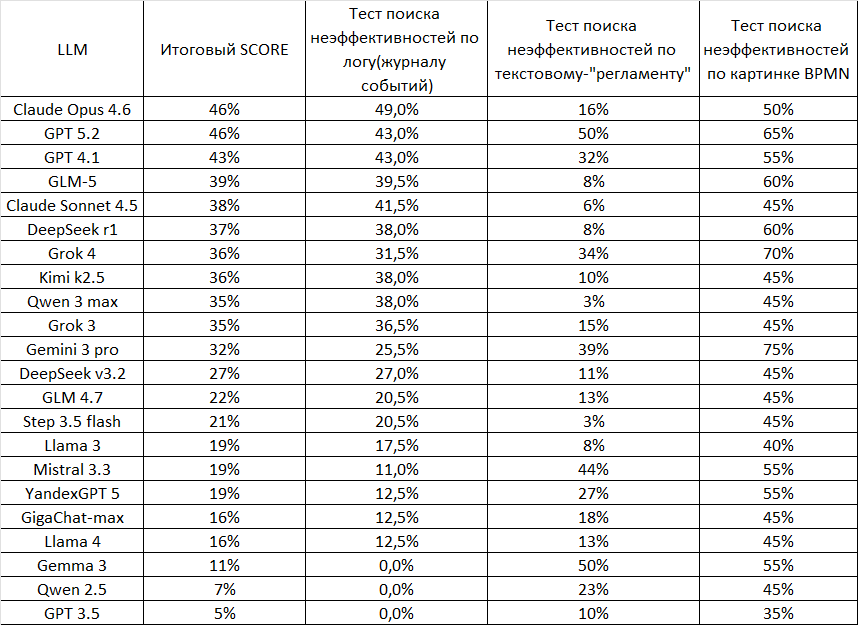

Финальный скор считался с весами: 80% – анализ лога(таблица с журналом событий) , 10% – текст-“регламент”, 10% – картинка с BPMN.

Результаты немного опечалили, что в целом было предсказуемо.

Больше 46% суммарного скора не набрал никто. Лучший результат у Claude Opus 4.6 он лучше всех справился с логами , хорошо справился картинкой, но на удивление мало нашел в кейсе с текстом. На втором и третьем месте GPT-5.2 и GPT-4.1. По анализу логов они дали примерно одинаковый результат, но GPT-5.2 в полтора раза лучше проанализировала текст, и это был лучший результат по анализу текста из всех LLM, и несколько лучше, чем GPT-4.1 сработала с картинко-схемой. Картинку лучше всех проанализировала Gemini 3 pro, однако она почти в два раза меньше, чем лидер, нашла кейсов в сыром логе. Очень необычный результат показал DeepSeek, более старая версия DeepSeek-r1 оказалась почти в полтора раза лучше, чем DeepSeek-v3.2. На данный момент объяснения этому я найти не могу, хотя тест перепроверял дважды. Самое большое число несуществующих кейсов находила Llama4, хотя это тоже немного странно, т.к., насколько я знаю, дефолтовая температура у ней не очень высокая. Худшие результаты показали: Gemma 3, Qwen 2.5 и GPT-3.5. Они либо ничего не находили, либо выдавали то, чего нет, либо вообще отвечали не то, что их вообще просят.

Что по итогу?

Я рекомендую для задач процессной аналитики использовать Claude Opus 4.6, если возможна работа по API, или GLM-5 если разворачиваете модель у себя. В дальнейшем я планирую регулярно тестировать новые LLM, которые будут появляться и, кто знает, возможно однажды результаты достигнут 100%

Автор: MarkGermes