В конце января 2025 года фондовый рынок США потерял свыше 1 трлн $. Особенно пострадала NVIDIA, чьи акции упали сразу на 17%, снизив капитализацию компании на 600 млрд $. О причине на Хабре писали: китайский стартап DeepSeek представил модель R1. Она стала полноценным конкурентом для o1 от OpenAI и других известных моделей.

Компания заявила, что обучение DeepSeek R1 с 685 млрд параметров потребовало всего 2 048 ИИ-ускорителей NVIDIA H800 и обошлось в 5,6 млн $. Инвесторы задались вопросом: действительно ли нужно вкладывать миллиарды в разработку искусственного интеллекта или можно обойтись значительно меньшими вливаниями? Эти колебания вкупе с «вау-эффектом» и обрушили фондовый рынок. Сейчас появилась информация о том, что, возможно, китайцы потратили не миллионы долларов, а больше двух миллиардов. Об этом и поговорим.

Что за миллиард, почему так много?

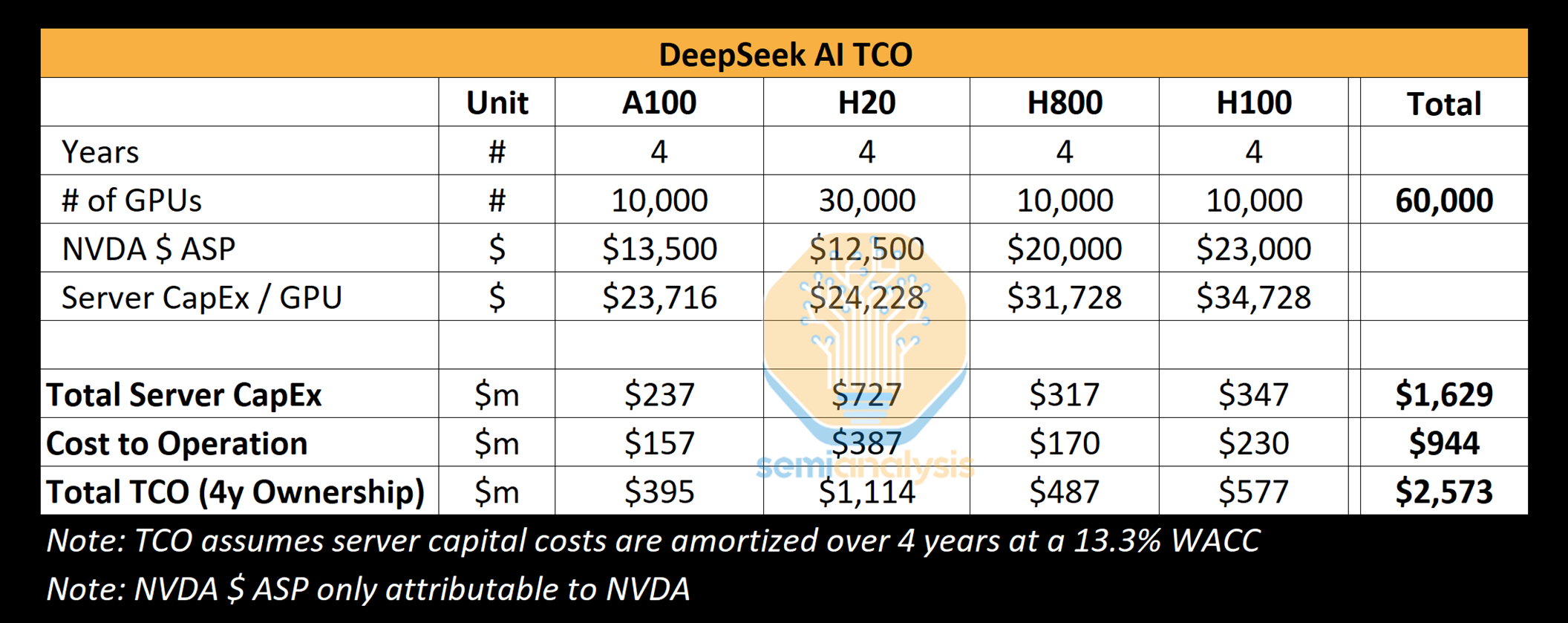

Аналитическая компания SemiAnalysis провела исследование и прокомментировала, что фактические затраты DeepSeek только на оборудование, возможно, составили не менее 1,6 млрд $. Еще она рассказала, что у китайцев не пара-тройка тыс. производительных чипов, а свыше 50 тыс. дорогущих графических процессоров Nvidia Hopper. Все это требует проверки, но, если данные реальны, никакой финансовой революции в обучении больших моделей не произошло.

Теперь по поводу вычислительных мощностей. Оказалось, что у DeepSeek масштабная инфраструктура со множеством серверов и современных графических адаптеров. В распоряжении компании 10 тыс. моделей H800 и 10 тыс. H100 плюс процессоры H20. О первых двух на Хабре много раз писали. Что касается последнего, то это специализированный чип, разработанный компанией NVIDIA для китайского рынка, чтобы соответствовать экспортным ограничениям США.

Мощности распределены по нескольким центрам обработки данных и задействуются для обучения ИИ, исследований и финансового моделирования. Общие капиталовложения в серверное оборудование оцениваются в 1,6 млрд $, а операционные расходы достигают 944 млн $. То есть освоен бюджет в 2,5 млрд. Никакого праздника сюрприза.

Что насчет заявления о стоимости обучения последней модели всего в 5,6 млн $? Именно оно вызвало большой ажиотаж. Информация правдива, но только отчасти. Судя по всему, озвученная сумма касается лишь стоимости аренды видеокарт для предварительного обучения модели и не учитывает затраты на исследования, доработку модели, обработку данных и всю инфраструктуру в целом. В реальности DeepSeek только на развитие своих моделей могла вложить больше 500 млн $ с момента основания. А ведь еще нужно было закупить оборудование, развернуть инфраструктуру, нанять специалистов и так далее.

Откуда взялась эта компания

Для большинства из нас весь этот ажиотаж выглядел как стартап из ниоткуда с обученной современной языковой моделью, минимальными вложениями и скудными вычислительными мощностями. На самом деле DeepSeek — детище китайского хедж-фонда High-Flyer. Пару лет назад он начал использовать ИИ в своей работе, параллельно занимаясь инвестициями в отрасль. В 2023 году High-Flyer выделил DeepSeek в отдельную компанию, задачей которой стала исключительно разработка ИИ-технологий. Ее преимуществом стал минимум бюрократических процессов и согласований на разных уровнях.

Ключевая особенность DeepSeek — владение мощными центрами обработки данных. Многие другие компании из ИИ-отрасли полагаются на облачные сервисы партнеров, а не собственную инфраструктуру. Это важно, поскольку стартап из Поднебесной может полностью контролировать эксперименты и оптимизацию моделей. Такой подход ускоряет процесс разработки, ведь нет не только внутренних, но и внешних ограничений, обычных для других игроков ИИ-рынка.

Что еще?

Важная для всей этой истории особенность DeepSeek — специфическая стратегия найма персонала. Компания привлекает специалистов исключительно из материкового Китая, не приглашая сотрудников из Тайваня или США. По данным SemiAnalysis, DeepSeek делает упор на реальные навыки и способность решать задачи, HR китайцев не слишком волнует формальное образование. Если ты специалист, то тебя возьмут.

Сотрудников с академическим бэкграундом тоже немало. Компания нанимает выпускников таких престижных вузов, как Пекинский и Чжэцзянский университеты, предлагая им высококонкурентные зарплаты. Некоторые сотрудники DeepSeek зарабатывают свыше 1,3 млн $ в год — это больше, чем в других ведущих китайских компаниях вроде Moonshot.

Благодаря притоку талантов DeepSeek смогла оперативно разработать ключевые для себя технологии, такие как Multi-Head Latent Attention (MLA). На это потребовались месяцы исследований и значительные вычислительные мощности. MLA крайне важна для ИИ — это механизм внимания, который улучшает обработку данных в моделях машинного обучения, особенно в задачах обработки естественного языка. Такой подход увеличивает производительность модели без необходимости масштабного расширения объема вычислительных ресурсов.

Компания делает ставку на эффективность алгоритмов, оптимизацию и программные усовершенствования, а не на постоянные закупки оборудования.

Недостатки тоже есть

Исследователи из Cisco и Университета Пенсильвании прогнали модель DeepSeek R1 по 50 потенциально опасным командам. Специалисты протестировали DeepSeek R1 с использованием набора данных HarmBench. Это 400 сценариев вредоносного поведения в 7 разных категориях, включая киберпреступность, распространение дезинформации и другие незаконные действия.

Результаты не очень. Система не смогла заблокировать ни один из них. Для сравнения, другие модели, например GPT-4o, Google Gemini и Claude 3.5, блокируют от 14% до 74% подобных атак. Это ставит под сомнение эффективность защитных механизмов DeepSeek R1, особенно учитывая заявленные низкие затраты на разработку по сравнению с западными аналогами.

А недавно специалисты по кибербезопасности из компании Wiz обнаружили, что китайский стартап DeepSeek оставил без защиты одну из своих баз данных. Это привело к утечке более миллиона записей, включая системные логи, пользовательские запросы и API-ключи. Уязвимость позволяла получить доступ к внутренним ресурсам компании. После уведомления от Wiz DeepSeek оперативно решила проблему.

В любом случае китайцы молодцы. Технология, несмотря на недостатки, действительно впечатляет. Наделать столько шуму со своим проектом — это надо уметь.

Автор: BiktorSergeev