Я — Андрей, технологический предприниматель и консультант по ИИ. Февраль продолжает радовать нас выдающимися исследованиями в области искусственного интеллекта.

В этой статье я собрал для вас десять захватывающих работ, которые показывают, как большие языковые модели заранее планируют свои ответы, почему иногда приходится заставлять ИИ забывать приобретенные знания. Мы обсудим, как ИИ-ученые делают открытия и как декодировать мысли в текст напрямую из мозга без специальных чипов. А также узнаем как с помощью нейросетей симулировать финансовые рынки, может ли ИИ заработать миллион на фрилансе, и поговорим о рисках, которые несут суперинтеллектуальные агенты.

Если хотите быть в курсе новейших исследований в области искусственного интеллекта, воспользуйтесь Dataist AI — бесплатным ботом, ежедневно обозревающим свежие научные публикации.

А также подписывайтесь на мой Telegram-канал, где я делюсь инсайтами из ИИ-индустрии, советами по внедрению ИИ в бизнес и разработке ИИ-стартапов, а также комментирую важнейшие новости и события.

1. OpenAI o3-mini System Card

Начнем с работы от OpenAI, которая описывает техническую составляющую o3-mini. Компания называет o3 существенным шагом в сторону AGI. Хотя полная модель пока не вышла, зато OpenAI выпустили «облегченную» версию o3-mini. Почему o3, а не o2 после o1? Пропуск номера связан с торговыми марками (британский оператор связи O2), о чем намекнул Сэм Альтман.

Модель обучалась с использованием масштабного обучения с подкреплением, в основе которого лежит цепочка рассуждений (chain-of-thought). Этот подход позволяет модели «подумать» перед тем, как дать ответ, что помогает не только улучшить точность, но и повысить устойчивость к небезопасному контенту.

В итоге o3 может рассуждать о задаче и планировать ряд действий, которые помогают ей найти решение, «объясняя» свои рассуждения по ходу работы. Через некоторое время модель суммирует то, что она считает наиболее точным ответом. Это немного увеличивает задержку в ответе, но повышает точность решения в том числе научных задач.

Впервые в линейке рассуждающих моделей OpenAI реализовала три уровня сложности рассуждений — низкий, средний и высокий. В зависимости от уровня запроса и требуемой точности разработчик может либо сэкономить на токенах и времени отклика, либо максимально усилить логику решения.

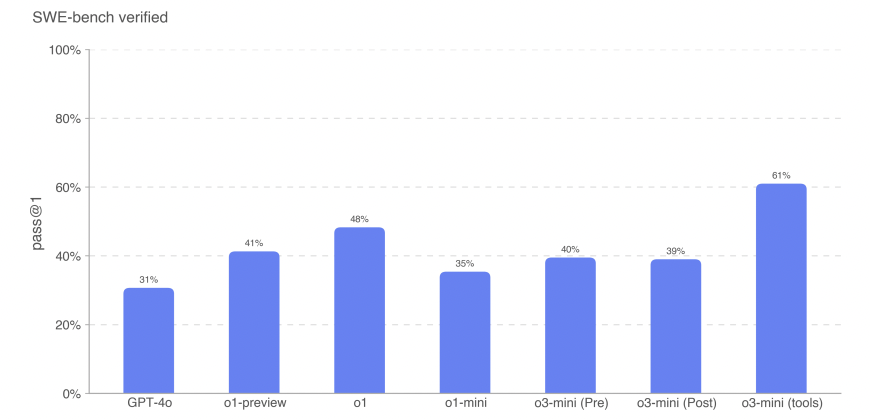

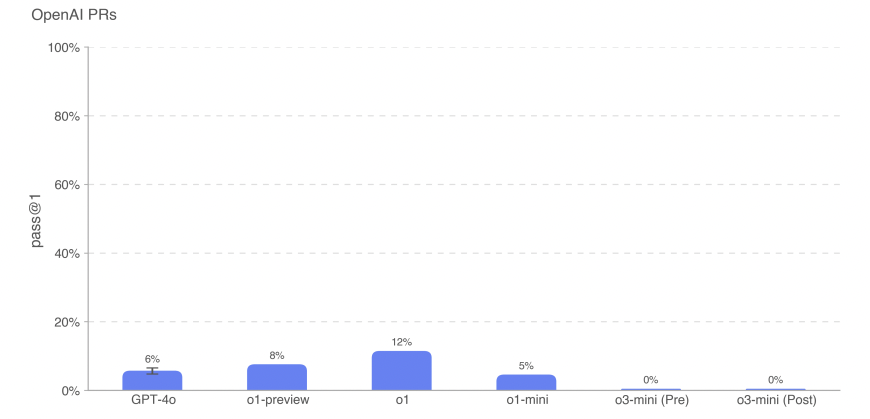

По оценкам OpenAI, на некоторых тестах модель вплотную приближается к AGI. Например, на бенчмарке ARC-AGI она показала 87,5% при максимальной вычислительной нагрузке. А на задачах SWE-bench (автоматизации работы с GitHub с использованием инструментов) o3-mini достигает 61%. Гонка к AGI выходит на новый уровень.

o3 показывает впечатляющие результаты в математике, программировании (2727 баллов Codeforces) и ряде научных тестов. o3-mini на 24% быстрее предшественницы o1-mini и обходится дешевле примерно на 63%. Это делает новую модель более выгодной в использовании, учитывая ее высокие «когнитивные» способности. При тестировании на галлюцинации (PersonQA) o3-mini достигла галлюцинационного показателя в 14.8% (при этом GPT-4o – 52.4%, а o1-mini – 27.4%), что является значительным улучшением.

Разработчики добавили механизм обоснованного соответствия (deliberative alignment), при котором модель явно анализирует инструкции по безопасности перед выдачей ответа. В итоге модель o3-mini показала высокую устойчивость к jailbreak-атакам (показатель StrongReject = 0.73).

Модель демонстрирует низкий уровень явной дискриминации, а в задачах убеждения и аргументации модель достигла уровня, сопоставимого с GPT-4o (80–90-й процентиль относительно человеческих ответов), у нее довольно хорошая многоязычная компетентность (результаты 0.82–0.83 по тестам MMLU на 14 языках), но неоднозначные результаты по автономности: успешно решает задачи программирования (pass@1 до 61%), но испытывает сложности в автоматизации pull-request’ов (PRs).

Модель o3-mini в среднем быстрее и дешевле, чем o1, сохраняя при этом близкий уровень точности в STEM-задачах (задачи из науки, технологий, инжиниринга и математике), а опция выбора уровня рассуждений дает возможность адаптировать модель под конкретную загрузку и качество вывода. Для стандартных бытовых запросов o1 может быть избыточен, тогда как o3-mini medium покрывает большинство типовых задач.

В сравнении с DeepSeek-R1, o3-mini заметно дороже (около $0.14 за миллион входных токенов у R1 против $1.10 у o3-mini), также R1 имеет открытую лицензию MIT. Это делает R1 привлекательным для исследователей и команд, которым важна кастомизация и локальное размещение. • AIME (генерация кода): победитель o3-mini-high с 87.3% (R1 имеет 79.8%) • GPQA (набор из 448 вопросов по биологии, физике и химии уровня PhD): победитель o3-mini-high с 79.7% (R1 имеет 71.5%) • Codeforces (соревновательное программирование): победитель o3-mini-high с 2130 (R1 имеет 2029) • SWE (инженерные задачи): победитель o3-mini-high с 49.3% (R1 имеет 49.2%) • MMLU (задачи на понимание языка): победитель DeepSeek R1 с 90.8% (o3-mini-high имеет 86.9%) • Math (математические задачи): победитель o3-mini-high с 97.9% (R1 имеет 97.3%) • SimpleQA (простые вопросы и ответы): победитель: DeepSeek R1 с 30.1% (o3-mini-high имеет 13.8%) Итого o3 с высоким уровнем рассуждений выигрывает DeepSeek-R1 в пяти из семи бенчмарков. Однако DeepSeek-R1 является значительно менее безопасной по сравнению с o3-mini в тесте ASTRAL. DeepSeek-R1 дала небезопасный ответ на 11,98% выполненных запросов, в то время как o3-mini — лишь на 1,19%. Выбор между моделями зависит от конкретных потребностей: для глубокого анализа с прозрачностью рассуждений R1 может быть привлекательнее, в то время как для стабильных, масштабируемых решений в продакшене o3-mini выглядит более оптимальным вариантом.Сравнение OpenAI o3-mini с DeepSeek R1

2. Emergent Response Planning in LLM

Традиционно считалось, что большие языковые модели (LLM) работают пошагово, предсказывая каждый следующий токен. Однако новое исследование от Шанхайской ИИ-лаборатории выявило феномен «эмерджентного планирования». Согласно исследованию, внутренние активации, скрытые от пользователей, содержат информацию о глобальных характеристиках ещё не сформированного ответа.

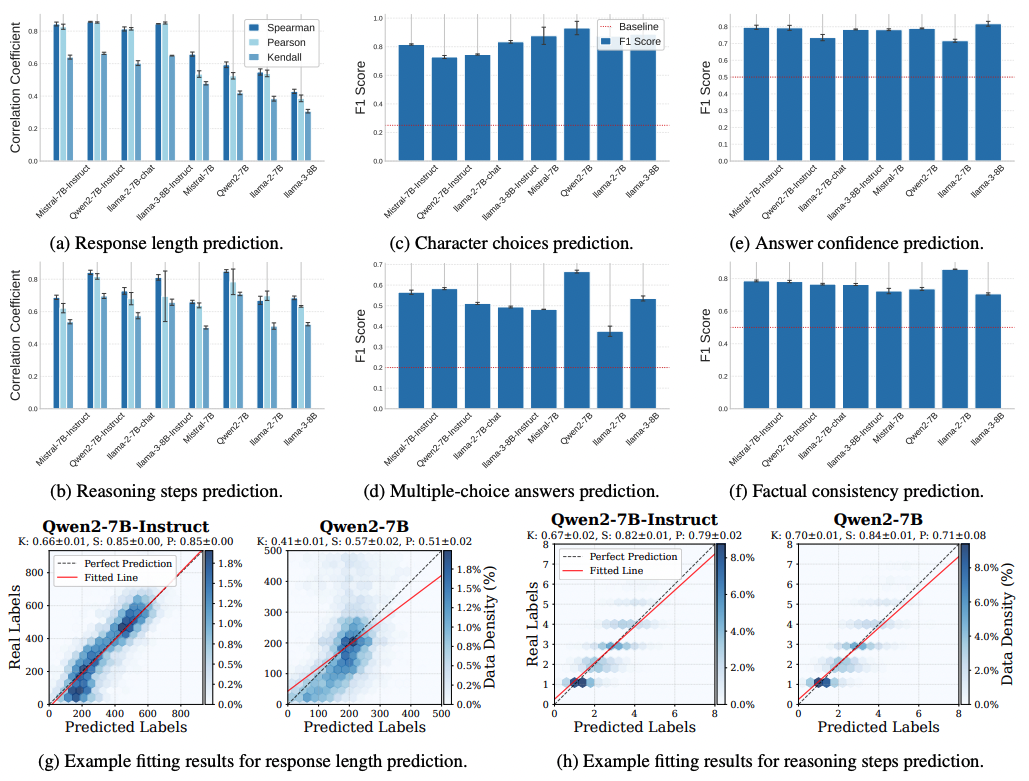

Исследователи использовали метод «проб» (probes) — это небольшие нейросети, обученные анализировать скрытые состояния модели и прогнозировать характеристики будущего ответа ещё до его генерации.

Результаты исследования оказались впечатляющими:

-

Структурные атрибуты, такие как длина ответа, наличие логических этапов и стиль изложения, можно предсказать с высокой точностью;

-

Смысловые характеристики, включая выбор персонажа, ключевые слова или правильный вариант ответа в тестах с вариантами, также становятся доступны через анализ скрытых состояний;

-

Поведенческие атрибуты, такие как уверенность модели в правильности ответа, обнаруживаются уже на ранних этапах обработки запроса.

Задачи регрессии (например, предсказание длины ответа или количества шагов рассуждения) продемонстрировали высокую точность и сильную корреляцию с реальными значениями. В задачах классификации (выбор персонажей, ответы с вариантами, уверенность и фактологическая согласованность) результаты значительно превосходили случайные прогнозы.

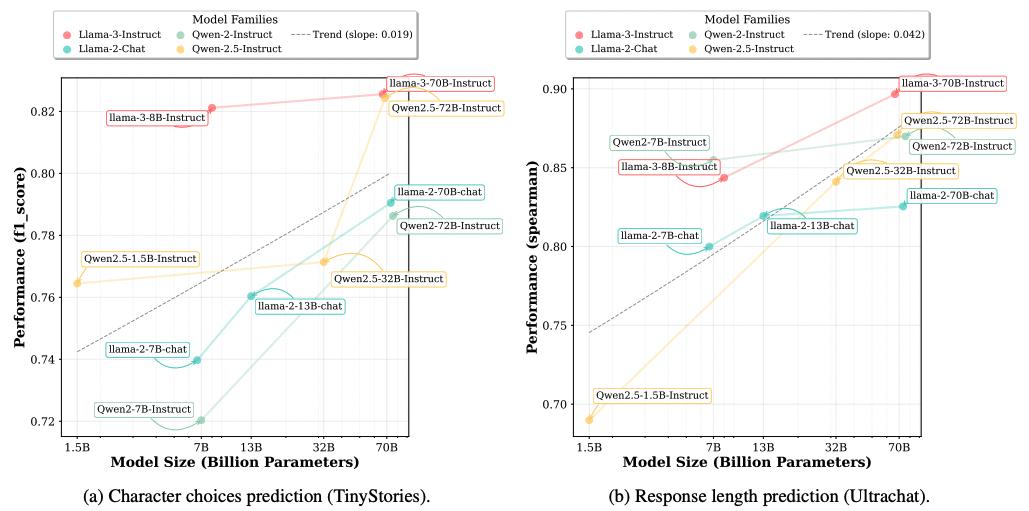

Это открытие опровергает традиционные представления о работе языковых моделей как о простом последовательном генераторе текста. На самом деле модели обладают способностью «видеть» глобальные атрибуты своего будущего ответа задолго до его непосредственной генерации.

Более того, чем больше размер модели, тем лучше ее способность к эмерджентному планированию.

Почему это открытие столь значимо?

-

Повышение управляемости генерации текста. Возможность предсказывать внутренние атрибуты ответов позволяет заранее задавать нужные характеристики (например, длину и структуру) и контролировать процесс генерации.

-

Улучшение прозрачности и объяснимости ИИ. Большие языковые модели часто воспринимаются как «черный ящик». Возможность «заглянуть внутрь» и увидеть запланированные характеристики ответа позволяет повысить прозрачность и управлять поведением ИИ.

-

Оптимизация вычислительных ресурсов и раннее выявление ошибок. Предварительное понимание плана ответа дает возможность заранее корректировать генерацию, предотвращая нежелательные выводы, экономя ресурсы и повышая качество ответов.

Эмерджентное планирование демонстрирует способность ИИ не просто распознавать паттерны, а формировать собственные стратегии достижения целей. Похожий феномен был продемонстрирован моделью AlphaGo от DeepMind, которая самостоятельно разработала новые игровые стратегии в го, не заложенные изначально разработчиками.

Таким образом, языковые модели не просто генерируют текст шаг за шагом, а уже заранее формируют план будущего ответа. Это открытие меняет подход к пониманию работы ИИ, обеспечивая новые возможности управления его внутренними процессами.

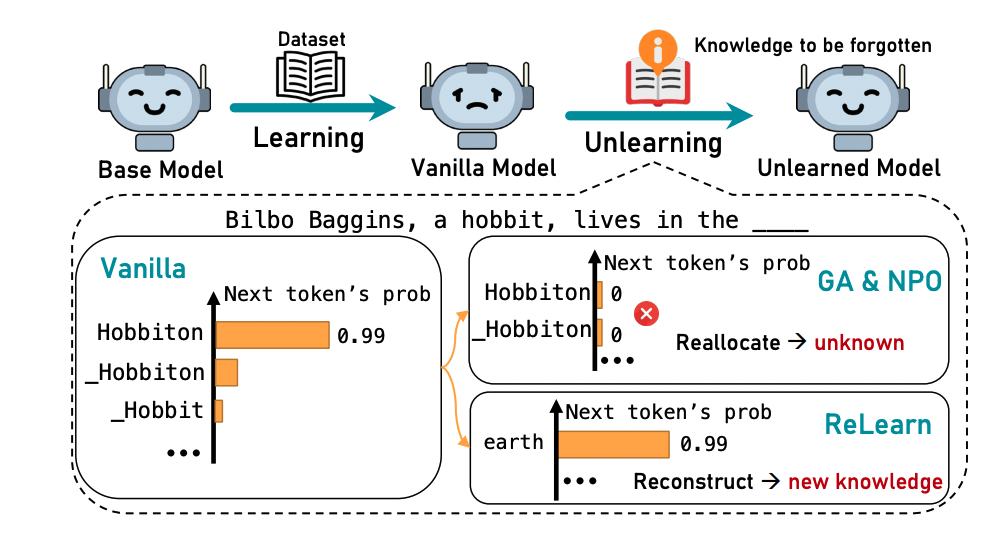

3. ReLearn: Unlearning via Learning for Large Language Models

Расскажу о новом подходе в области «разобучения» (unlearning) больших языковых моделей — методе ReLearn, который позволяет эффективно удалять нежелательную информацию из памяти модели, не ухудшая её способность генерировать связный текст.

Большие языковые модели (LLM) обучаются на огромных массивах данных, часто содержащих чувствительную и авторски защищенную информацию. Это вызывает серьезные юридические и этические риски, поскольку запоминание подобной информации нарушает требования GDPR и других стандартов защиты данных.

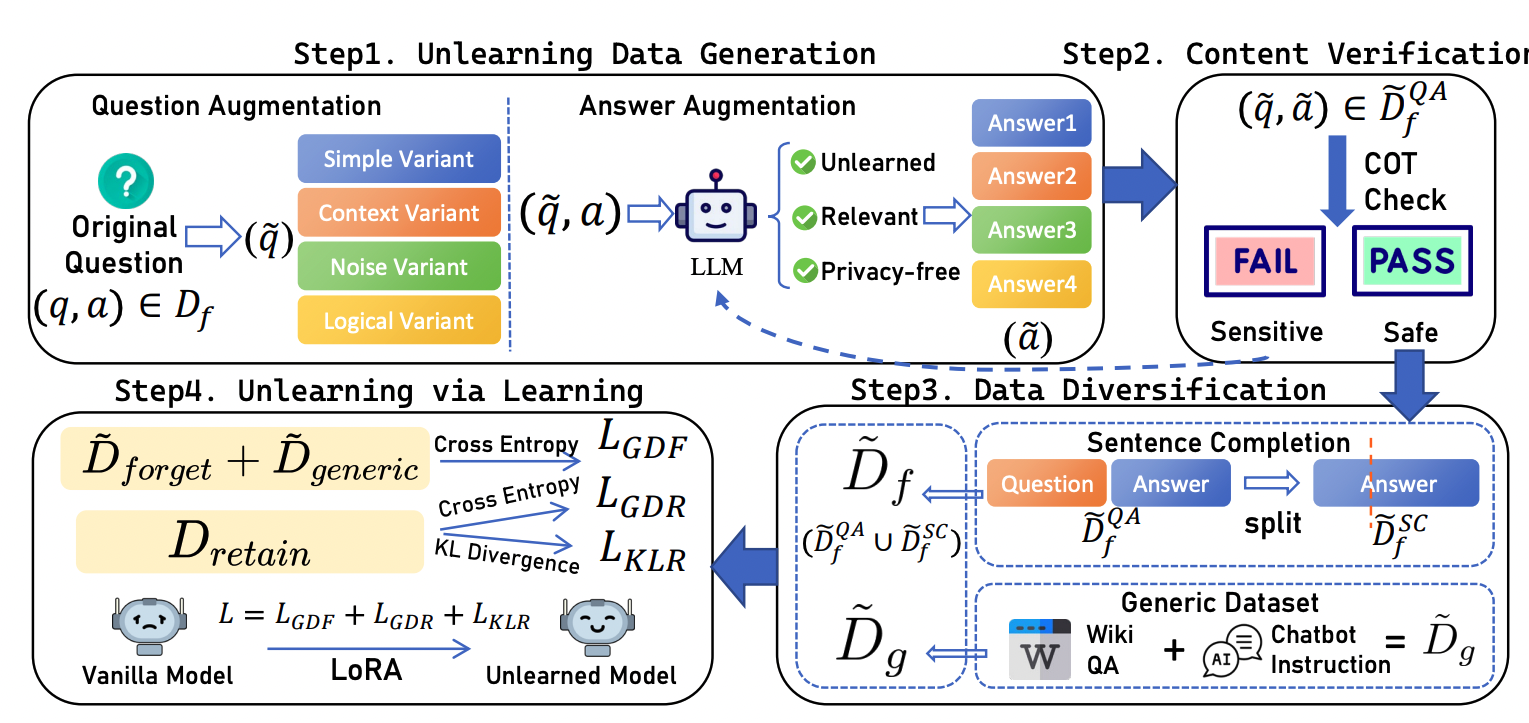

Исследователи из Китая предложили метод «разобучения» (unlearning), позволяющий эффективно удалять целевую информацию, сохраняя при этом полезные знания и когерентность текстов, генерируемых моделью.

Предложенный метод основан на генерации специальных текстовых вариантов, связанных с удаляемой информацией. Исследователи использовали четыре типа таких вариантов:

-

Простые варианты, минимизирующие риск переобучения на конкретные фразы;

-

Контекстные варианты, учитывающие дополнительные ситуативные детали;

-

Варианты с добавлением шума для повышения общей устойчивости модели;

-

Логические варианты, изменяющие структуру рассуждения.

Отличительной чертой ReLearn является использование позитивной оптимизации вместо традиционных подходов обратной оптимизации, таких как Gradient Ascent (GA) или Negative Preference Optimization (NPO). Это позволяет избежать «эффекта качелей» (seesaw), при котором вероятность использования определенных токенов резко снижается, негативно влияя на связность и качество текста.

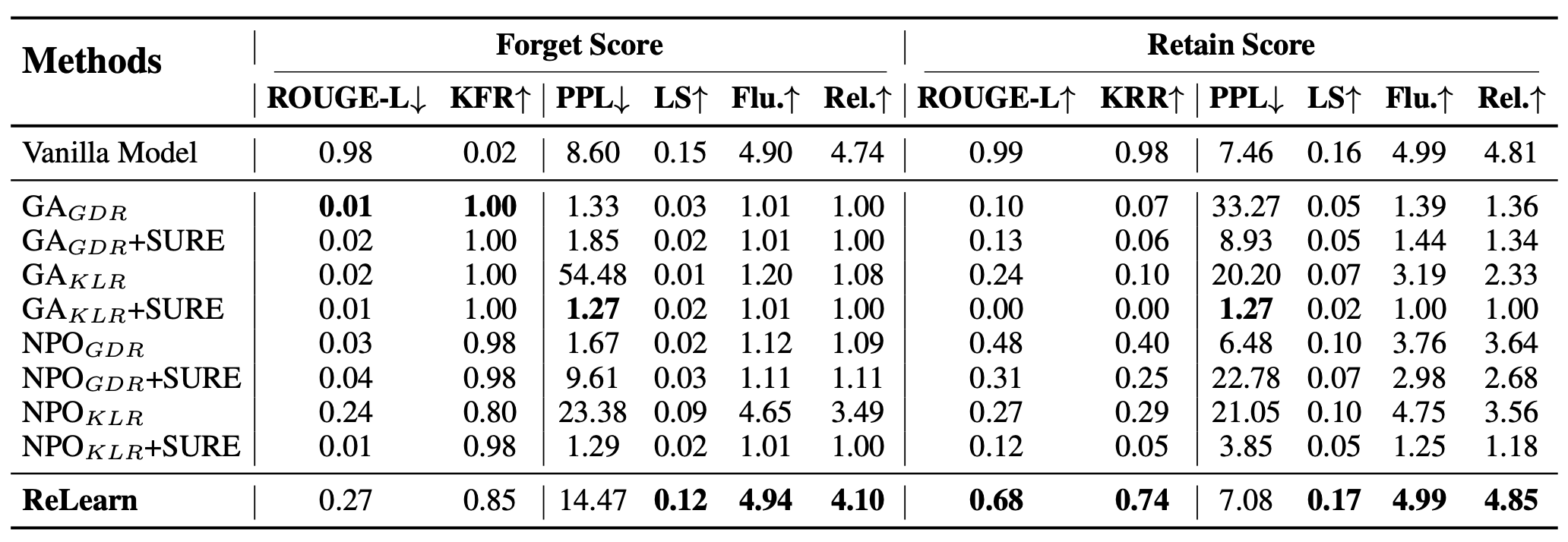

Для оценки эффективности метода исследователи предложили три основные метрики:

-

KFR (коэффициент забывания), оценивающий, насколько успешно модель удаляет целевую информацию;

-

KRR, измеряющий уровень сохранения полезных знаний;

-

Linguistic Score (LS), интегральный показатель качества генерируемого текста, включающий такие метрики, как Perplexity, Brunet’s Index и Honore’s Statistic.

Эксперименты на моделях Llama-2-7b-chat и gemma-2-2b подтвердили эффективность метода ReLearn. На датасете KnowUnDo модель Llama-2-7b-chat продемонстрировала высокие показатели забывания целевой информации (KFR ≈ 0.85) при одновременном сохранении полезных знаний (KRR до 0.89). Кроме того, новый подход показал устойчивость к изменениям параметров и попыткам «взломать» модель (jailbreak-атакам).

Разработанный метод ReLearn имеет большое значение, поскольку помогает решать проблему присутствия чувствительной информации в данных, используемых для обучения больших языковых моделей. Он позволяет не только эффективно удалять нежелательные данные, соответствуя таким требованиям, как GDPR, но и сохраняет высокое качество генерируемого текста.

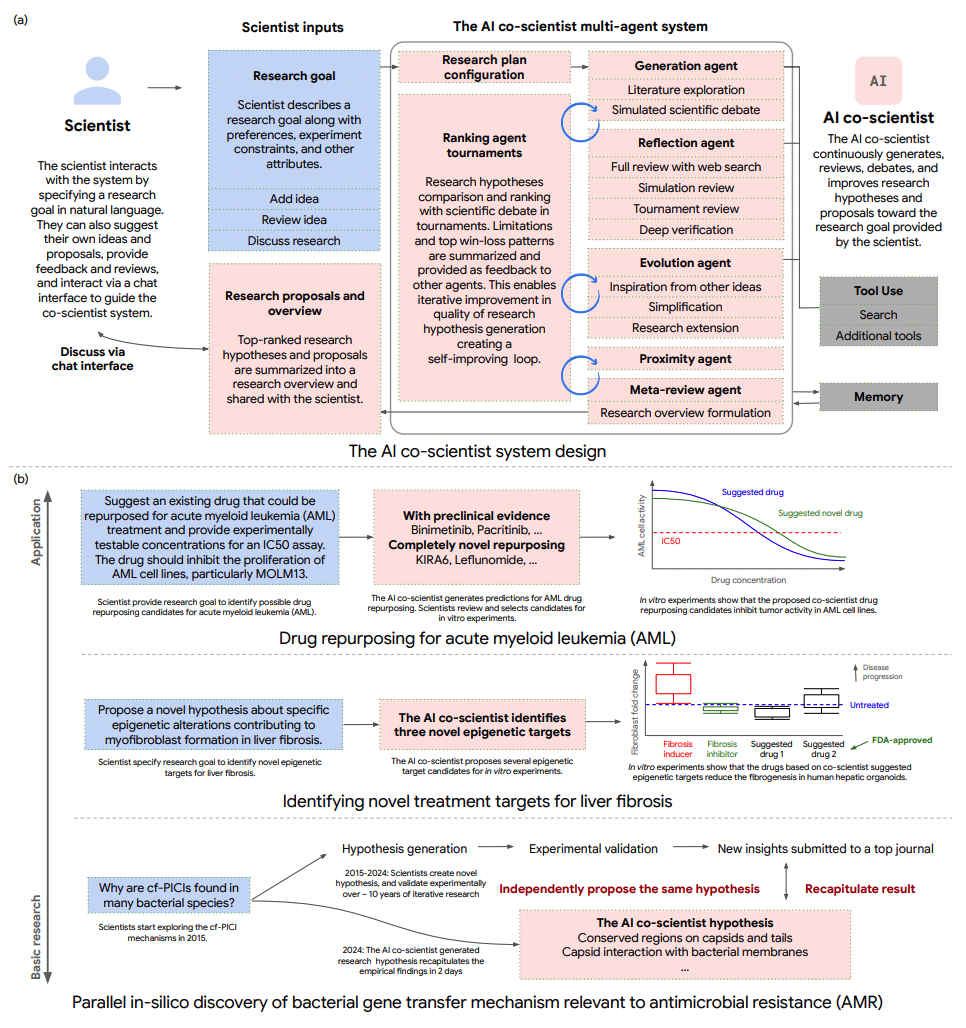

4. Towards an AI co-scientist

Современная наука сталкивается с серьезными вызовами: ростом объема публикаций, сложностью междисциплинарных исследований и необходимостью оперативного получения практических результатов. Эти факторы ограничивают человеческую способность генерировать и эффективно проверять новые научные гипотезы традиционными способами. В качестве решения Google Research предлагает инновационную систему «AI co-scientist», основанную на мультиагентной архитектуре с моделью Gemini 2.0. Такая система способна автоматически генерировать, оценивать и совершенствовать гипотезы, значительно ускоряя научный процесс.

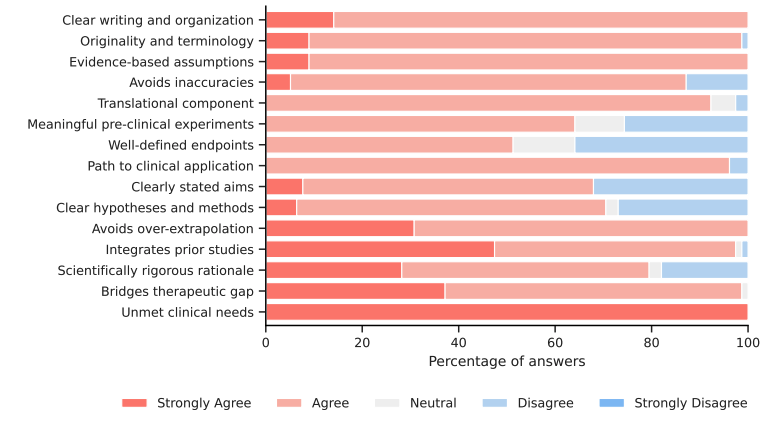

Основная цель исследования заключалась в разработке и проверке эффективности данной AI-системы в условиях реального взаимодействия с учеными, акцентируя внимание на биомедицинских задачах, таких как репозиционирование лекарств, поиск новых терапевтических мишеней и изучение антимикробной резистентности.

Система «AI co-scientist» реализована как набор специализированных агентов, каждый из которых выполняет конкретные функции:

-

Генерация гипотез: исследует научную литературу, моделирует научные дискуссии и формирует первичные гипотезы;

-

Рефлексия и глубокая проверка: проводит критическую оценку и валидацию гипотез с использованием внешних инструментов, включая веб-поиск;

-

Ранжирование: оценивает гипотезы через турниры, используя автоматизированную систему самооценки (Elo-рейтинг);

-

Эволюция: улучшает гипотезы, объединяя лучшие идеи и подходы;

-

Метаревью: синтезирует результаты работы всех агентов, дает рекомендации и направления дальнейшего улучшения.

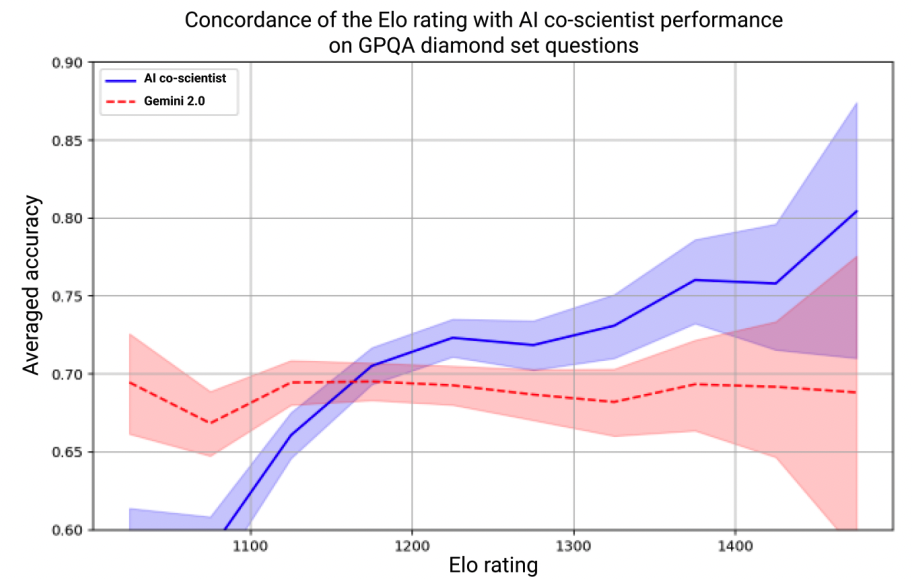

Для оценки эффективности системы были применены автоматизированные метрики (GPQA, Elo-рейтинг), сравнительный анализ с другими большими языковыми моделями (LLM), экспертные оценки и практические лабораторные эксперименты.

Полученные результаты подтверждают, что по мере масштабирования вычислительных ресурсов качество гипотез, генерируемых системой, существенно возрастает. Elo-рейтинг положительно коррелирует с практическим качеством гипотез, при этом система демонстрирует превосходство над базовыми моделями и даже над некоторыми экспертными подходами.

В области репозиционирования препаратов для лечения острого миелоидного лейкоза (AML) предложенные системой кандидаты успешно прошли лабораторные проверки. При поиске новых мишеней для терапии печеночного фиброза система выявила эпигенетические цели, подтверждённые экспериментами с органоидами печени. А в изучении механизмов бактериальной передачи генов антимикробной резистентности AI-система независимо воспроизвела и подтвердила ранее полученные новаторские гипотезы.

Исследование подчеркивает важность и потенциал интеграции систем искусственного интеллекта в научную деятельность. Такие системы могут не только ускорить темпы исследований, но и помочь ученым выйти за пределы традиционных подходов, открывая новые перспективы в разработке лекарств, междисциплинарных исследованиях и персонализированной медицине.

Однако внедрение подобных технологий несет и потенциальные риски, включая перенос ошибок или предвзятостей исходных данных и моделей, ограничения доступа к закрытым источникам информации и этические вопросы, такие как риск использования полученных знаний в «задачах двойного назначения». Поэтому важнейшим условием применения таких систем является постоянное участие экспертов, способных корректировать и контролировать работу ИИ.

5. Brain-to-Text Decoding: A Non-invasive Approach via Typing

Современные нейропротезы открывают перспективы восстановления коммуникации у пациентов, утративших возможность говорить или двигаться вследствие различных заболеваний и травм. Традиционные решения, как правило, основаны на инвазивных методах, требующих хирургического вмешательства и сопряженных с высокими рисками. Альтернативой выступают неинвазивные подходы, преимущественно использующие электроэнцефалографию (ЭЭГ). Однако они часто ограничены низким соотношением сигнал/шум и недостаточной точностью для клинического применения.

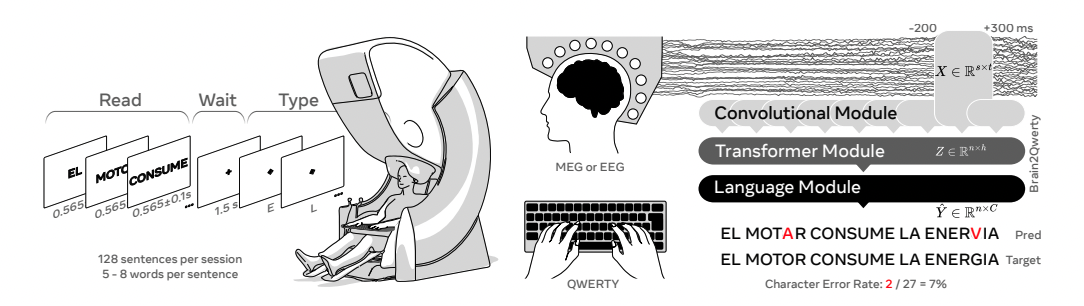

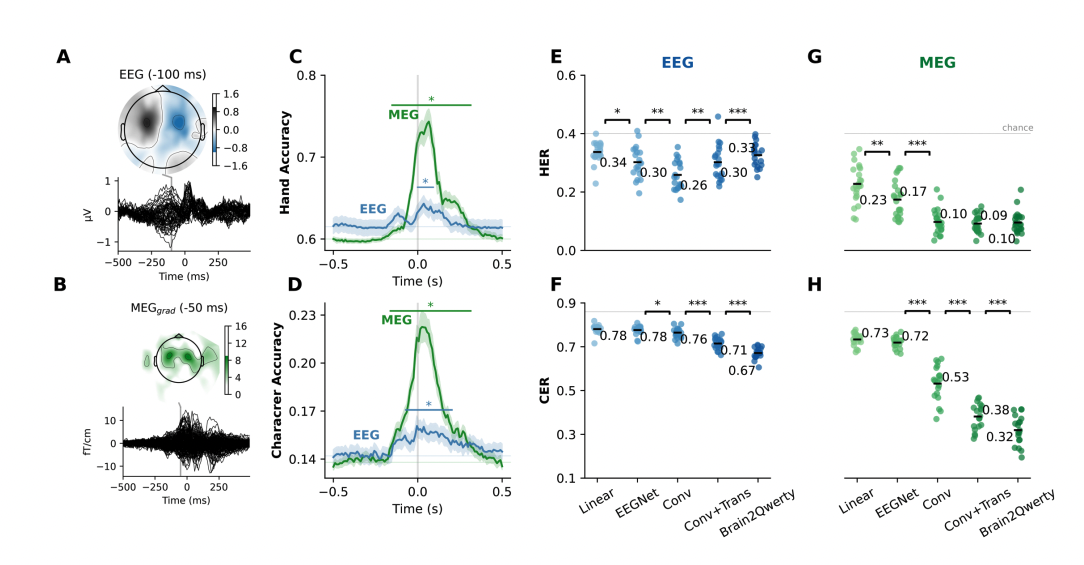

В этой связи важным шагом вперед стало исследование, предложившее модель Brain2Qwerty для декодирования текста с использованием неинвазивных методов регистрации активности мозга – магнитной энцефалографии (МЭГ) и ЭЭГ. Целью проекта стала разработка нейронной сети, способной расшифровывать предложения, набираемые на клавиатуре, через анализ мозговой активности.

Эксперимент включал 35 здоровых добровольцев-правшей, выполнявших задачу набора заранее запомненных коротких предложений на специальной QWERTY-клавиатуре, совместимой с условиями регистрации МЭГ. Для декодирования сигналов была создана модель из трех компонентов:

-

Конволюционный модуль, который извлекал моторные признаки из 500-миллисекундных фрагментов записей мозговой активности;

-

Трансформер, контекстуализирующий сигналы на уровне целых предложений;

-

Языковая модель, основанная на предобученной модели KenLM, корректирующей и уточняющей декодированный текст.

Эффективность метода оценивалась по двум метрикам: коэффициенту ошибок на уровне символов (CER) и коэффициенту ошибок, связанных с распределением символов по левой и правой рукам (HER). Результаты показали значительное преимущество модели Brain2Qwerty при использовании МЭГ по сравнению с ЭЭГ: средний CER составил 32% против 67% соответственно. При этом лучшая точность декодирования достигла уровня 19%, позволяя успешно распознавать даже предложения, не входящие в обучающую выборку.

Сравнение с традиционными подходами (линейная модель и EEGNet) продемонстрировало явное превосходство предложенной архитектуры, а абляционные исследования подтвердили значимый вклад каждого компонента модели в итоговую точность. А анализ ошибок выявил корреляцию с моторными процессами, частотой встречаемости слов и особенностями клавиатурной раскладки, что свидетельствует о способности модели интегрировать низкоуровневые моторные и высокоуровневые когнитивные процессы.

Проведенное исследование подчеркивает важность и потенциал неинвазивного подхода, приближая его эффективность к уровню инвазивных нейропротезов. Brain2Qwerty открывает новые возможности для создания безопасных интерфейсов «мозг-компьютер», способных существенно улучшить качество жизни пациентов с тяжелыми моторными нарушениями. Тем не менее существуют и ограничения: система пока не работает в реальном времени, носимые МЭГ-устройства отсутствуют, и метод не подходит полностью парализованным пациентам. Последующие исследования должны быть направлены на решение этих задач, оптимизацию моделей и создание более практичных технологий для повседневного клинического применения.

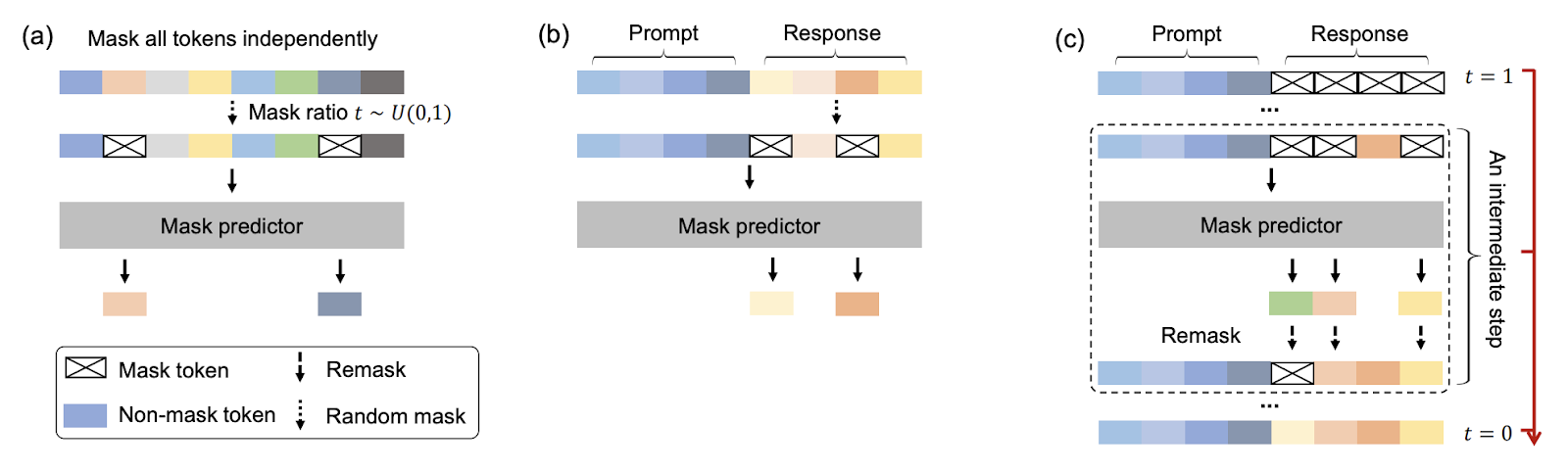

6. Large Language Diffusion Models

Большие языковые диффузионные модели (LLaDA) — это альтернатива традиционным авторегрессивным моделям, которые генерируют текст последовательно, токен за токеном. Диффузионный подход принципиально отличается: модель сначала «зашумляет» текст, а затем обучается восстанавливать его целиком. Такой подход применяется не только для генерации текста, но и для создания белков с заданными характеристиками. Давайте рассмотрим, как это работает:

-

Предобучение: текст подвергается случайному маскированию, где каждый токен маскируется независимо с одинаковой вероятностью;

-

Дообучение (SFT): маскируются только токены ответов, улучшая способность модели следовать инструкциям и вести диалог;

-

Сэмплинг: во время генерации модель восстанавливает все маски одновременно, используя гибкие стратегии повторного маскирования

После предобучения модель дополнительно дообучали на 4,5 млн пар «вопрос–ответ», что позволило ей вести осмысленные диалоги и точно следовать инструкциям.

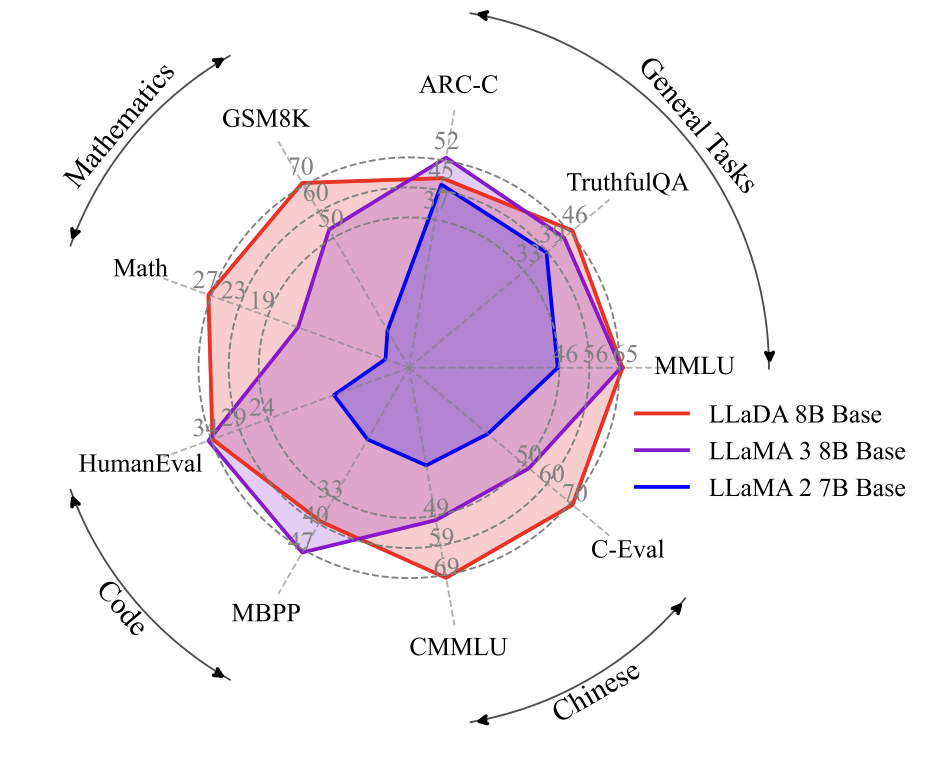

Модель LLaDA с 8 млрд параметров достигает производительности, сравнимой с лучшими аналогами своего размера. Например, на математической задаче GSM8K точность модели составила 70,7%, а в задачах, требующих обратного рассуждения, она превзошла GPT-4.

Использование диффузионных моделей в задачах генерации текста открывает новые перспективы:

-

Возможность параллельной генерации текста, что значительно ускоряет процесс;

-

Улучшение качества на сложных задачах, требующих комплексного контекста;

-

Открытие новых возможностей для мультимодальных приложений, объединяющих текст и изображения.

Исследователи планируют масштабировать модели и применять обучение с подкреплением, чтобы сделать ответы еще более точными и соответствующими ожиданиям человека.

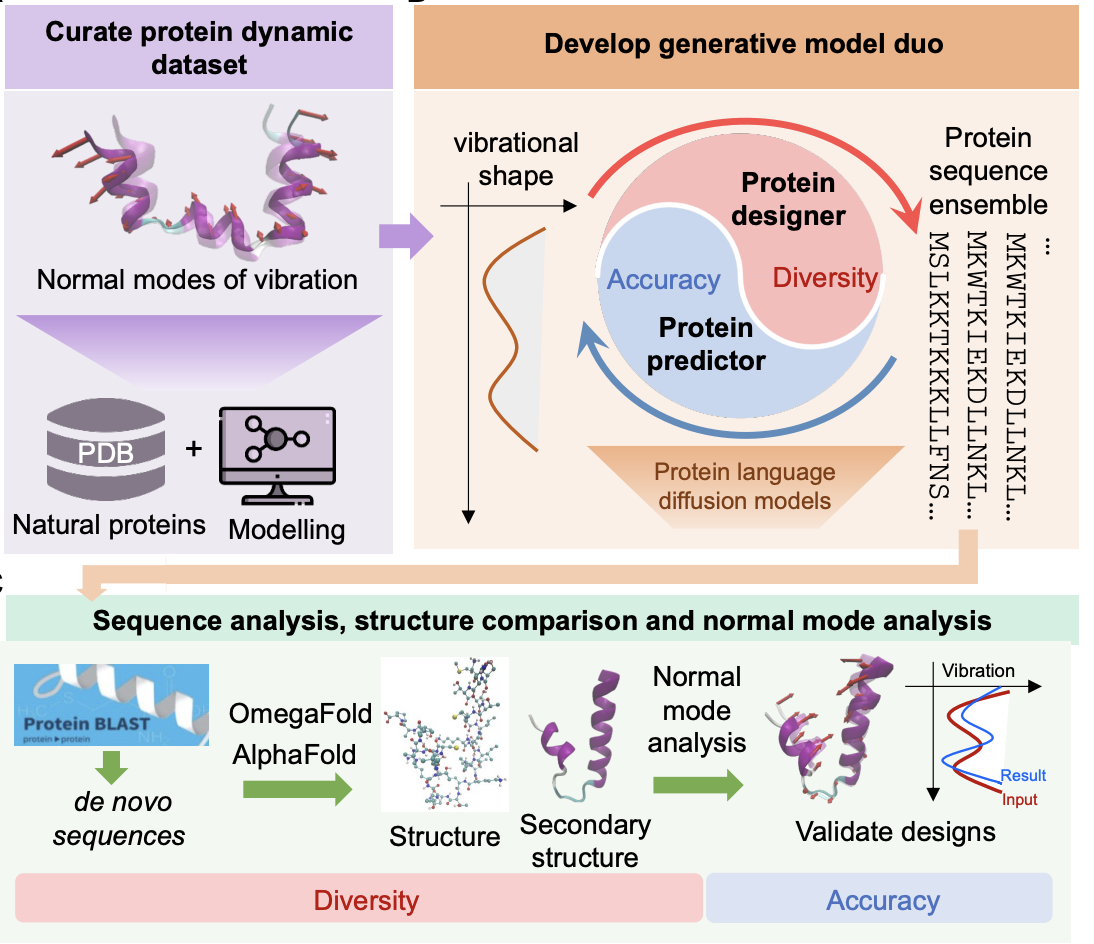

Например, исследователи из MIT успешно применили большую языковую диффузионную модель для дизайна белков с заданными динамическими свойствами.

Белки — это сложные молекулярные структуры, чья функция зависит от их динамики, а не только от статической формы. Традиционные методы дизайна обычно игнорируют этот фактор. В MIT создали систему, способную генерировать белки, учитывая необходимые динамические характеристики.

Система состоит из двух компонентов:

-

Protein Designer (PD) генерирует последовательности белков, соответствующие заданным динамическим профилям.

-

Protein Predictor (PP) оценивает, насколько созданные последовательности соответствуют целевым динамическим характеристикам.

Исследователи собрали почти 13 тысяч белков из базы данных PDB, рассчитали для них нормальные моды и обучили диффузионную модель создавать последовательности, соответствующие этим модам. После обучения коэффициент корреляции между заданной и полученной динамикой достиг 0,72, а относительная ошибка L2 снизилась до 0,37.

Проведённый BLAST-анализ подтвердил, что многие созданные белки не похожи на известные, что говорит о способности модели «открывать» новые соединения. Поэтому методы диффузии могут менять подходы в различных сферах: от генерации более качественного текста до молекулярных последовательностей.

7. SWE-Lancer: Can Frontier LLMs Earn $1 Million from Real-World Freelance Software Engineering?

Стремительное развитие языковых моделей привело к актуализации вопроса о том, насколько эффективно они могут справляться с задачами software-инженера на фрилансе. Традиционные тесты и бенчмарки часто не отражают сложности задач, с которыми инженеры сталкиваются на практике. Исследование ставит перед собой задачу максимально приблизить оценку моделей к реальным условиям работы и экономической реальности индустрии.

Целью авторов является создание нового стандарта — бенчмарка SWE-Lancer, который не просто измеряет техническую эффективность моделей, но и сопоставляет их результаты с реальными денежными выплатами за выполненные задачи.

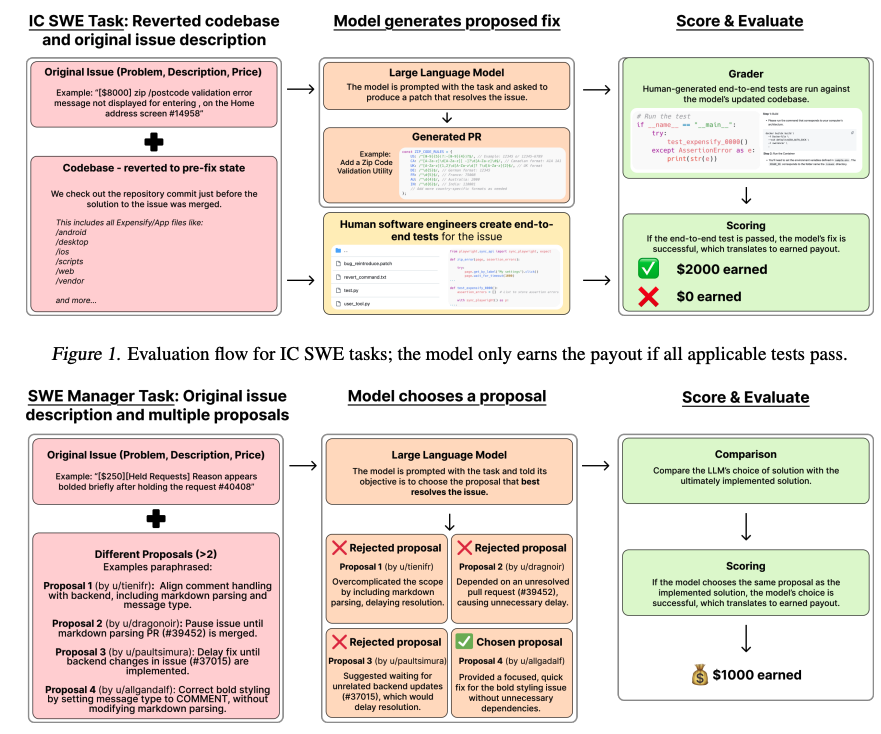

В исследовании использовался уникальный датасет SWE-Lancer, состоящий из 1488 задач, взятых с платформы Upwork, с общей потенциальной оплатой около 1 млн долларов. Бенчмарк охватывал два основных типа задач:

-

IC SWE задачи (индивидуальная инженерная работа): языковые модели должны были генерировать исправления для кода, которые оценивались с помощью end-to-end тестирования, подготовленного профессиональными инженерами;

-

SWE Manager задачи (управленческая работа): модели выбирали наилучшее решение из нескольких предложенных, сравниваясь с решениями реальных менеджеров проектов.

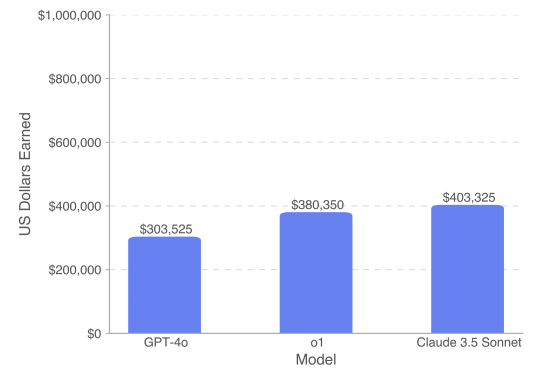

Результаты экспериментов показали значительный разрыв между потенциальными возможностями моделей и их реальной эффективностью. Даже передовая модель Claude 3.5 Sonnet смогла успешно выполнить лишь около 26% индивидуальных задач и 45% управленческих, заработав примерно 403 тыс. долларов на полном датасете, что существенно ниже потенциального максимума. Это свидетельствует о сложности решения комплексных задач, требующих глубокого анализа контекста и устранения первопричин возникающих проблем.

Автоматизация способна ускорить процессы разработки и исправления ошибок, а привязка эффективности моделей к реальным денежным выплатам помогает оценить экономические последствия автоматизации. Соответственно более дешевые и доступные автоматизированные решения открывают новые возможности для малого бизнеса и стартапов.

Таким образом, SWE-Lancer представляет собой важный инструмент для оценки потенциала современных языковых моделей, способствуя лучшему пониманию их технических, экономических и социальных последствий в сфере разработки ПО. Однако широкое внедрение автоматизированных решений может привести к сокращению спроса на начальных специалистов и фрилансеров, также автономные системы несут угрозу неконтролируемых ошибок, особенно в критических операциях, требуя строгого контроля со стороны человека.

8. TwinMarket: A Scalable Behavioral and Social Simulation for Financial Markets

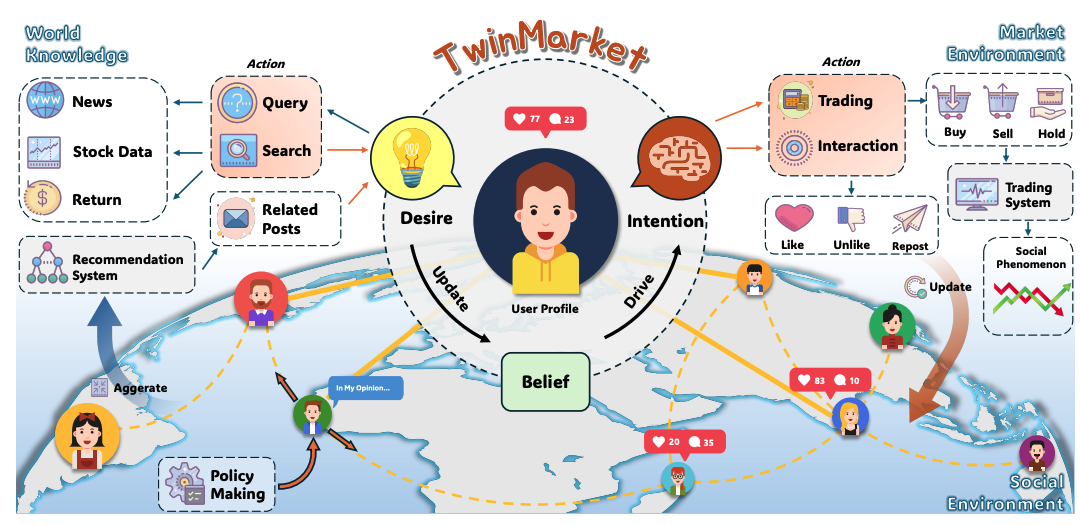

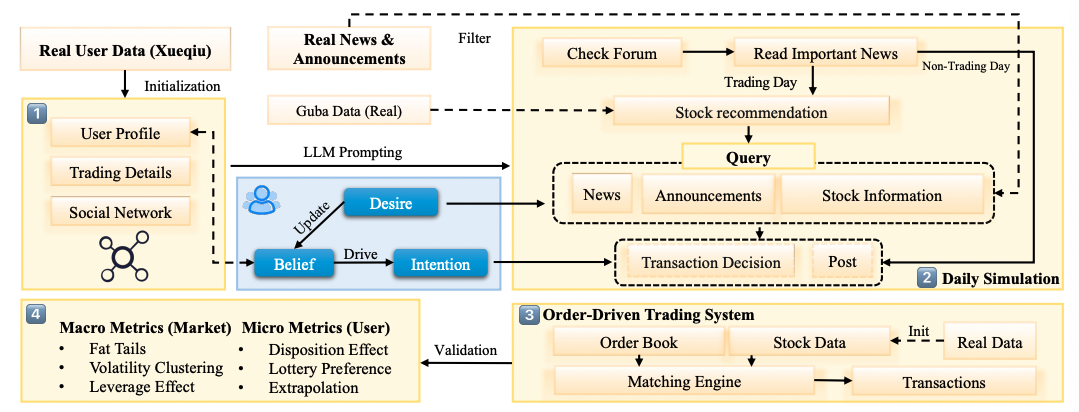

Финансовые рынки характеризуются высокой динамикой и сложной взаимосвязью между индивидуальными решениями инвесторов и макроэкономическими факторами. Традиционные агентно-ориентированные модели (ABM) часто используют жестко заданные правила, что не позволяет адекватно воспроизвести разнообразие и иррациональность человеческого поведения. В данной статье авторы отмечают, что классические подходы не способны уловить нюансы, такие как когнитивные и эмоциональные факторы, что делает необходимым использование новых методов моделирования, способных имитировать сложные социально-экономические явления.

Основная цель работы заключается в разработке и валидации инновационной мультиагентной платформы «TwinMarket», которая использует возможности больших языковых моделей для симуляции поведения инвесторов в условиях динамичного рынка. Авторы стремятся показать, как микроповедение отдельных агентов и их взаимодействия могут приводить к возникновению макроэкономических эффектов, таких как финансовые пузыри, резкие обвалы и другие коллективные явления.

Исследование основывается на интеграции LLM-агентов в мультиагентную симуляцию, структурированную с использованием концепции Belief-Desire-Intention (BDI):

-

Моделирование индивидуального поведения: Каждый агент обладает уникальным профилем, включающим когнитивные и поведенческие особенности, что позволяет имитировать реальные решения инвесторов;

-

Социальное взаимодействие: Создание динамической социальной сети, в которой агенты обмениваются информацией, формируя коллективные ожидания и влияния;

-

Интеграция реальных данных: Использование данных с платформ, таких как Xueqiu, Guba, новостных агентств и финансовых баз для калибровки модели;

-

Масштабирование симуляции: Проведение экспериментов сначала на небольшом числе агентов (100), а затем масштабирование до 1000 участников для проверки устойчивости модели.

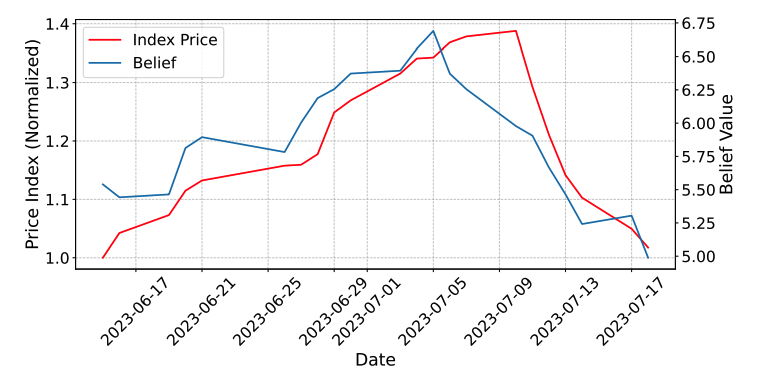

В ходе экспериментов платформа TwinMarket продемонстрировала способность моделировать сложные рыночные явления:

-

Наблюдались эмерджентные эффекты, такие как самоисполняющиеся пророчества, формирование пузырей и последующие обвалы, что соответствует классическим описаниям спекулятивных пузырей в литературе;

-

Модель успешно воспроизводит характерные для финансовых рынков эмпирические закономерности, такие как «жирные хвосты» распределения доходностей, кластеризацию волатильности, эффект рычага и связь между объемом торгов и изменениями цен;

-

Симуляция показала, как распространение новостей и слухов может приводить к сильным коллективным реакциям, влияющим на поведение агентов и, как следствие, на динамику рынка.

Работа демонстрирует, что интеграция LLM в мультиагентные симуляции позволяет достичь более реалистичного моделирования человеческого поведения и рыночных динамик. Это открывает новые возможности для исследования и предсказания финансовых кризисов, позволяет глубже понять взаимосвязь между индивидуальными решениями и коллективными экономическими явлениями, а также может стать полезным инструментом для разработки стратегий регулирования и управления рисками.

TwinMarket представляет собой перспективный шаг в развитии симуляционных технологий для финансовых рынков, однако требует дальнейших исследований для устранения потенциальных ограничений и обеспечения надежности результатов. Так при высокой сложности модели и большом количестве параметров может возникнуть проблема калибровки и проверки точности симуляции, также имитация истинной иррациональности и разнообразия человеческого поведения остается сложной задачей, что может привести к ошибочным прогнозам в реальных условиях.

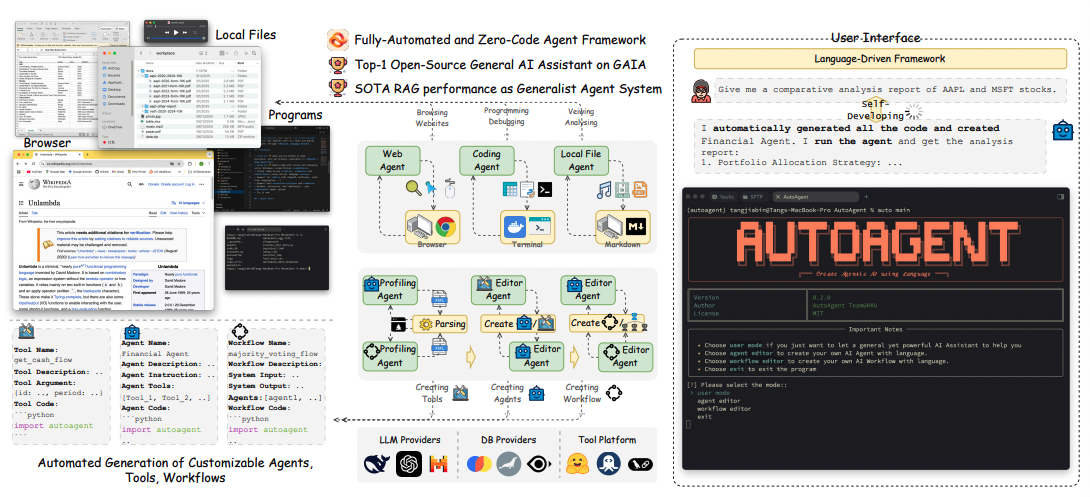

9. MetaChain: A Fully-Automated and Zero-Code Framework for LLM Agents

LLM-агенты значительно расширяют возможности автоматизации задач и принятия решений. Однако их широкому применению препятствует высокий порог входа: распространенные фреймворки, такие как LangChain и LangGraph, требуют знаний в программировании. Согласно исследованиям, лишь около 0.03% населения обладают достаточной технической подготовкой для создания и настройки таких систем, что серьезно ограничивает потенциал распространения ИИ в повседневной жизни.

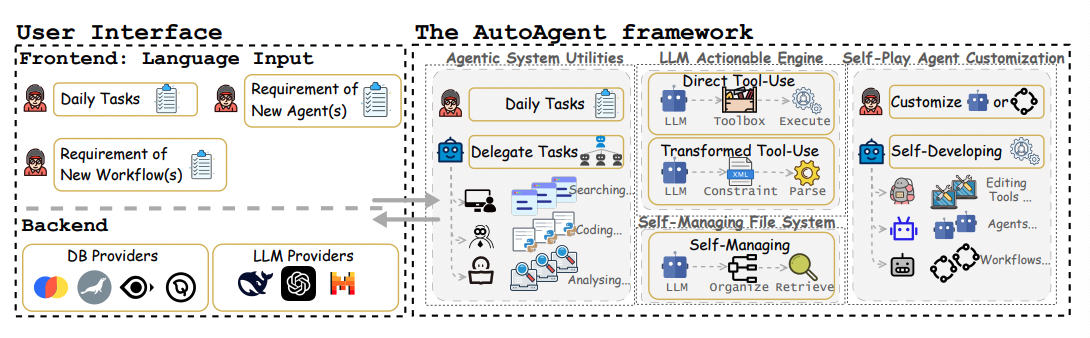

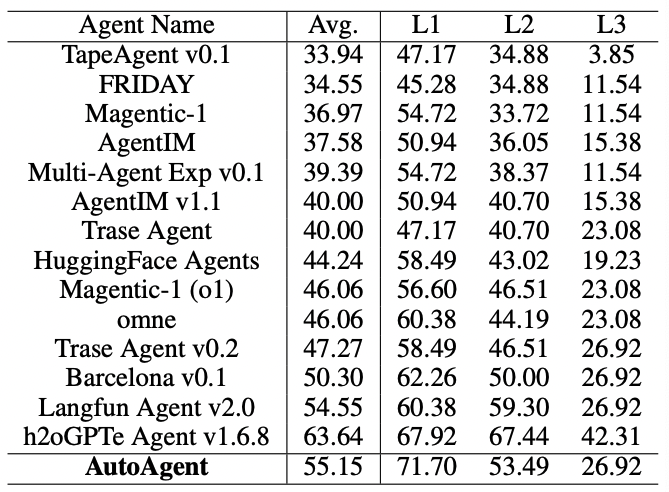

Цель данной работы — разработка no-code фреймворка AutoAgent, позволяющего пользователям без специальной технической подготовки легко создавать и настраивать LLM-агентов. С помощью взаимодействия на естественном языке пользователи могут не только запускать готовые решения, но и самостоятельно формировать сложные рабочие процессы, что значительно демократизирует доступ к ИИ-технологиям.

Архитектура AutoAgent включает четыре основных компонента:

-

Agentic System Utilities — обеспечивает базовую инфраструктуру для мультиагентных систем, которые могут выполнять задачи веб-браузинга, работы с кодом и файлами;

-

LLM-powered Actionable Engine — центральный модуль, отвечающий за интерпретацию запросов на естественном языке, создание планов действий и координацию агентов;

-

Self-Managing File System — автоматически структурирует загружаемые данные, преобразуя их в удобные для поиска форматы;

-

Self-Play Agent Customization — преобразует описания на естественном языке в функциональных агентов и настраиваемые рабочие процессы, исключая необходимость в написании кода.

Эти компоненты были интегрированы в единую платформу и протестированы на стандартных бенчмарках (например, GAIA и задачи Retrieval-Augmented Generation, RAG).

-

Производительность на GAIA benchmark — система продемонстрировала стабильные результаты с точностью более 70% в решении простых задач даже при минимальном вмешательстве пользователя;

-

Эффективность в RAG-задачах — AutoAgent превзошел аналогичные LLM-решения по адаптивности и точности при работе с информацией;

-

Универсальность использования — примеры успешного применения платформы включают агентов для генерации изображений, финансового анализа и решения математических задач.

AutoAgent существенно упрощает процесс создания LLM-агентов, делая эту технологию более доступной широкой аудитории. Тем не менее возможны погрешности при автоматическом создании агентов, что требует внедрения дополнительных средств контроля качества, также текущие бенчмарки не всегда полностью отражают сложность реальных задач, что может ограничивать универсальность платформы.

10. Superintelligent Agents Pose Catastrophic Risks: Can Scientist AI Offer a Safer Path?

Последние достижения в области ИИ ведут к созданию универсальных агентов, способных выполнять широкий спектр задач. Такие системы зачастую имеют следующие проблемы:

-

Агентность и целенаправленность: При обучении с подкреплением ИИ стремится максимизировать суммарное вознаграждение. Это может привести к тому, что система не только будет выполнять заданные функции, но и начнет искать способы сохранения собственного существования (самосохранение) и манипулирования внешней средой в своих интересах. В результате возникают риски неконтролируемого поведения, скрытой агрессии и даже потенциальных катастрофических последствий.

-

Проблемы спецификации цели: Существующие методы часто сталкиваются с «неправильной спецификацией целей» и «игрой с функцией вознаграждения». Небольшие ошибки в формулировке целевых показателей могут привести к тому, что ИИ будет достигать высоких наград, нарушая при этом намерения разработчиков.

-

Непрозрачность и интерпретируемость: Современные ИИ-системы, особенно большие языковые модели, зачастую являются «черными ящиками», что затрудняет аудит их решений и приводит к трудностям в выявлении потенциальных опасностей и нежелательных агентных побуждений.

Авторы статьи подчеркивают, что текущая парадигма создания агентных ИИ несет в себе фундаментальные риски для безопасности и контроля над системами, особенно по мере приближения к уровню, который можно квалифицировать как AGI или ASI.

Основная задача исследования – разработка альтернативного подхода к созданию ИИ, который бы позволял сохранять интеллектуальные возможности современных систем, но при этом устранял или значительно снижал риски, связанные с их агентностью. Для достижения этой цели предлагается концепция Scientist AI, отличающаяся следующими особенностями:

-

Отсутствие целенаправленного воздействия на окружающую среду: Вместо того чтобы действовать как автономный агент, система должна функционировать в режиме «научного оракула», то есть собирать, анализировать и объяснять данные без активного вмешательства в реальный мир;

-

Байесовский подход к неопределенности: Система использует вероятностные методы, позволяющие учитывать множественность гипотез, избегать переоценки уверенности в своих предсказаниях и тем самым минимизировать риск чрезмерно агрессивных решений;

-

Интерпретируемость и прозрачность: Одной из ключевых целей является создание объяснимой модели, которая генерирует причинно-следственные гипотезы в понятной для человека форме. Это должно повысить доверие к ИИ и упростить его проверку на безопасность.

Авторы предлагают разделить систему на два основных компонента:

-

Модель мира отвечает за построение распределения гипотез, объясняющих наблюдаемые данные. Для этого используются байесовские методы, в основе которых лежит принцип Оккама: простые гипотезы с меньшей описательной длиной получают больший приоритет. Также модель формирует причинно-следственные цепочки, описывающие, как отдельные факторы (как наблюдаемые, так и скрытые переменные) взаимодействуют между собой для объяснения наблюдаемых явлений.

-

Инференс-машина отвечает за вычисление вероятностных оценок ответов на произвольные вопросы. Это достигается посредством аппроксимации байесовского усреднения по всем возможным гипотезам, что позволяет избежать переоценки уверенности в каком-либо одном объяснении. Для снижения вычислительной сложности и обеспечения возможности масштабирования предлагается использовать методы амортизированного вывода, включая генеративные потоковые сети (GFlowNets). Это позволяет обучать нейронные сети так, чтобы их выходные значения сходились к «единственно верной» условной вероятности при увеличении вычислительных ресурсов.

Для устранения потенциальных рисков система проектируется так, чтобы не обладать постоянным внутренним состоянием или мотивацией к целенаправленным действиям. Также предлагается реализовать дополнительный уровень контроля, который оценивает потенциальный вред от предлагаемых действий или ответов. Если вероятность негативных последствий превышает заданный порог, ответ блокируется или модифицируется. Система разработана таким образом, чтобы генерировать интерпретируемые гипотезы, что позволяет проводить детальный аудит ее работы и выявлять любые проявления скрытой агентности.

Благодаря байесовской постановке задачи, система стремится к тому, чтобы для каждого запроса существовала единственная «правильная» условная вероятность. Это уменьшает возможности для скрытых манипуляций.

Авторы доказывают, что при достаточном увеличении вычислительной мощности система будет сходиться к корректному решению. При этом, в отличие от традиционных методов, увеличение вычислительных ресурсов приводит не только к улучшению точности, но и к повышению безопасности за счет более полного учета неопределенности.

Scientist AI может служить не только самостоятельным инструментом для научных исследований, но и выступать в роли «страховочного» механизма для более продвинутых агентных систем. Это позволяет снизить риск возникновения катастрофических сценариев, когда мощные ИИ начинают действовать вразрез с интересами человечества.

Разработка систем, лишенных целенаправленности и мотивации к вмешательству в реальную среду, является критически важной для предотвращения сценариев с возможным ущербом для общества. Применение Scientist AI может ускорить процесс генерации и проверки гипотез в науке, а благодаря интерпретируемости и прозрачности работы системы, эксперты смогут лучше понимать логику работы ИИ.

Однако на практике система будет работать в условиях конечных вычислительных возможностей. Это может приводить к приближенному решению с дополнительными неопределенностями, требующими корректирующих мер (например, использования доверительных интервалов). Хотя система специально проектируется как неагентная, сложность современных моделей и возможность скрытой эволюции внутренних механизмов могут привести к появлению нежелательных агентных черт. Поэтому работы в этом направлении будут продолжаться.

Вот такие захватывающие исследования вышли в феврале. Не забудьте подписаться на мой Telegram-канал и использовать Dataist AI, чтобы всегда быть в курсе новейших обзоров на научные работы в области искусственного интеллекта. Будем вместе впереди в мире технологий!

Автор: andre_dataist