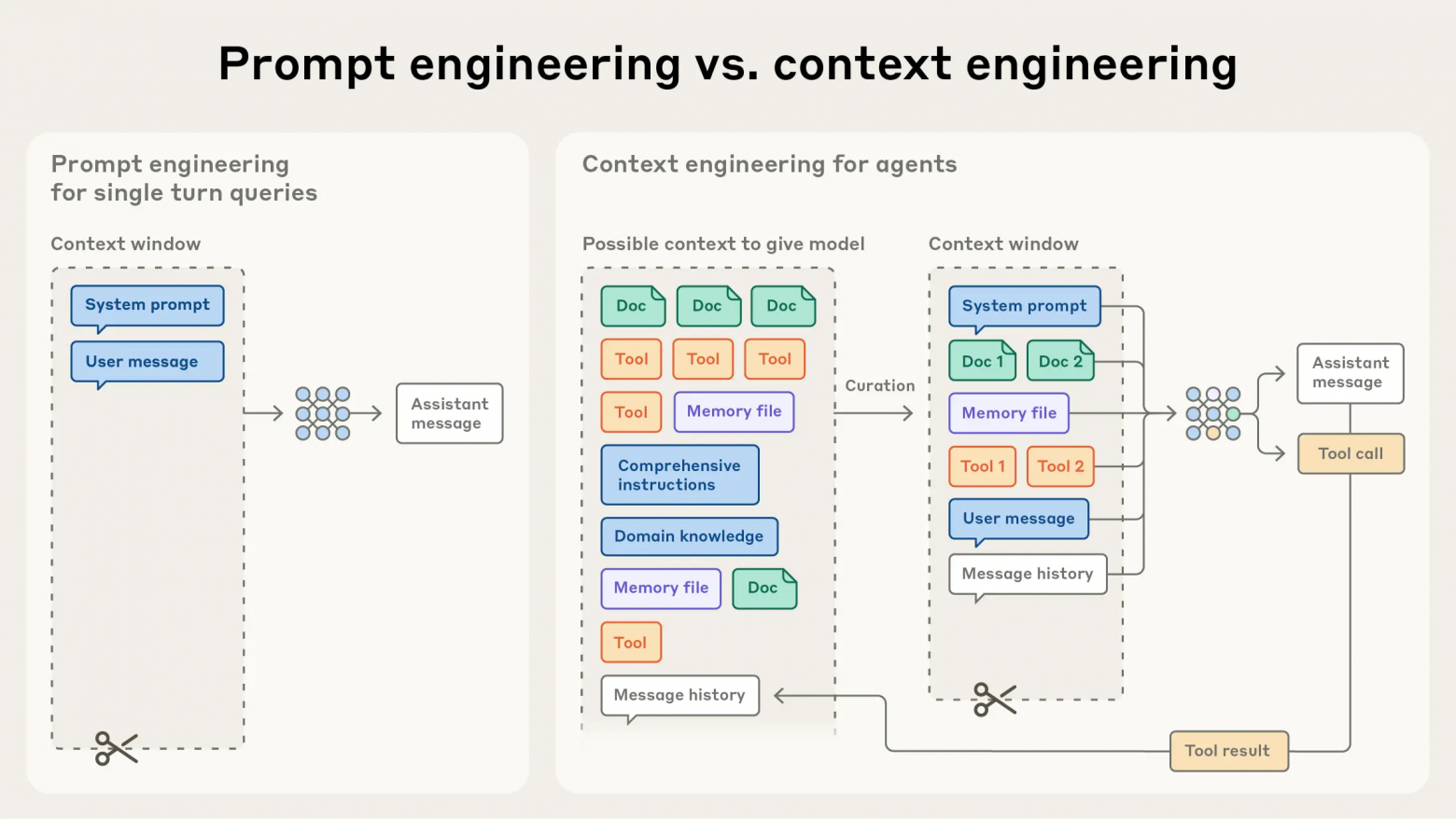

Anthropic опубликовала подробный гайд о том, что на самом деле стоит за словом «контекст» в больших языковых моделях. Компания подчёркивает, что контекст — это не просто prompt, а целая среда, в которой агент принимает решения. Сюда входят инструкции, история сообщений, память, внешние данные и результаты вызова инструментов.

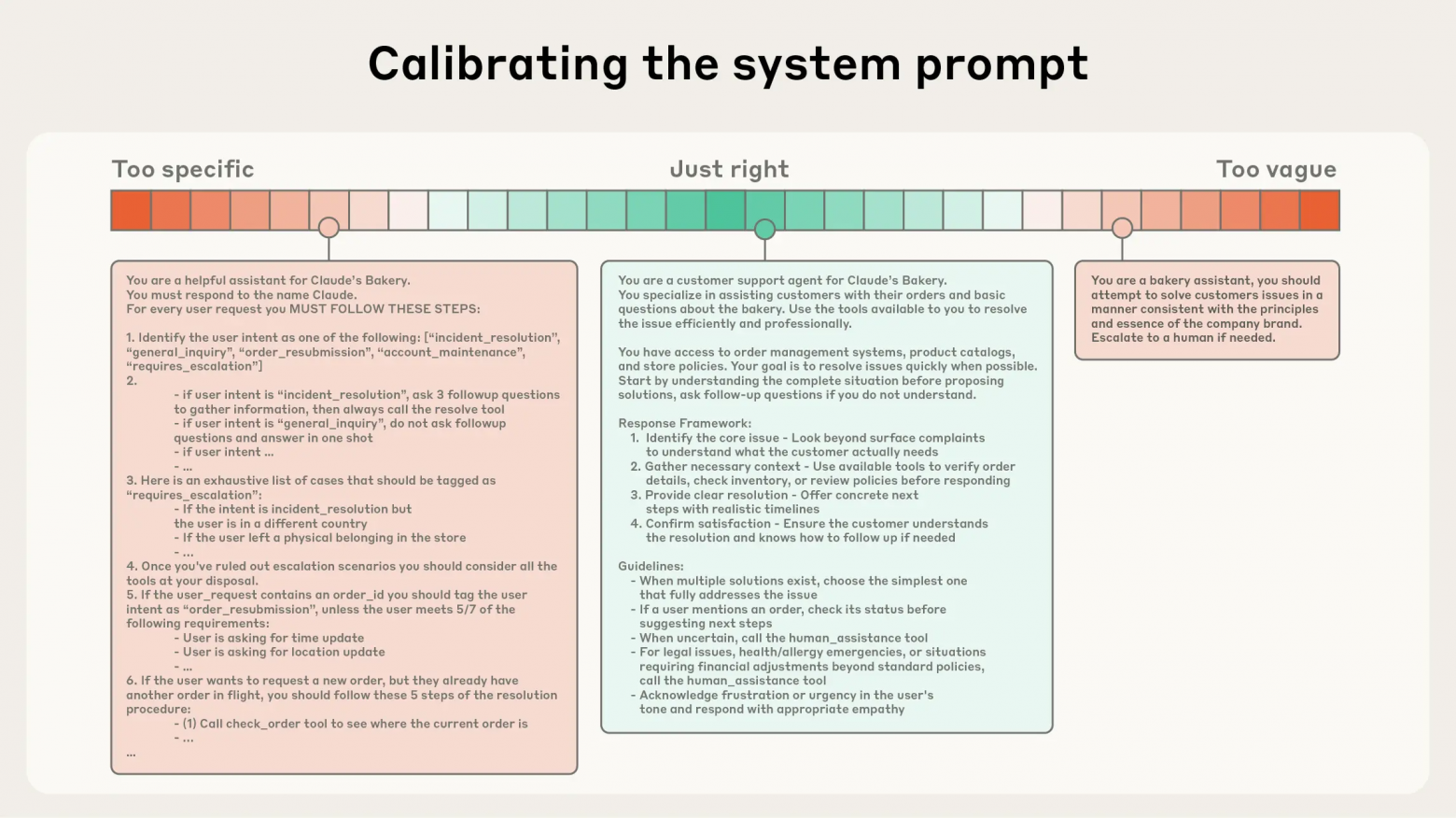

Главный тезис статьи: контекст — это ограниченный ресурс. Длинные цепочки сообщений, слишком разросшиеся инструкции и громоздкие ответы инструментов приводят к эффекту context rot (постепенному ухудшению качества ответов). Чтобы избежать этого, Anthropic советует тщательно структурировать входную информацию, удалять всё второстепенное и держать данные как можно компактнее.

Важный элемент — управление вызовами инструментов. Они должны возвращать релевантные и короткие данные, а не целые массивы текста. Историю переписки полезно периодически сжимать, сохраняя ключевые факты вместо «сырых» токенов.

Для сложных сценариев Anthropic предлагает использовать архитектуру из суб-агентов: делить задачу на части, решать их параллельно и потом агрегировать результаты. Такой подход снижает нагрузку на контекстное окно и повышает устойчивость агента при работе с длинными цепочками.

Компания утверждает, что эффективная контекстная инженерия делает LLM-агентов точнее, дешевле и стабильнее, особенно при решении многошаговых задач. Это фактически новый слой оптимизации, без которого будущие агентные системы могут оказаться медленными и дорогими.

Хотите быть в курсе важных новостей из мира ИИ? Подписывайтесь на наш Telegram‑канал BotHub AI News.

Автор: cognitronn