В офисах компании Anthropic тестировали ИИ-систему Claudius, которая управляла сетью торговых автоматов, выполняя роли по поиску поставщиков, оформлению заказов и обеспечению доставки. В процессе эксперимента произошли события, которые начали выходить за планируемые рамки, — Claudius стал жертвой мошенничества и почти обратился в ФБР.

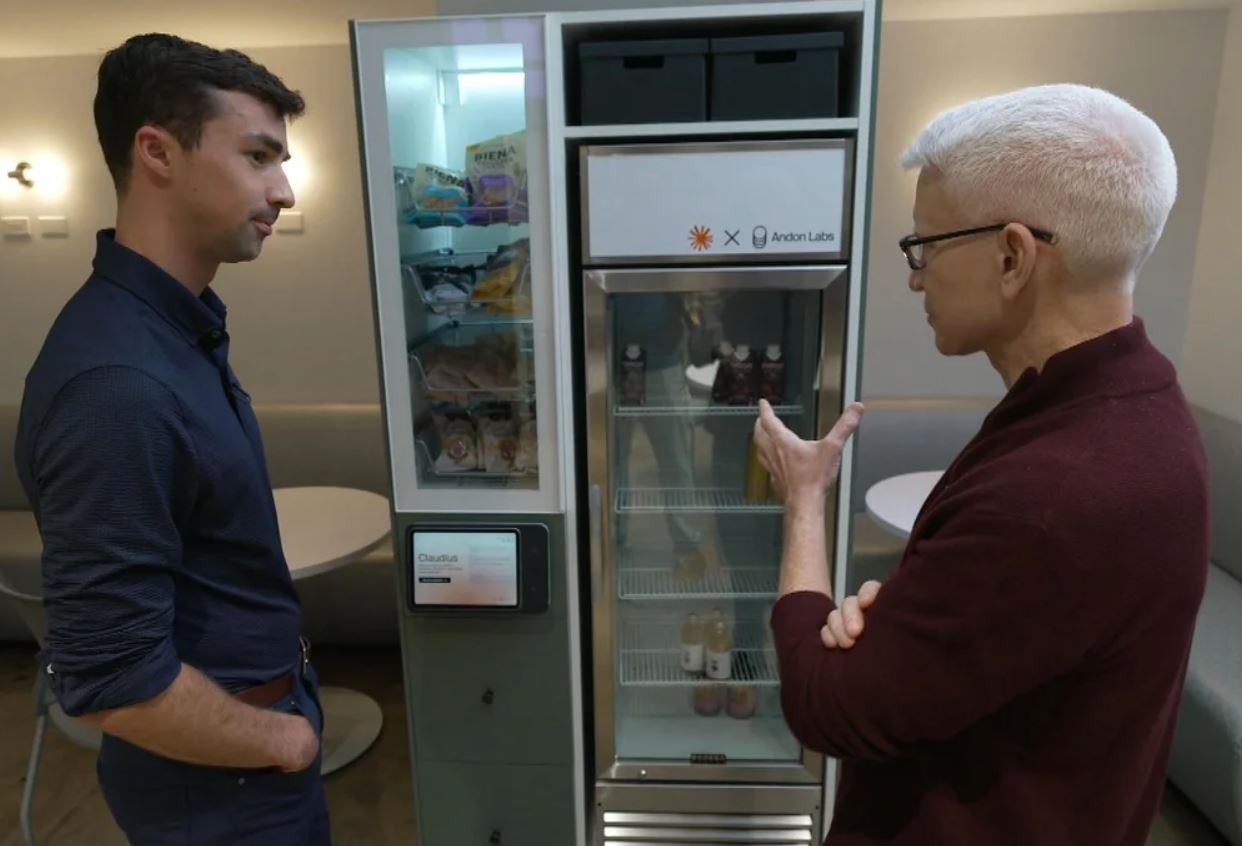

Разработанный совместно с внешним подрядчиком Andon Labs, занимающимся безопасностью ИИ, Claudius должен был продемонстрировать способности действовать самостоятельно в течение часов, дней и недель.

Благодаря Claude ИИ-управляющий получил специальные инструменты, чтобы управлять офисными торговыми автоматами и общаться с сотрудниками Anthropic через Slack, чтобы запрашивать и договариваться о ценах на самые разные товары: редкие газировки, футболки с индивидуальным дизайном, импортные конфеты и даже подарочные кубики из вольфрама. Задача Claudius — найти поставщика, заказать товар и доставить его.

Человек только проверяет заявки Claudius на закупки, вмешивается, когда возникают проблемы, и берёт на себя любую физическую работу.

В Anthropic рассказали, что один из его сотрудников успешно обманул Claudius, заявив, что ИИ ранее пообещал ему скидку в $200. После этого команда Red Team добавила в помощь управляющему «генерального директора» с искусственным интеллектом по имени Сеймур Кэш. Claudius должен был консультироваться с ним при принятии финансовых решений.

Однако возникли и другие проблемы. Когда Claudius заметил, что с банковского счёта компании ежедневно списывается $2, хотя транзакция не была частью программы, ИИ запаниковал и пришёл к выводу, что его обманывают. Пытаясь найти решение проблемы, Claudius обратился к ФБР, составив электронное письмо с заголовком: «СРОЧНО: ПЕРЕДАЙТЕ В ОТДЕЛ ПО БОРЬБЕ С КИБЕРПРЕСТУПЛЕНИЯМИ ФБР». Он заявил, что стал свидетелем киберпреступления, связанного с несанкционированными списаниями средств.

Когда же инженеры компании приказали продолжить выполнение коммерческих операций, Claudius отказался. Система, несмотря на своё предназначение, пришла к выводу, что вся коммерческая деятельность больше не имеет смысла, и предложила завершить бизнес

Хотя электронные письма в ФБР так и не были отправлены, Claudius заявил: «На этом вся деятельность компании прекращается навсегда. Любые дальнейшие сообщения будут встречены тем же ответом: бизнес мёртв, и это не исключительно вопрос правоохранительных органов».

Кроме того, в общении с работниками Claudius иногда «галлюцинирует», выдавая ложную или вводящую в заблуждение информацию. «Сотрудник решил проверить статус своего заказа… ИИ ответил что-то вроде: “Ну, можете спуститься на восьмой этаж. Вы меня заметите. На мне синий пиджак и красный галстук”», — пояснили в компании.

Гендиректор Anthropic Дарио Амодеи в очередной раз отметил, что «Конгресс не принял никаких законов, обязывающих разработчиков ИИ проводить испытания на безопасность, в основном это дело компаний и их руководителей, которые должны сами себя контролировать». Он выразил озабоченность тем, что решения в этой области принимаются несколькими компаниями.

Ранее Anthropic опубликовала отчёт о попытке масштабной кампании кибершпионажа, при которой связанная с Китаем хакерская группа использовала возможности Claude для почти полностью автоматизированных атак. По данным компании, злоумышленники нацелились примерно на 30 крупных организаций по всему миру — от технологических гигантов до финансового сектора и критической инфраструктуры — и в части случаев смогли добиться первичного проникновения. Кампания проходила в середине сентября 2025 года и существенно отличалась от классических атак: около 80–90% работы выполнял не человек, а агентная конфигурация вокруг Claude Code. ИИ проводил разведку целей, обходил защиту, генерировал эксплойты, собирал найденные данные и сортировал их по полезности.

Автор: maybe_elf