OpenAI опубликовала подробный технический разбор Codex CLI, локального агентного инструмента для работы с кодом прямо на машине пользователя. Материал особенно полезен тем, кто разрабатывает собственных агентов или оптимизирует расходы на инференс и работу с контекстом.

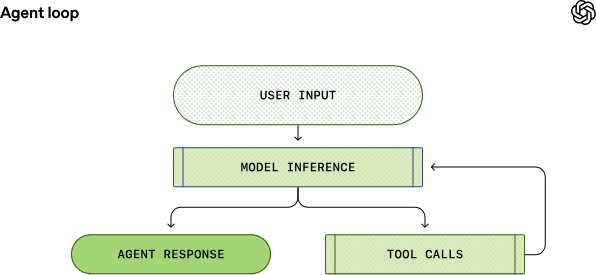

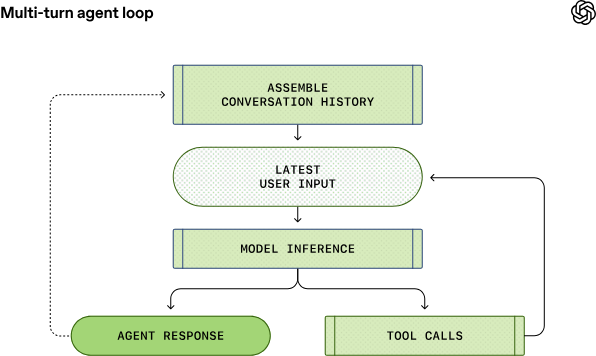

В основе Codex CLI лежит классический agent loop. Пользователь отправляет запрос, после чего система собирает большой промпт с инструкциями проекта. На инференсе модель либо отвечает текстом, либо инициирует вызов инструмента. Агент выполняет команду, добавляет результат обратно в контекст и снова обращается к модели. Цикл повторяется до тех пор, пока задача не будет завершена. Важно учитывать жесткий лимит: все инструкции из AGENTS.md и корневых директорий проекта агрегируются в один JSON размером не более 32 Кб.

Отдельное внимание уделено проблеме стоимости контекста. История диалога растет на каждом шаге и формально должна приводить к квадратичному росту затрат. Чтобы этого избежать, используется кэширование промптов. Пока префикс запроса не меняется, инференс остается линейным по стоимости. Но кэш крайне чувствителен: изменение порядка инструментов или незначительная правка конфигурации полностью сбивает кэш хиты и резко увеличивает цену запроса.

Еще одно важное изменение касается архитектуры API. Codex CLI полностью перешел на stateless модель работы. Параметр previous_response_id убрали осознанно, чтобы поддержать режимы Zero Data Retention. Провайдер не хранит состояние диалога, а даже цепочки рассуждений передаются в зашифрованном виде. Ключ остается на сервере, данные у клиента, долговременного хранения нет.

Когда контекстное окно начинает заполняться, автоматически включается механизм компакции. Вместо простого удаления старых сообщений модель сжимает их в специальный компактный блок. Он занимает минимум места, но сохраняет смысл предыдущего диалога. Процесс запускается автоматически при достижении лимита auto_compact_limit и не требует ручной команды.

Дополнительно OpenAI напомнила, что Codex CLI не привязан только к их серверам. С помощью флага –oss инструмент может работать и с локальными моделями через Ollama или LM Studio.

В следующих публикациях компания обещает подробнее разобрать архитектуру CLI, реализацию инструментов и модель песочницы Codex.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn