Разработчики, осваивающие новые навыки программирования с помощью ИИ, показывают значительно худшие результаты в тестах на знание предмета. Новое исследование, опубликованное в журнале Anthropic, вызывает опасения по поводу чрезмерного внедрения ИИ на рабочем месте.

Согласно новому исследованию компании Anthropic, занимающейся разработкой искусственного интеллекта, разработчики программного обеспечения, которые полагаются на помощь ИИ при изучении новой библиотеки программирования, хуже понимают лежащие в ее основе концепции.

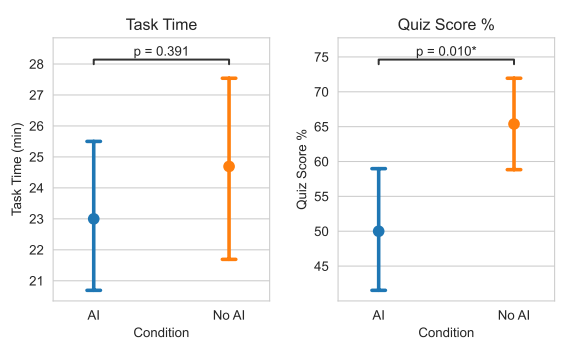

Исследователи набрали 52 преимущественно начинающих разработчиков программного обеспечения, которые регулярно работали с Python не менее года и имели опыт работы с ИИ-помощниками, но не были знакомы с библиотекой Trio. Участники были случайным образом разделены на две группы: одна имела доступ к ИИ-помощнику на основе GPT-4o, а контрольная группа работала только с документацией и веб-поиском. Обе группы как можно быстрее решили две задачи программирования с использованием библиотеки Trio.

Затем все участники прошли тест на знание используемых концепций. Участники, имевшие доступ к ИИ, показали результаты на 17 процентов хуже, чем контрольная группа. Использование ИИ также не привело к существенной экономии времени в среднем.

«Наши результаты показывают, что активное внедрение ИИ в рабочую среду, особенно в сфере разработки программного обеспечения, сопряжено с определенными компромиссами», – пишут исследователи Джуди Ханвен Шен и Алекс Тамкин.

То, как вы используете ИИ, определяет, насколько многому вы научитесь

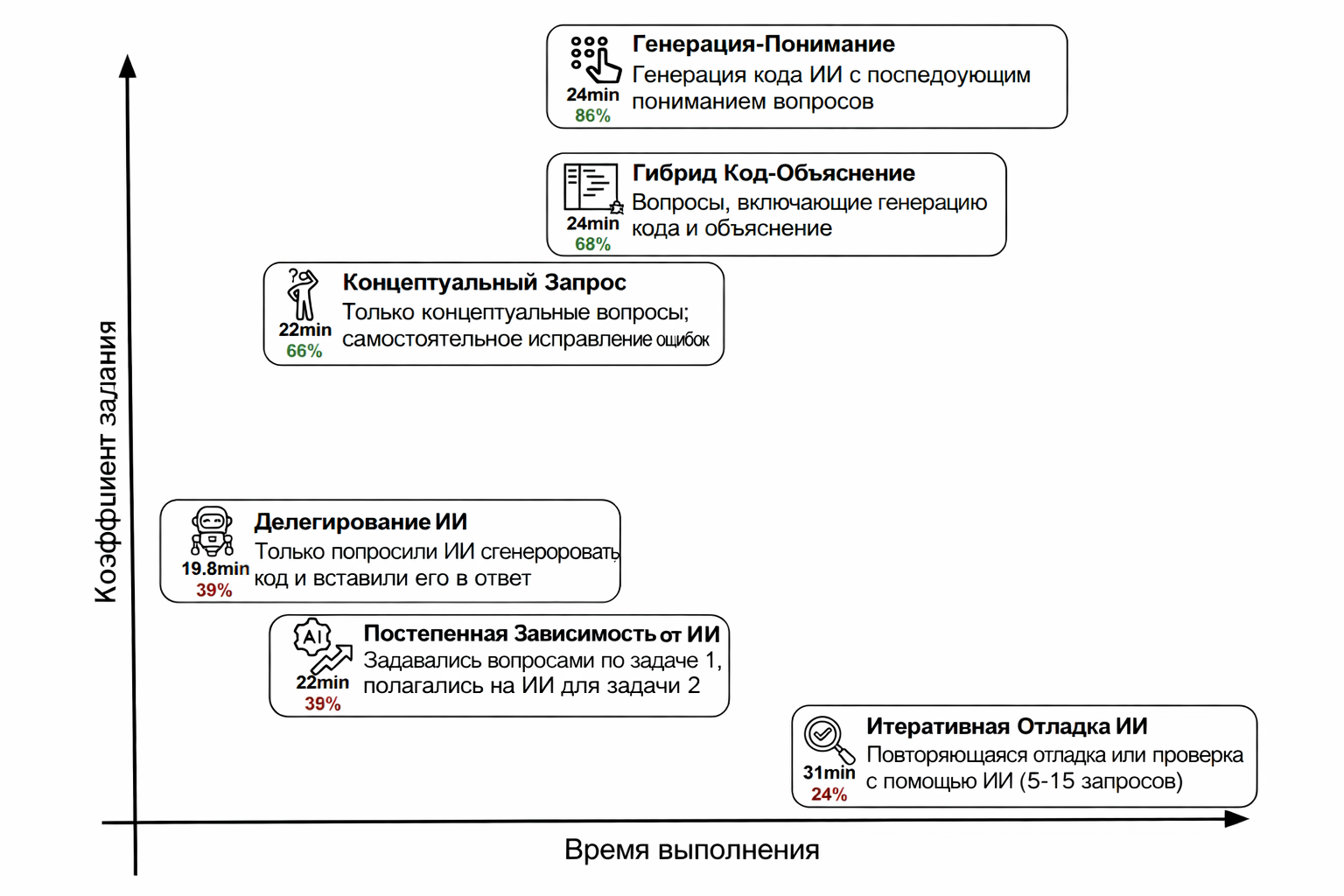

То, как разработчики взаимодействуют с ИИ, существенно влияет на результаты обучения. Качественный анализ видеозаписей экрана 51 участника выявил шесть различных моделей взаимодействия. Три из них привели к низким результатам тестирования, с оценками в викторине от 24 до 39 процентов.

Те, кто полностью делегировал задачи программирования искусственному интеллекту, справились быстрее всех, но набрали всего 39 процентов баллов в викторине. Участники, которые изначально работали самостоятельно, но все больше полагались на решения, сгенерированные ИИ, показали аналогично низкие результаты. Худшие ученики неоднократно использовали ИИ для отладки, не понимая при этом самих ошибок.

Три других подхода также показали хорошие результаты в обучении, с результатами викторин от 65 до 86 процентов. Наиболее успешной стратегией оказалась генерация кода искусственным интеллектом с последующими конкретными уточняющими вопросами. Запрос объяснений одновременно с генерацией кода также оказался эффективным, как и использование ИИ исключительно для решения концептуальных вопросов.

Слишком много разговоров снижает продуктивность

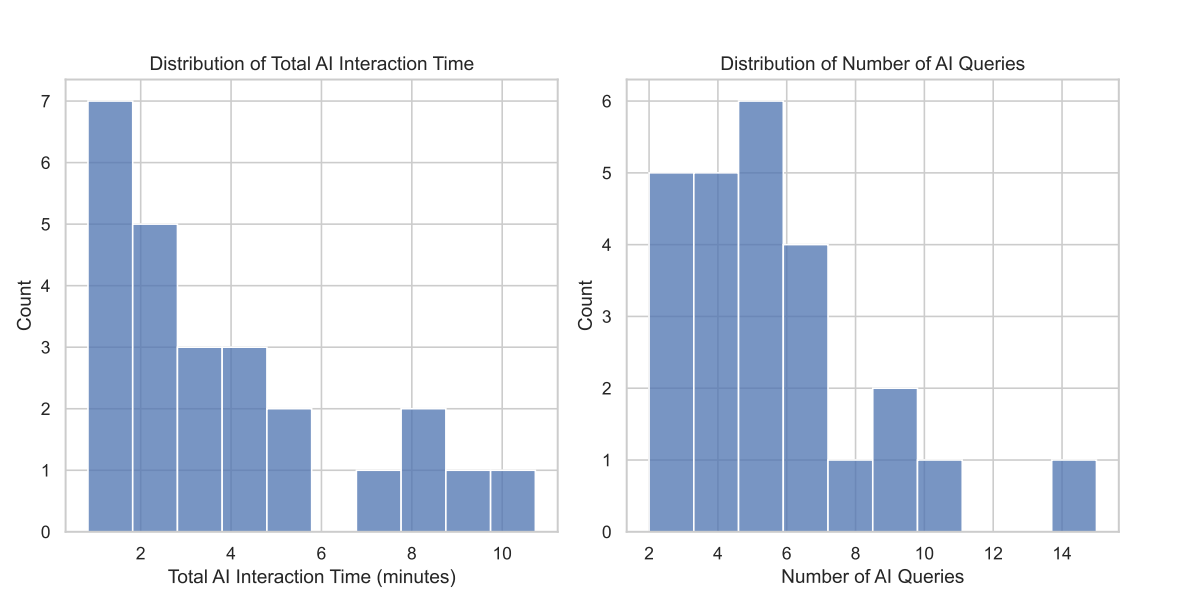

В отличие от предыдущих исследований программирования с использованием ИИ, исследователи не обнаружили повышения производительности. Пользователи ИИ статистически не показали более высокой скорости работы. Качественный анализ объясняет это: некоторые участники тратили до одиннадцати минут только на взаимодействие с ИИ-помощником, например, при создании подсказок.

Лишь около 20 процентов участников экспериментальной группы использовали помощника исключительно для генерации кода. Эта группа показала фактически более высокую скорость, чем контрольная группа, но продемонстрировала наихудшие результаты обучения. Остальные участники задавали дополнительные вопросы, запрашивали пояснения или тратили время на понимание сгенерированных решений. Исследователи предполагают, что ИИ с большей вероятностью обеспечит значительное повышение производительности при выполнении повторяющихся или знакомых задач.

Результаты, по-видимому, противоречат предыдущим исследованиям, которые выявили значительное повышение производительности труда благодаря помощи ИИ. Однако исследователи из Anthropic объясняют, что в более ранних исследованиях производительность измерялась на задачах, для выполнения которых участники уже обладали необходимыми навыками. В текущем исследовании изучалось, что происходит, когда люди учатся чему-то новому.

Совершение ошибок помогает людям учиться – искусственный интеллект этому препятствует

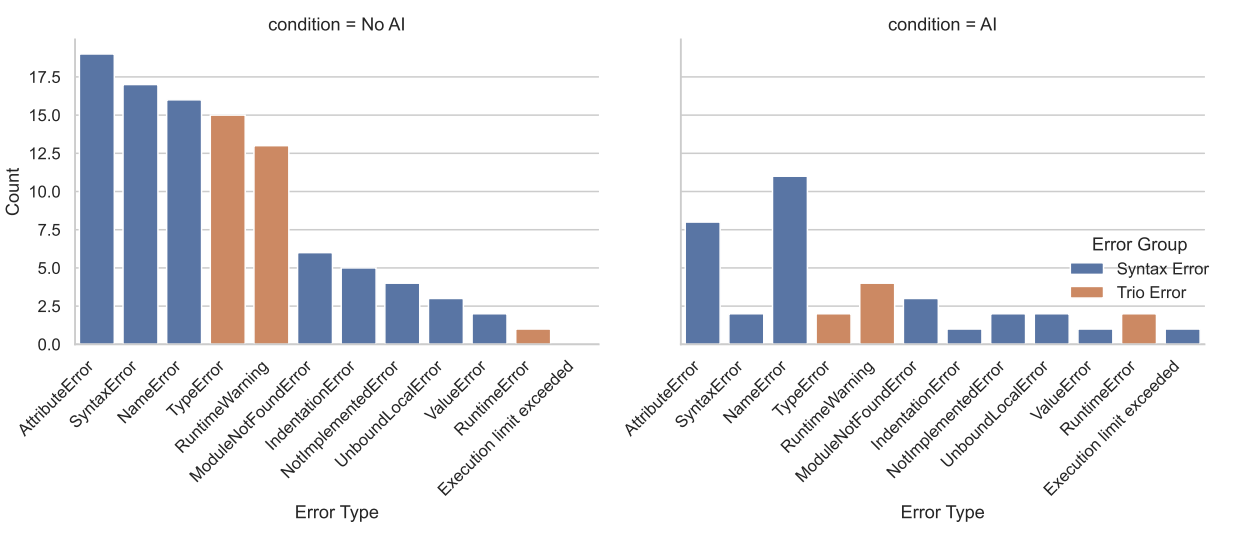

Контрольная группа без доступа к ИИ совершала больше ошибок и, как следствие, сталкивалась с ними в три раза чаще, чем группа с ИИ. Эти ошибки заставляли участников критически мыслить о коде. По мнению исследователей, такое болезненное застревание на проблеме может быть важным фактором для развития компетентности.

Наибольшие различия в результатах теста на знание материала проявились в вопросах по отладке. Контрольная группа столкнулась с большим количеством ошибок, специфичных для Trio, например, с предупреждениями о неожиданных сопрограммах во время выполнения. Этот опыт, по-видимому, помог им лучше понять основные концепции.

Квалифицированные специалисты по-прежнему крайне необходимы

Исследователи предупреждают о последствиях, особенно для критически важных приложений. Если проверка и отладка кода, сгенерированного ИИ, необходимы людям, им требуются соответствующие навыки. Но эти навыки могут атрофироваться, если использование ИИ будет препятствовать развитию навыков.

«Наши результаты показывают, что повышение производительности с помощью ИИ не является быстрым путем к компетентности, и внедрение помощи ИИ в рабочие процессы следует тщательно обдумывать, чтобы сохранить формирование навыков», – резюмируют исследователи. Ключ к поддержанию способности к обучению заключается в когнитивных усилиях: разработчики, которые используют ИИ только для решения концептуальных вопросов или запрашивают объяснения, могут эффективно продолжать обучение.

В исследовании рассматривалось только задание, выполняемое в течение одного часа, с использованием чат-интерфейса. Системы искусственного интеллекта на основе агентов, такие как Claude Code, которые требуют еще меньше участия человека, могут усугубить негативное влияние на развитие навыков. Проявляются ли аналогичные эффекты в других областях интеллектуального труда, таких как написание текстов или дизайн, пока не изучалось, но компания Anthropic уже работает над автоматизацией этих задач, не связанных с программированием, с помощью таких инструментов, как Claude Cowork.

Тем не менее, стоит отметить, что компания Anthropic опубликовала исследование, результаты которого потенциально могут навредить её собственной бизнес-модели. Компания зарабатывает деньги на ИИ-помощниках, таких как Клод, разработанных для помощи людям на работе. В технологической индустрии, особенно в наши дни, тот факт, что исследовательский отдел компании может открыто предупреждать о недостатках этих продуктов, не является чем-то само собой разумеющимся.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: MrRjxrby