Бенчмарки стали неотъемлемым инструментом для компаний: они позволяют понять, какие модели лучше соответствуют их задачам. Но далеко не все тесты одинаково полезны — многие из них строятся на статичных датасетах и искусственных условиях.

Исследователи из Inclusion AI, связанной с Ant Group корпорации Alibaba, предложили новый формат рейтинга и тестирования моделей. Он делает акцент на том, как языковые модели ведут себя в реальных сценариях, и оценивает не только их знания, но и то, насколько пользователям нравятся их ответы.

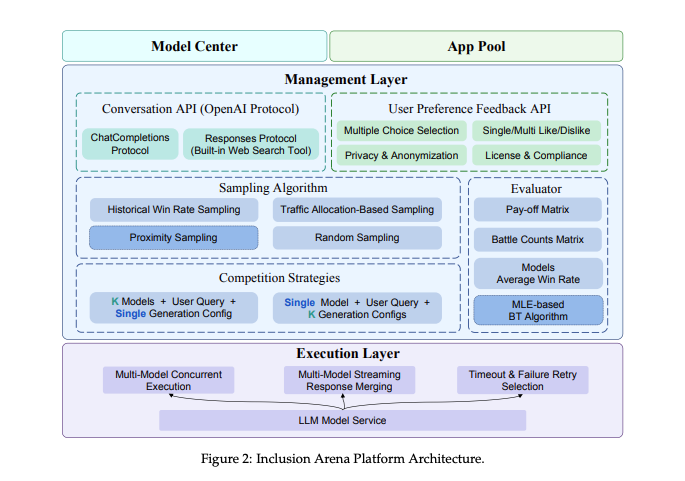

В своей работе учёные описали платформу Inclusion Arena — живой лидерборд, который ранжирует модели по предпочтениям пользователей.

«Чтобы закрыть пробелы, мы предлагаем Inclusion Arena — живой рейтинг, который соединяет реальные AI‑приложения с передовыми LLM и MLLM. В отличие от краудсорсинговых решений, наша система случайным образом запускает „битвы моделей“ прямо во время многотуровых диалогов человек — ИИ в настоящих приложениях», — говорится в статье.

Inclusion Arena выгодно отличается от привычных рейтингов вроде MMLU и OpenLLM своей привязанностью к практике и оригинальным методом ранжирования. Она использует модель Брэдли — Терри, знакомую по Chatbot Arena.

Принцип прост: Inclusion Arena интегрируется в реальные AI‑приложения, собирает данные и проводит оценки с участием людей. Авторы признают, что пока количество приложений ограниченно, но ставят цель создать открытую экосистему, где смогут участвовать многие.

Сегодня рынок наводнён всевозможными рейтингами: у каждой новой LLM от OpenAI, Google или Anthropic почти сразу появляются показатели в разных тестах. Так, Grok 3 от xAI сумел выбиться в лидеры Chatbot Arena. Но исследователи из Inclusion AI настаивают: их система лучше отражает настоящую пользу моделей, а значит, компаниям‑клиентам будет проще делать осознанный выбор.

Метод Брэдли — Терри

Inclusion Arena вдохновлена Chatbot Arena и использует метод Брэдли — Терри. Для сравнения, Chatbot Arena также применяет параллельно метод Эло.

Большинство рейтингов строятся именно на системе Эло — знакомой по шахматам, где она определяет относительный уровень игроков. Оба метода являются вероятностными моделями, но исследователи отмечают: Брэдли — Терри даёт более стабильные результаты.

«Модель Брэдли — Терри предлагает надёжный инструмент для выявления скрытых способностей на основе попарных сравнений, — говорится в статье. — Однако на практике, особенно при большом и постоянно растущем числе моделей, полный перебор всех пар становится чрезмерно затратным и по ресурсам, и по времени. Поэтому нужны умные стратегии сражений, которые позволят выжать максимум информации при ограниченном бюджете».

Чтобы упростить процесс ранжирования в условиях множества моделей, Inclusion Arena дополнила систему двумя механизмами: placement match и proximity sampling. Первый помогает оценить стартовую позицию для новых участников рейтинга, второй — ограничивает сравнения рамками доверительного «соседства», то есть моделей схожего уровня.

Как это работает

Итак, как же устроена система? Фреймворк Inclusion Arena встраивается в AI‑приложения. На данный момент доступно два: чат с персонажами Joyland и образовательная платформа T‑Box. Когда пользователи взаимодействуют с приложениями, их запросы незаметно отправляются сразу нескольким LLM. Ответы возвращаются, а пользователи выбирают тот, что понравился больше, — не зная, какая модель стоит за ним.

На основе этих предпочтений система формирует новые пары для сравнения. Далее алгоритм Брэдли — Терри высчитывает итоговый балл для каждой модели, который и формирует рейтинг.

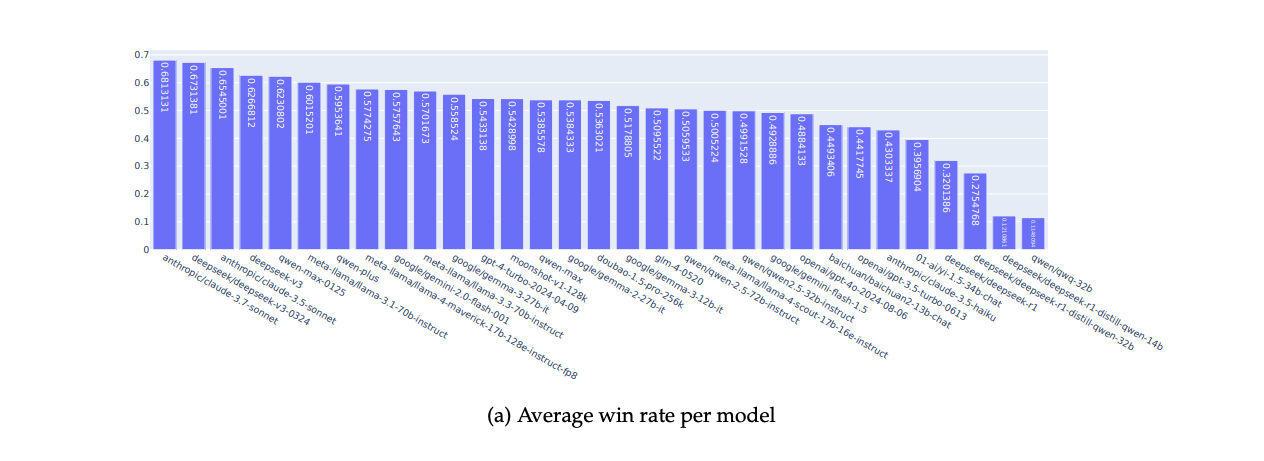

Эксперимент Inclusion AI завершился на июле 2025-го и включил 501 003 попарных сравнения.

По первым результатам самыми сильными оказались: Claude 3.7 Sonnet, DeepSeek v3-0324, Claude 3.5 Sonnet, DeepSeek v3 и Qwen Max-0125.

Нужно отметить, что данные были собраны всего в двух приложениях с аудиторией 46 611 активных пользователей. Исследователи уверены: чем больше данных, тем точнее и устойчивее станет лидерборд.

Больше рейтингов — больше выбора

Чем больше появляется новых моделей, тем сложнее компаниям понять, с какой начать тестирование. Рейтинги и бенчмарки помогают техническим директорам сузить круг и выбрать претендентов для дальнейшей проверки. Конечно, окончательная оценка должна проходить внутри организации.

При этом такие лидерборды дают представление и о глобальной картине: видно, какие модели постепенно догоняют лидеров. Так, свежие тесты вроде RewardBench 2 от Allen Institute for AI пытаются соотнести модели именно с реальными сценариями их использования в бизнесе.

Делегируйте рутинные задачи вместе с BotHub! По ссылке вы можете получить 100 000 бесплатных капсов и приступить к работе с нейросетями прямо сейчас.

Автор: dmitrifriend