Меня зовут Евгений, я работаю разработчиком в Университете Кембриджа (UK). В начале апреля я запустил llm7.io – полностью бесплатный LLM-провайдер, совместимый с популярными библиотеками chat completion. Цель была простая: проверить, насколько эффективно можно построить отказоустойчивую архитектуру под настоящую high-load-нагрузку, и при этом дать всем желающим доступ к мощным языковым моделям – без регистрации, API-токенов, смс и прочих барьеров.

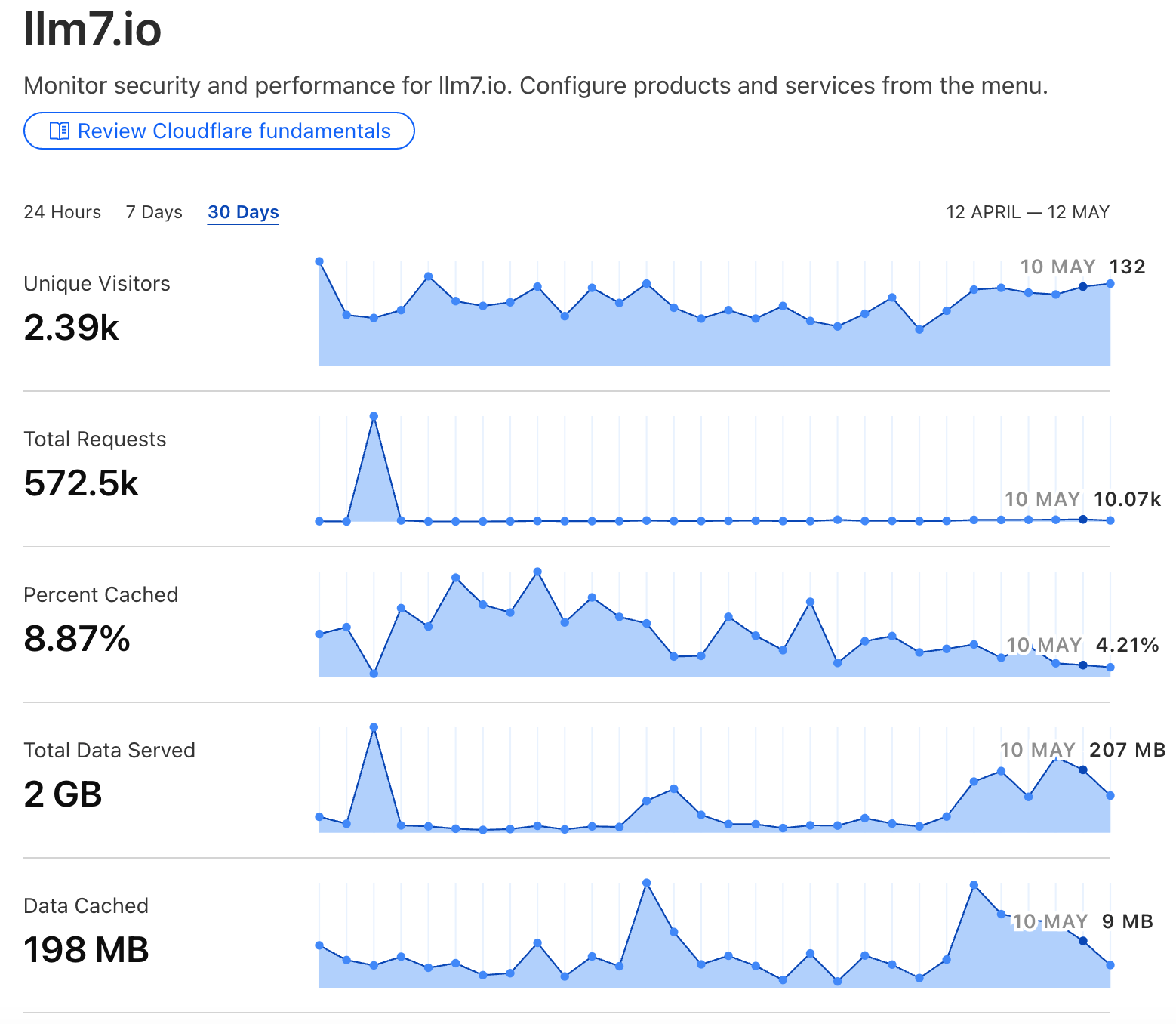

Через месяц после запуска: 572 000+ обработанных запросов. Делюсь опытом, выводами и тем, чего не ожидал.

Зачем?

-

Хотел протестировать свои инженерные навыки под боевой нагрузкой.

-

Хотел дать исследователям и разработчикам простой и прямой доступ к топовым LLM без лишней бюрократии.

-

Хотел собрать анонимизированный семантический кэш для возможного [до]обучения своих моделей в будущем.

Что произошло за месяц?

1. 462 000 запросов за одни сутки

Неожиданный эпизод случился 14 апреля – сервис внезапно получил 462 000 запросов за один день. Похоже, кто-то использовал его для массовой обработки на относительно большом дата-сете. Я был уверен, что сервис упадёт. Не упал. Архитектура справилась, и это стало хорошей проверкой на прочность.

В остальные дни трафик стабилизировался – максимум был около 10 000 запросов в сутки.

2. Ошибки 400

Логи показали интересную картину: многие пользователи не утруждают себя выбором подходящих моделей. Например, отправляют изображения в текстовые модели (я наблюдал массовые 400 из-за некорректных запросов клиентов), которые вообще не поддерживают мультимодальность. Причём продолжают слать их в цикле и даже находят меня в соц сетях и пишут с просьбой «починить ошибку» сервиса 🤪.

Решение: я не стал блокировать такие запросы, а реализовал автоматическое перенаправление на подходящие модели.

3. Адулт-контент и тесты на «прочность»

Как показывает практика, одним из основополагающих классов тестирования LLM на пользовательский ввод – это отнюдь не “умные” вопросы с целью решить задачку из дата-сета MATH.

-

Часть пользователей активно проверяют LLM на грани цензуры. Даже при анонимизации семантика запросов местами была таковой, что у инженера далекого от специфики – волосы встанут дыбом.

-

По логам видно, что кто-то запускал ботов, массово генерирующих неприемлемый контент – это подтверждается ошибками по Policy Violation от самих моделей.

Хорошо, что современные модели имеют базовые защитные фильтры. Но вопрос борьбы с завуалированной токсичностью и обходами цензуры – это отдельная инженерная задача, которой я теперь тоже всерьёз интересуюсь, чтобы корректно обучать собственные модели.

4. Бесплатное – значит подозрительное?

Многие пользователи… боятся пользоваться бесплатным сервисом. Когда рядом бесплатный, дешевый и дорогой – выбирают платный. Психология: если платишь, значит это надёжно. Удивительно, но факт. Здесь важную роль играет и UX — отсутствие красивого лендинга или привычного onboarding-а снижает доверие, даже если технически всё работает отлично.

5. Клиентские библиотеки – есть, но нужен трафик

Я написал простые клиенты:

Они позволяют работать с llm7.io без регистрации – просто установи и используй. Но пока пользователей немного. Если у вас есть идеи, как масштабировать проект и привлечь аудиторию – буду рад услышать в комментариях.

Выводы

-

Архитектура прошла боевое крещение.

-

Ввод пользователя – это испытание и для моделей, и для серверной части.

-

Бесплатный сервис – это не только про доступность, но и про сложную инженерию, фильтрацию и пр.

-

Я получил уникальный опыт, увидел реальные паттерны использования LLM, и готов продолжать эксперимент.

Спасибо за внимание! Если вам было интересно – поддержите и поделитесь, пожалуйста, статьёй (так я буду видеть интерес аудитории и feedback). Если нагрузка ещё вырастет или появятся новые инсайты – обязательно напишу продолжение.

Пишите в комментарии - буду рад обсудить идеи и фидбэк.

Автор: evgeniievstafev