Всем привет! Меня зовут Николай Никитин, я руковожу лабораторией автоматического машинного обучения в Институте ИИ ИТМО. Сегодня я бы хотел сделать небольшой экскурс в то, как методы и модели ИИ позволяют автоматизировать решение прикладных задачам в разных областях науки.

Нейросети уже достигли впечатляющих результатов ― вспомним хотя бы нобелевскую премию по химии прошлого года, выданную за методы фолдинга белков, проработанные с участием AlphaFold. И различные полезные для ученых решения, появляются каждый день во многих областях.

Под катом ― о том, как AI4Science выглядит сегодня, почему всю науку нельзя отдать на откуп LLM и в какой форме они наиболее полезны.

ИИ в науке

Сегодня ИИ в науке «на хайпе». Машинное (в частности, глубокое) обучение применяется во многих областях для:

-

сжатого представления научных данных;

-

генерации и проверки гипотез;

-

предсказания свойств и поведения объектов;

-

оптимизации по заданному критерию.

Наглядный пример ― фармацевтика. ИИ позволяет ускорить первый этап разработки ― генерацию и проверку гипотез, причем чуть ли не на годы, поскольку параллельно можно проверять несколько идей.

Но есть и открытые проблемы:

-

Не всегда ясно, как именно применять ИИ к научным задачам. Как правило, ученые (химики, физики) глубоко не погружены в область LLM, поэтому к решению задач приходится привлекать дата-сайентистов и вместе с учеными предметниками они приходят к отличным результатам. Однако такие команды с сочетанием навыков ― большая редкость. Задач, требующих решения, намного больше. Как научному миру работать без этой «индустриальной» поддержки?

-

Надо генерировать новые гипотезы и проверять их. Но непонятно, как это делать с учетом проблем галлюцинаций и сложности валидации. Можно ли доверять моделям ИИ в принципе?

Что такое AutoML

Одно из решений первой проблемы ― автоматизация применения существующих моделей и практик машинного обучения ― AutoML. Подобные инструменты позволяют предобрабатывать данные, заполнять пропуски, конструировать и отбирать признаки, строить ансамбли, выбирать одну или несколько моделей для обучения, а также оптимизировать гиперпараметры.

Для решения таких задач уже есть множество инструментов:

-

Отбирают признаки: Tsfresh, Meyda, pliers.

-

Синтезируют новые признаки: Featuretools, OpenFE, AutoFeat, Upgini.

-

Настраивают гиперпараметры: Optuna, Tune, hyperopt, Ray, iOpt.

-

Объясняют решения ИИ: Shap, Interpret, Lucid.

-

Ищут архитектуру нейронных сетей: NNI, Determined, AutoPyTorch, AutoKeras.

-

Полноценно реализуют подход AutoML: TPOT, H2O, AutoGluon, LightAutoML (разрабатывают в Сбере), FEDOT (этот мы разрабатываем в ИТМО своими силами: ссылка на GitHub) и другие.

-

Объединяют LLM и AutoML: AutoKaggle, AIDE, Google DS Agent, SELA, AutoML-Agent, FEDOT.LLM, LightAutoDS.

В целом, существующие инструменты решают целый спектр задач:

-

на классификацию / регрессию на табличных данных или временных рядах;

-

на прогнозирование на временных рядах;

-

на computer vision;

-

на мультимодальность;

-

без учителя (например, выявление аномалий).

Однако про эти инструменты надо знать и уметь ими пользоваться! И хотя каждый новый AutoML инструмент заявляет, что теперь «всё можно сделать в три строчки кода», на практике здесь возникают сложности. Самая большая проблема ― от общих постановок из учебника перейти к формализованной корректной постановке задачи для имеющегося у ученых датасета. Это не всегда получается успешно: тут нужно сочетать как предметные знания о решаемой задаче (правильную интерпретацию признаков, способы их преобразования, критерии для выбора решений), так и теорию и практику машинного обучения (типы моделей, способы обучения и валидации и другое).

Почему наука и индустрия неохотно используют AutoML

Что в науке, что в индустрии AutoML пока применяют ограниченно ― в том числе потому что неспециалисту (именно в data science) сложно формулировать задачи в терминах машинного обучения. Часто половина успеха ― это анализ семантики данных, который приходится делать вручную. Причем формулировать признаки надо, будучи специалистом в предметной области, иначе результат не будет иметь особой ценности. Если сформулировать задачу неправильно, она будет решена по крайней мере неэффективно.

Ну и вдобавок, результаты работы AutoML ― что в глубоком обучении, что в сложных пайплайнах классического машинного обучения ― плохо интерпретируются. А «предметники» хотят понимать, что же происходит.

Вот как может выглядеть постановка задачи, привычная для (Auto)ML:

task_type: ‘multiclass_classification’, target – ‘shape’, quality_metric – ROC_AUC

А вот так постановка задачи, привычная для ученого:

Определи форму наноматериала для следующих условий синтеза <…>, используя данные экспериментов <…>

Перейти от одной формулировки к другой непросто даже в простых задачах машинного обучения. А если нужны физико-информированные или композитные (гибридные) модели, структура которых состоит из операций разной «математической природы», то все становится еще сложнее. Между тем, для некоторых задач сборка гибридной структуры ― единственный путь качественного решения.

Мы сталкивались с такими задачами, например, когда искали совместно с Центром химии ИТМО кокристаллы с нужными механическими свойствами (то есть, грубо говоря, пытались найти решение, чтобы таблетки не крошились ― решение этой задачи описано в статье Gubina N. et al. Hybrid generative AI for de novo design of co-crystals with enhanced tabletability //Advances in Neural Information Processing Systems. – 2024. – Т. 37. – С. 84606-84644 на main-трек топовой конференции в области ИИ NeurIPS 2024 и можно почитать здесь).

В одном пайплайне нам пришлось объединить и GAN-ы, и трансформеры, и эволюционную оптимизацию (кстати, за это решение мы даже получили бронзовый приз престижного конкурса human-competitive разработок, прошедшего в рамках конференции GECCO 2025). Но чтобы разобраться в этом, надо быть не просто дата-сайентистом, а еще и иметь образование в матмоделировании и матфизике. И это становится барьером внедрения уже известных ML-решений в науку.

LLM и ИИ-ассистенты

Пытаясь нивелировать эти сложности, многие команды в мире, как и мы в ИТМО, пошли в направлении «разговорных» ИИ-ассистентов. Это кажется логичным решением, ведь LLM могли бы:

-

проанализировать неформализованную постановку задачи и входные данные (с учетом общих и предметных знаний), переварив все это в нечто структурированное;

-

отобрать, сгенерировать и преобразовать признаки;

-

сконфигурировать запуск AutoML;

-

оптимизировать решение;

-

интерактивно провзаимодействовать с пользователем.

Бессмысленно делать специализированные ИИ-системы для каждой узкой научной области с нуля ― точность профильных инструментов превзойти сложно. Однако ассистента можно сделать «надстройкой» над уже существующими нишевыми продуктами. Такая «надстройка» может декомпозировать вопрос и вызвать нужные инструменты ― это полезно, поскольку в научных задачах зачастую есть десяток подзадач, которые нужно решать в правильном порядке.

Грубо говоря, если мы ищем молекулу с нужными свойствами, бесполезно сразу спрашивать у LLM правильный ответ. Она выдаст какую-то «усредненный» ответ и с ее точки зрения этот ответ будет вроде бы правильным (молекула же!). На практике в этом случае эффективнее использовать множество узких инструментов для расчета свойств, проверки гипотез и тому подобного. Бывает, что доступных инструментов для конкретного этапа тысячи ― но нужно выбрать оптимальный. И вот тут LLM может быть полезнее ― модель может обратиться к этим инструментам и обеспечить их правильное взаимодействие. Для решения таких задач на основе LLM создаются агентные и мульти-агентные системы, объединяющие несколько «ролей» и «инструментов» для решения сложных задач.

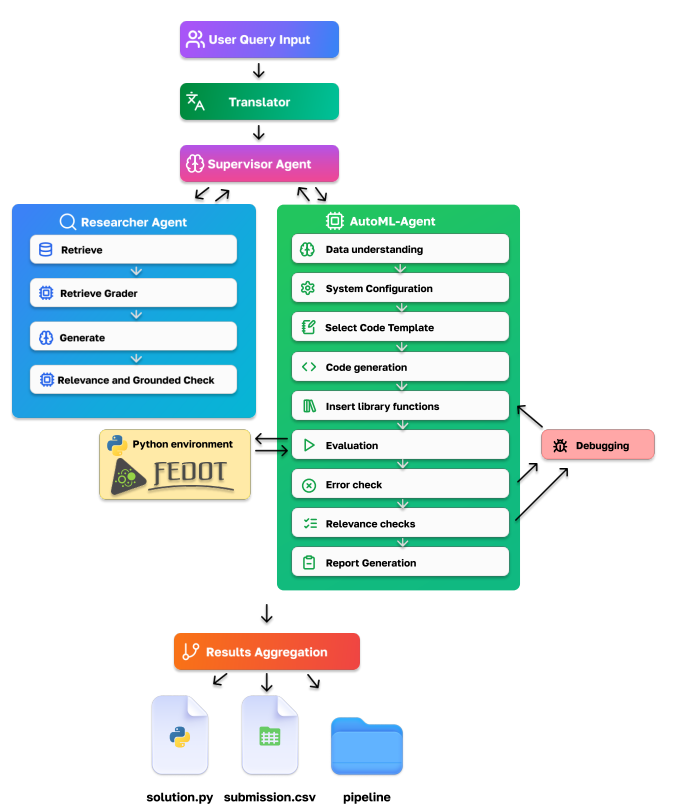

Мы в ИТМО сделали прототип AutoML-решения на базе LLM ― фреймворк FEDOT LLM. В нем можно текстом описать, что именно хочется сделать, а на выходе получить Jupiter-notebook и соответствующий код, который решает задачу с помощью существующих инструментов. Конечно, это направление требует дальнейшего развития.

Другое наше исследование в этой области ― совместная со Sber AI Lab разработка LightAutoDS-Tab, представляющая собой мультиагентную систему для автоматизации решения задач data science на табличных данных.

Одна из реализаций помощника для ученого ― ИИ-ассистент химика, где LLM-агент взаимодействует с генеративными и прогностическими инструментами. По аналогии с Copilot в разработке мы назвали инструмент ChemCoScientist.

Как всё реализовано:

-

Наш ассистент оптимизирует взаимодействие со специализированными генеративными методами через чат.

-

Далее выбирает подходящий генеративный метод для решения поставленной задачи (без участия человека).

-

И наконец, автоматизирует обучение моделей с помощью FEDOT.

Результаты этого исследования скоро будут представлены на конференции EMNLP (трек Findings) и demo-треке конференции ICDM. Также, мы выложили свою реализацию в open source ― вот ссылка. О том, почему открытый код в науке важен, мы уже писали в блоге на Хабре. Мы даже сделали инструмент, который помогает лучше оформить репозитории с кодом, сократив рутину ― а о нем подробно рассказали в этой статье.

Вместо заключения

Если резюмировать, то становится понятно: в лоб использовать LLM в науке получается плохо. Модели просто захлебываются в сложности задач, либо решение стоит невероятно дорого. Но мультиагентные системы на сегодняшний день ― фронтир в области ИИ в науке, так как они позволяют декомпозировать сложные задачи на несколько более простых (что снижает уровень требований к LLM), использовать существующий предметный задел в области специализированных алгоритмов, инструментов и моделей, а также минимизировать галлюцинации и обеспечить итеративное уточнение ответов. Один из впечатляющих примеров ― недавние результаты по автоматическому выполнению исследования в области ML и генерации статьи, принятой на конференцию уровня А* (ссылка). Кроме того, весьма перспективны исследования в области автоматического создания мульти-агентных систем для конкретных задач.

Однако, такие системы не способны полностью заменить ученых ― и это не представляется возможным даже в обозримом будущем. В тоже время, когда ученый и ИИ-ассистент объединят усилия ― результат может быть ошеломительным.

Еще напоминаю, что на базе Университета ИТМО работает сообщество любителей открытого кода Научный опенсорс ― здесь можно найти советы по разработке и поддержке своего ПО и обсудить насущные вопросы. Сообщество открыто для всех желающих, присоединяйтесь!

Автор: itmo