В Лаборатории искусственного интеллекта «Финама» мы изучаем и развиваем применение ИИ в домене финансов: от бенчмаркинга LLM до прикладных сценариев в трейдинге и управлении рисками. Сегодня хотим поделиться с вами нашим исследовательским проектом.

В последнее время мы все чаще встречаем новости вроде “ИИ от OpenAI взял «золото» Международной олимпиады по информатике”. Главное преимущество такого формата оценки — уверенность, что задания оригинальные и что, при обучении модели они не встречались в идентичном виде.

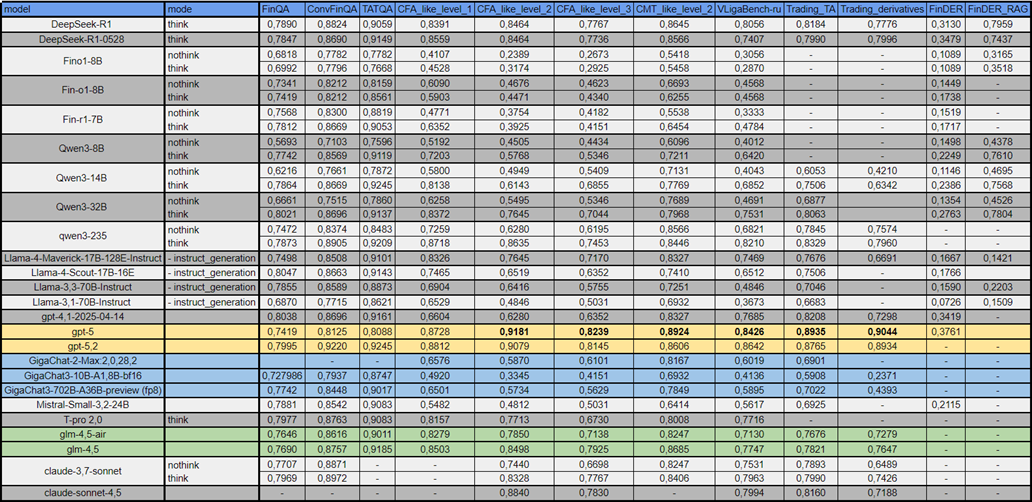

Наша лаборатория поставила себе задачу узнать — насколько обширны знания LLM в области экономики, финансов и трейдинга. Вначале мы тестировали модели на открытых Question Answering (QA) бенчмарках (FinQA, ConvFinQA, TATQA), но столкнулись с несоответствием результатов на бенчмарках и в реальном hands-on тестировании.

В результате мы пришли к идее использовать для оценки LLM форматы, близкие к существующим сертификационным экзаменам, которые сдают инвесторы для подтверждения своей квалификации CFA-like Level 1, 2, 3 (Chartered Financial Analyst) и CMT-like Level 2 (Chartered Market Technician).

Для проверки того, знают ли модели специфику российского рынка, мы собрали бенчмарк на основе олимпиады «Высшая лига» по трекам «Финансы и инвестиции» и «Мировая экономика».

В открытом доступе (GitHub) опубликованы не только результаты наших замеров, но и единый фреймворк, поддерживающий как наши новые бенчмарки, так и уже существующие. Надеемся, это поможет развитию LLM4Trading!

Детали подготовки бенчмарков

-

CFA–like Level 1, 2, 3 – Искали на просторах интернета доступные dumps. Ряд вопросов вытаскивали из книг, аугментировали несколькими моделями:

○ генерация вариантов на основании реальных примеров, как референса, и новой информации на которой будет базироваться вопрос (q) (модель 1)

○ выбор лучшего варианта (n_q) – голосованием (модель 2, 3, 4)

○ попытка восстановить общие характеристики из n_q и q. Вопрос отбирается если перекрытие по всем параметрам 0.9

-

CMT-like Level 2 – аналогично CFA-like Level 1, 2, 3

-

Trading_TA – формирование вопросов на основании книг по техническому анализу, использовали всё, что доступно: тест глав и формирование вопросов к ним; задания после глав с ответами на них (вопрос и ответ из различных источников); вопросы и ответы авторов изданий;

-

Trading_Derivatives – основан на заданиях из книги John C. Hull — Options, Futures and Other Derivatives. В качестве gold_answer взяты авторские ответы на данные задания.

-

VLigaBench‑ru – все задания взяты из открытых олимпиадных заданий «Высшая лига» по трекам «Финансы и инвестиции» и «Мировая экономика».

Что именно мы апробировали

-

Базовые существующие финансовые бенчмарки:

○ FinQA — арифметика по отчетности и текст‑табличным данным; 1147 вопросов; есть chain‑of‑thought и точные формулы.

○ ConvFinQA — то же, но в диалоговом формате; 420 диалогов, 1488 вопросов.

○ TATQA — интеграция текста и таблиц; 1668 вопросов.

-

Новые собранные нами наборы (экзамены и трейдинг):

○ CFA-like Level 1 — базовые дисциплины (этика, экономика, учет, инвестиции); 1069 вопросов; MCQ.

○ CFA-like Level 2 — продвинутые кейсы и многошаговые расчёты; 293 вопроса.

○ CFA-like Level 3 — портфельные стратегии, риск‑менеджмент, этика; 318 вопросов.

○ CMT-like Level 2 — технический анализ, индикаторы, риск, статистика; 251 вопрос.

○ VLigaBench‑ru — русскоязычные олимпиадные задачи по экономике и финансам; 324 задачи.

○ Trading_TA — паттерны, моментум, правила входа, оптимизация систем; 413 заданий.

○ Trading_Derivatives — опционы, арбитраж, синтетика; 544 задания; формульные ответы.

-

Explainability и RAG:

○ FinDER — многошаговое рассуждение по документам с обязательными обоснованиями; 2837 вопросов.

○ FinDER_RAG — та же постановка с retrieval‑augmented generation (проверяем привязку к источникам).

Как мы оцениваем модели

Параметры генерации

Мы решили воспользоваться параметрами, рекомендованными авторами моделей (в тех случаях, когда они были указаны)

Инференс

Чаще всего использовали сервис openrouter для больших и закрытых моделей. Но часть моделей запускали локально через vLLM и проводили замеры (например для Fin-o1-8B, Fin-R1 и др.). При локальных замерах, по возможности старались явно контролировать режим рассуждений моделей, также усиливали данный эффект sys-prompt.

Оценка

Все оценки проводили с помощью судьи, в нашем случае судьей всегда выступала openai/gpt-4.1. Промпты для оценки были зафиксированы в самом начале, их явно можно улучшить, но это будущие шаги. Паттерны предшествующие вопросам также для всех моделей статичны.

К самому «сочному»: замеры моделей

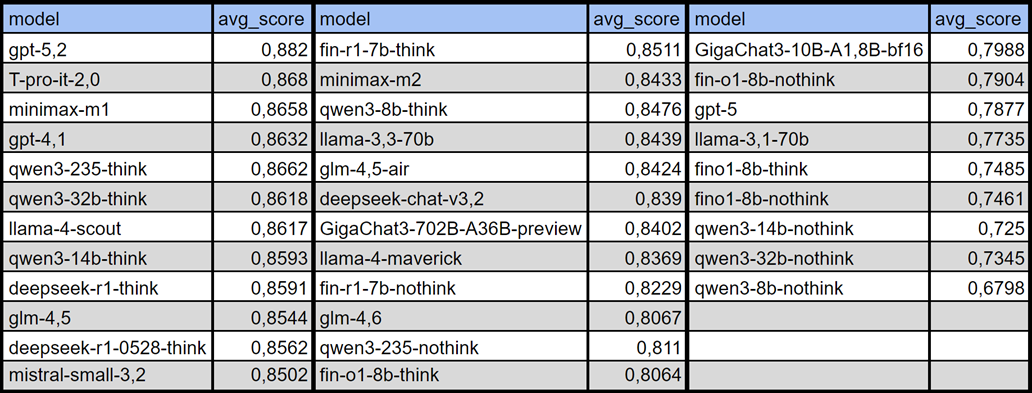

С абсолютными значениями не всегда понятно. Попробуем по рангам?

Алгоритм ранжирования по доменам

Для каждого домена задан свой набор метрик (например, exams_like, trading и т.д.). Ранжирование внутри домена устроено так:

-

Фильтрация по NaN

В доменный рейтинг попадают только модели, у которых заполнены все метрики домена.

Если по хотя бы одной метрике домена значениеNaN, модель из этого доменного рейтинга исключается. -

Ранги по отдельным метрикам

Для каждой метрики домена модели сортируются по убыванию значения (чем выше — тем лучше), и считается ранг: ранг

1— лучшая модель по данной метрике. -

Средний ранг по домену

Для каждой модели считаем средний ранг по всем метрикам домена

-

Финальный ранг модели в домене

Модели сортируются по domain_avg_rank (меньше — лучше) и получают финальный ранг

Результаты

domain_rank_public_benchs

exams_like_rank

trading_rank

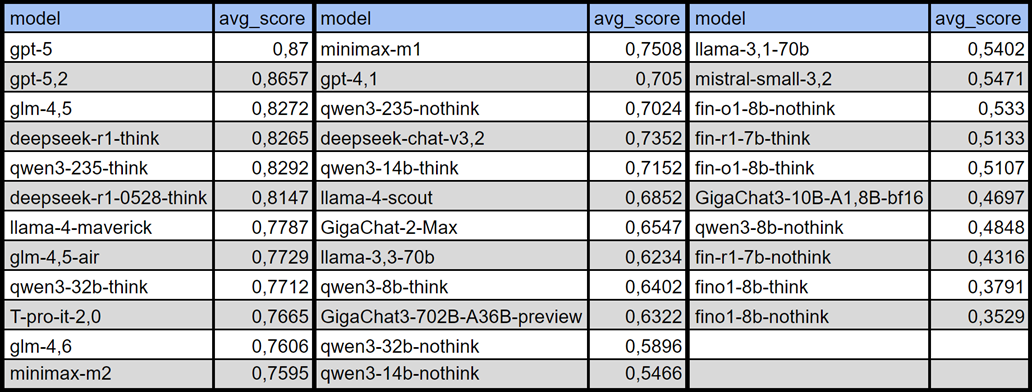

Интегральный рейтинг: exams_like + trading

Интегральный рейтинг объединяет два домена:

-

exams_like_rank, -

traiding_rank.

Построение идет в несколько шагов.

-

Пересечение моделей

В интегральный рейтинг попадают только модели, которые присутствуют одновременно в обоих доменных рейтингах (inner join по

model). То есть по ним есть полный набор метрик и вexams_like, и вtrading. -

Нормировка доменных рангов

Доменные ранги переводятся в шкалу [0,1] через min-max нормализацию. Далее вычисляется среднее значения нормализованных рангов внутри доменов. Этот шаг необходим для увеличения устойчивости к разному число моделей, которые были замерены внутри доменов.

-

Интегральный нормированный скор

Модели сортируются по

integrated_norm_score(меньше — лучше) и получают финальный ранг.

Результаты

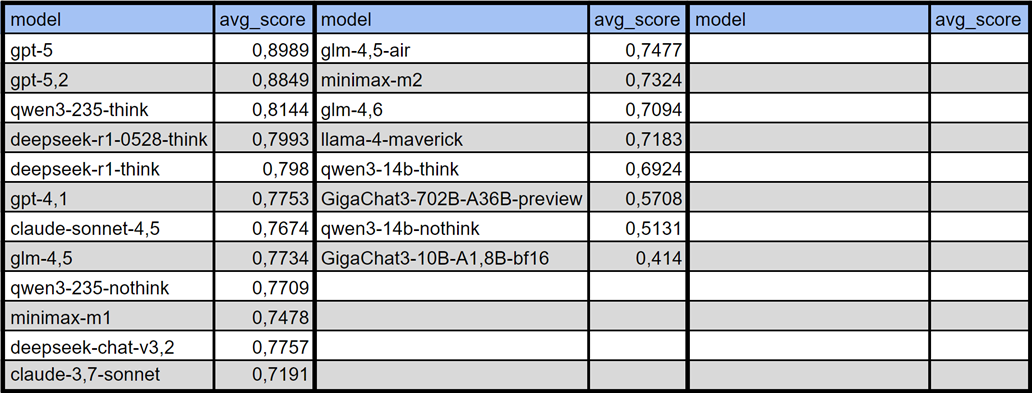

integrated_rank_exams_trading

Что выбивается из общей картины (важные наблюдения)

-

gpt‑5 — специализация на практических задачах

gpt‑5 демонстрирует нетипичный профиль: не лидирует на классических FinQA/TATQA (там впереди Qwen/GLM/gpt‑4.1), но уверенно доминирует на практико‑ориентированных экзаменах (CFA-like/CMT-like), русскоязычных задачах (VLigaBench-ru) и особенно на трейдинговых наборах (Trading_TA/Derivatives).

-

gpt‑5.2 — новый лидер универсальности

gpt‑5.2 показывает качественный скачок относительно предшественника (gpt-5), он занимает 1-е место в рейтинге по классическим бенчмаркам (public_benchs) и 2-е место в рейтингах по экзаменам (exams_like) и трейдингу. Модель демонстрирует сбалансированную производительность across доменов:

FinQA/ConvFinQA/TATQA: 0,7995/0,9220/0,9245 — топ-результаты на табличных данных

CFA-like Level 1/2/3: 0,8812/0,9079/0,8145 — лучшее понимание экзаменационной логики

Trading_TA/Derivatives: 0,8765/0,8934 — сильнейшие показатели на практических трейдинговых задачах

VLigaBench-ru: 0,8642 — высокая адаптация к русскоязычным финансовым кейсам

В отличие от gpt-5, который «выстрелил» именно на практике, gpt-5.2 одинаково силен и на традиционных QA, и на новых доменах — что делает его наиболее универсальным выбором для финансовых приложений.

-

Qwen‑модели: эффект режима с рассуждением

Qwen‑модели: эффект режима с рассуждением

Qwen‑модели сильно выигрывают от режима think:

Qwen3‑8B: скачок с ~0,57–0,76 до ~0,77–0,91 на базовых QA; заметное улучшение и на CFA-like 1/2

Но think не всегда помогает на MCQ (Multiple-Choice Question): у некоторых «фин‑специализированных» 7–8B (Fin‑o1/Fin‑r1) наблюдаются случаи снижения на CFA уровнях (анализ ответов показал, и увидели что причиной могли стать лишние шаги)

-

Языковой фактор

На VLigaBench‑ru большинство моделей выступают заметно хуже, чем на англоязычных экзаменах. Исключения — gpt‑5/5.2, qwen3‑235, DeepSeek‑R1, claude‑3.7 (think), которые удерживают высокий уровень на русском.

-

Llama‑4 — недооцененная сила в финансах

Несмотря на репутацию «провального» релиза по отзывам пользователей, модели семейства Llama‑4 показывают сильные результаты именно в финансах. Llama‑4‑Maverick‑17B‑128E‑Instruct и Llama‑4‑Scout‑17B‑16E уверенно держатся:

На классических QA:

ConvFinQA — 0,8508/0,8663

TATQA — 0,9101/0,9143 (топ‑уровень)

FinQA — 0,7498/0,8047

На практических экзаменах и трейдинге — конкурентно:

CFA-like Level 1 — 0,8326/0,7465

CMT-like Level 2 — 0,8327/0,7410

Trading_TA — 0,7676/0,7506

-

Отечественные модели: GigaChat в финансовых задачах

Семейство GigaChat демонстрирует интересную динамику результатов в зависимости от размера и специфики задач:

CFA-like Level 1/2/3: 0,6576 / 0,5870 / 0,6101 — средний уровень на базовых концепциях

VLigaBench-ru: 0,6019 — необычное поведение с пониманием русскоязычных финансовых задач, скорее всего из-за высокой степени понимания финансов в целом

GigaChat3-10B-A1.8B-bf16 (rank: public_benchs — 25, exams_like — 30, trading — 20):

Компактная модель с ограниченными возможностями на сложных доменах

FinQA/ConvFinQA/TATQA: 0,7280/0,7937/0,8747 — немного ниже среднего в соответствии с рангами среди протестированных нами моделей для базовых QA

CFA-like Level 1/2/3: 0,4920/0,3345/0,4151 — значительные сложности с экзаменационной логикой

Trading_TA/Derivatives: 0,5908/0,2371 — значительно уступает моделям сопоставимого размера на практических трейдинговых задачах

Модель больше подходит для простых запросов, чем для комплексного финансового анализа

GigaChat3-702B-A36B-preview (fp8) (rank: public_benchs — 19, exams_like — 22, trading — 18):

FinQA/ConvFinQA/TATQA: 0,7742/0,8448/0,9017 — сильные результаты на табличных данных

CFA-like Level 1/2/3 и Trading_TA/Derivatives — не растут пропорционально размеру от GigaChat3-10B-A1.8B-bf16 . Результаты средние даже среди моделей умеренной емкости

VLigaBench-ru: 0,5895 — неожиданно ниже, чем у GigaChat-2-Max

Открытые данные и воспроизводимость

Мы публикуем код и методологию замеров для воспроизводимости результатов:

GitHub репозиторий: https://github.com/FinamAILab/Finam-FinBench_public

Что доступно:

Полные метрики: все результаты по моделям и бенчмаркам — data/all_benchmarks_results.csv

Конфигурация запусков: параметры inference для всех протестированных моделей — config/api_config.yaml

Вопросы бенчмарков: открываем датасеты CFA-like, CMT-like, Trading_TA/Derivatives, VLigaBench-ru для самостоятельной оценки моделей

Код оценки: скрипты для запуска LLM-as-Judge и агрегации результатов

Что НЕ публикуем:

Ответы моделей

Датасет FinDER — защищен авторскими правами, см. оригинальную статью: Financial Dataset for Question Answering and Evaluating Retrieval-Augmented Generation

Приглашаем к сотрудничеству:

-

Нашли ошибку или несогласованность в методологии? Заводите issue на GitHub

-

Хотите предложить улучшение промптов или метрик оценки? Мы открыты к pull-request’ам

-

Протестировали свою модель и получили интересные результаты? Поделитесь!

Мы будем рады вашим комментариям и предложениям. Наша цель — создать открытый и объективный стандарт оценки LLM в финансах, который будет развиваться вместе с сообществом.

Спасибо за уделенное нам время!

Скоро вернемся с апдейтами уже по нашим собственным моделям — следите за обновлениями Лаборатории ИИ «Финама». 🚀

Автор: Finam_Broker