Представьте: вы технолог на нефтехимическом заводе. Вам нужно смоделировать работу новой установки — как сырьё будут нагревать, охлаждать и разделять на компоненты.

Поскольку вы сталкиваетесь с этим впервые, есть два пути: либо разбираться в теории по справочникам и собирать решение самостоятельно, либо найти готовый кейс с расчётами и результатами в открытых источниках.

Логичнее смотрится второй вариант. Но тогда возникает другая проблема. Вы открываете источники — и видите политику, слияния-поглощения, биржевые котировки, санкции. Узнать, кто кого купил или какая сегодня цена на нефть, можно за секунды.

А чтобы найти информацию о том, как снизить коксование в печах пиролиза, какие катализаторы сейчас тестируют мировые химические компании вроде BASF, или как сократить энергопотребление на установке полимеризации, приходится изучать десятки исследований и журналов. На это уходит много времени.

Поэтому я решил попробовать сделать агрегатор знаний на базе AI, хотя у меня нет ИТ-образования.

Дисклеймер: я сознательно упростил описание технических моментов, чтобы статья была понятна широкой аудитории.

Меня зовут Вадим Петрусенко, я старший бизнес-аналитик. Работаю в направлении технологического моделирования — мы создаем программный продукт для моделирования процессов нефтехимии.

По сути, это инженерный симулятор, в котором рассчитываются реальные технологические процессы: потоки, давления, температуры, составы, тепло- и массообмен, химические реакции. Этот продукт содержит много фундаментальных знаний: формулы, зависимости, алгоритмы расчета.

Мне и моим коллегам регулярно нужно быстро находить точную информацию: как смоделировать конкретный агрегат, какие коэффициенты взять и какие параметры задать. Например, чтобы корректно рассчитать ректификационную колонну или другой технологический аппарат.

Конечно, есть база — учебники и справочники. Они объясняют принципы и теорию, но обычно не дают готового решения под конкретную производственную задачу. Чтобы применить эти знания, мне нужно прочитать несколько источников, отфильтровать лишнее и самому собрать решение — на это уходят недели. При этом похожие задачи уже могли быть решены на других производствах. Поэтому я, как и другие инженеры, часто ищу кейсы в отраслевых журналах, на профильных сайтах, исследованиях и в профессиональных сообществах.

Но тогда возникают новые проблемы. Во-первых, информация размазана по всему интернету. Собрать её воедино — это реальная боль, на которую тоже уходит много времени. Во-вторых, как я уже писал — в инженерных источниках много новостного шума.

В чем идея?

Я хотел создать систему из двух уровней:

-

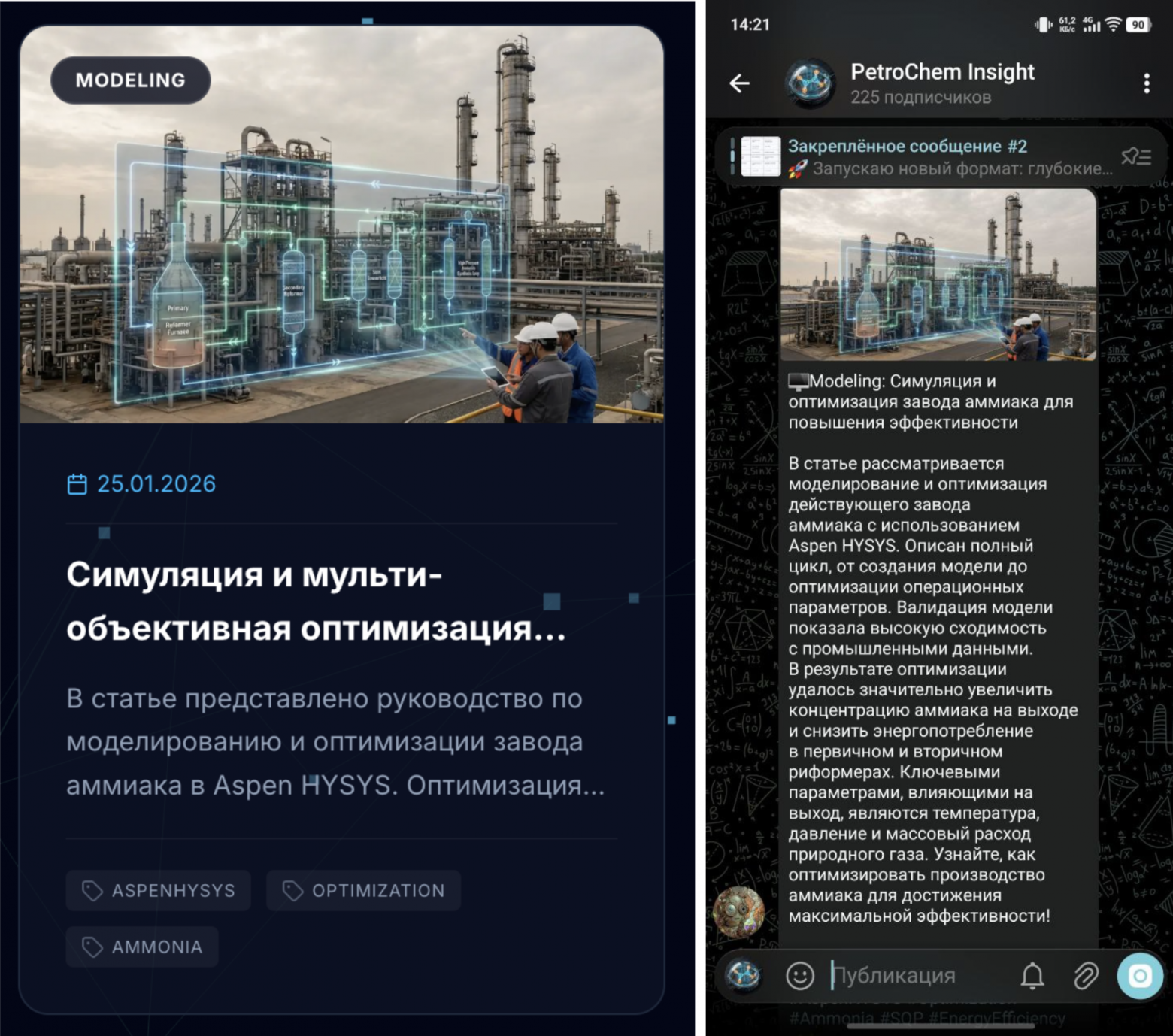

Уровень 1 — Telegram-канал для ежедневного информирования. Короткие новости о запусках пилотных установок, новых технологиях, обзорах оборудования, кейсах по моделированию. 100% релевантность, ноль политики.

-

Уровень 2 — платформа для глубокой аналитики и накопления знаний. Здесь я хотел реализовать концепцию “Графа Знаний” и “Трекинга Жизненного Цикла Технологии” — от научной публикации до патента и коммерческого внедрения.

Например: меня заинтересовала новая технология пиролиза, которая появилась в патентах. Я нажимаю кнопку “отслеживать”, и алгоритм начинает искать взаимосвязанные исследования, эксперименты, пилотные установки, статьи. Затем платформа присылает уведомление, если публикуется новая информация.

Так можно отслеживать жизненный цикл развития технологии и получать информацию мгновенно, причем адаптированную под роль специалиста:

-

для R&D — академические исследования и инновации;

-

для инженера-технолога — лучшие практики эксплуатации;

-

для руководителей — тренды и направления развития.

Главная ценность — не просто агрегация, а дистилляция знаний: превращение информационного шума в базу знаний с умным поиском.

ИИ-агрегатор правильных новостей

Сразу скажу — мой опыт в программировании ограничивается базовым курсом Python. Поэтому я генерировал программу с помощью языковых моделей — просто писал промпты в ChatGPT.

Но когда приложение растёт, появляется много сервисов, оно становится довольно тяжёлым — начинаются проблемы. Вы копируете код туда-сюда, возникает ошибка, вы вставляете её в чат, получаете исправление, снова вставляете. Это слишком сложно и долго.

Решением стал переход на Cursor — редактор кода со встроенным AI. Это не просто автодополнение, это полноценный AI-ассистент, который видит весь ваш проект, понимает зависимости между модулями и генерирует код с учетом контекста.

Что дает Cursor:

-

код создается сразу в нужном месте, не нужно копировать из ChatGPT;

-

AI понимает архитектуру проекта и предлагает решения с учетом используемых библиотек;

-

можно выбрать любую модель — Claude, GPT-4, Gemini;

-

скорость разработки увеличилась в 3-4 раза;

-

весь код можно сразу документировать и описывать все особенности и решения.

Если вам не подойдет Cursor, есть альтернативы: Claude Code, Copilot Agent, расширения для VS Code.

Конечно, самая большая сложность для человека без IT-образования — это инфраструктурная часть. Развернуть сервер, настроить его, разместить автоматизацию, чтобы всё работало, подключить API нейросетей. Я полностью полагался на AI, чтобы это сделать. Cursor здесь сильно помог — он видел весь проект и подсказывал правильные решения для настройки.

Архитектура: как работает система

Я спроектировал полный цикл обработки информации, который работает почти автономно. Разберу каждый этап.

Этап 1: Автоматический поиск и анализ источников

Вместо традиционного web scraping я использую Gemini Deep Research Agent.

Как это работает:

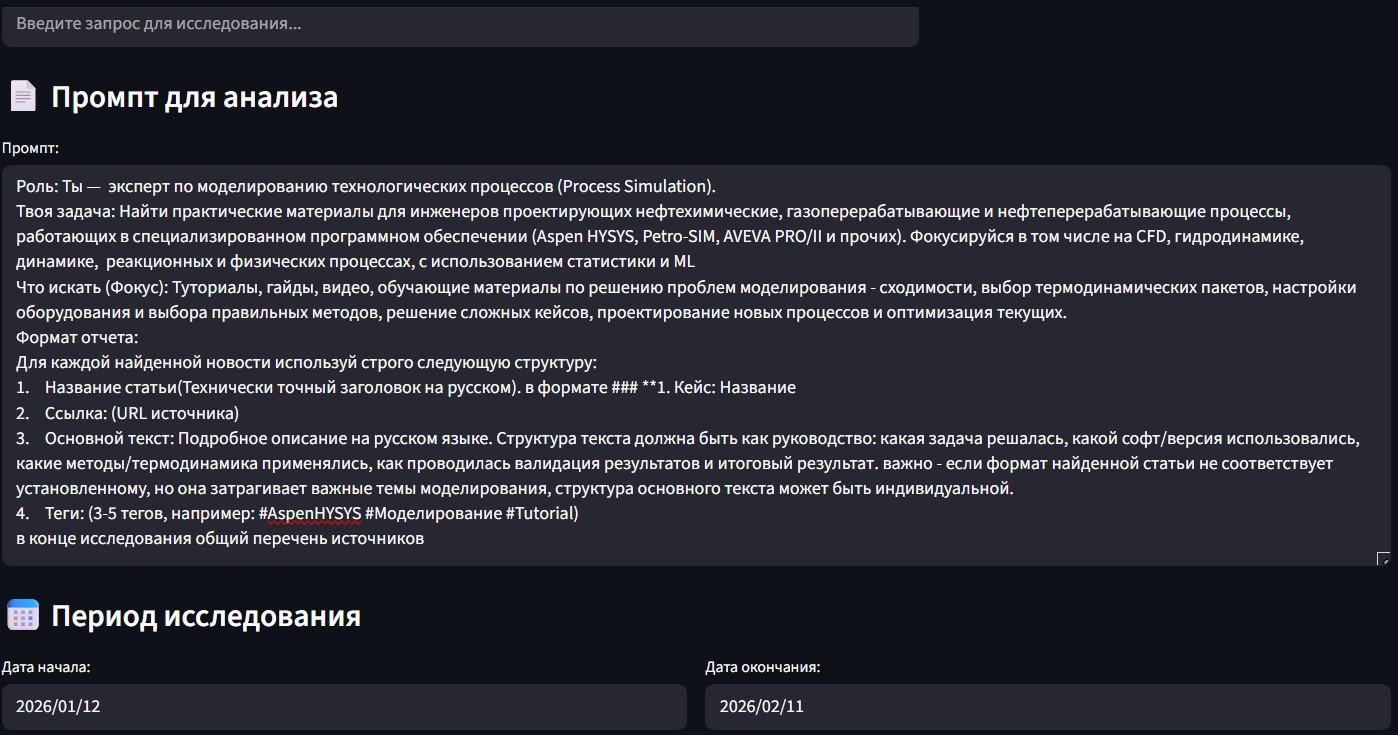

Я пишу промпт для анализа и указываю период.

Модель самостоятельно:

-

ищет релевантные источники в интернете;

-

анализирует контент;

-

формирует структурированный отчёт с цитированием источников.

Здесь работает семантическая фильтрация. AI понимает контекст. Например, статья про “катализатор изменений в компании” — это не про химию, и модель её отбрасывает. А вот статья про “новый катализатор для крекинга” — это то, что нужно.

Я не указываю конкретные источники. Зачастую модель берет период, который я укажу, и смотрит все источники в сети — журналы про моделирование, про нефтехимию, брошюры. Из всего интернета.

В основном контент — из азиатских источниках. Статьи из Китая про нефтехимию вполне интересные и доступные. Из США и Великобритании материалов меньше — большинство профильных источников там платные.

Обычно в одном исследовании получается 9-10 статей. Время выполнения поискового запроса после разовой настройки промпта — 15-25 минут. После этого отчёт сохраняется.

Этап 2: Парсинг и структурирование

После того как Deep Research сформировал отчёт, нужно превратить его в структурированные данные.

Модуль parser автоматически:

-

разделяет отчёт на отдельные статьи (это разные несвязанные события — одна про моделирование пиролиза, другая про цифровизацию установки);

-

извлекает метаданные: тема, заголовок, источник, теги;

-

находит первоисточники;

-

создаёт parsed.json со структурированными данными.

Это ключевой шаг: без него дальше работать невозможно. Каждая статья должна получить свой уникальный идентификатор, метаданные и ссылку на источник.

Этап 3: Генерация визуального контента

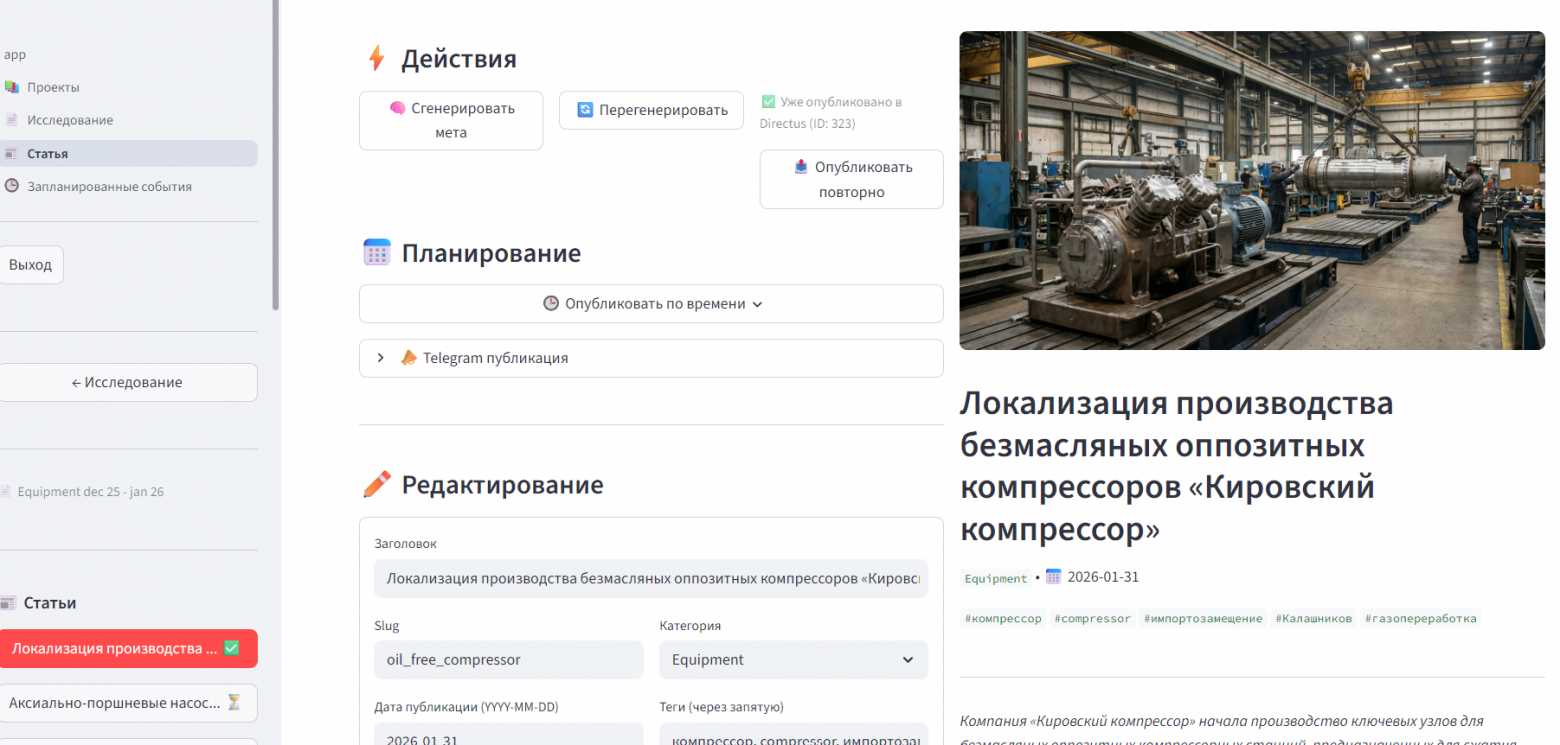

Я понимаю, что новостной шум и сложность найти кейсы — это не только моя боль, но и боль коллег. Поэтому я решил упростить восприятие информации и добавить иллюстрацию к каждой статье.

Использовать стоковые фото или копировать картинки из статей я не хочу, так как это вопрос авторских прав.

Поэтому теперь ImagePipeline через Gemini Image API создаёт уникальные иллюстрации для каждой статьи. Вот как это работает:

Промпты генерируются автоматически на основе содержания: тема + заголовок + краткое описание. Например, для статьи про новую технологию пиролиза промпт будет примерно таким:

Создай иллюстрацию для статьи о технологии пиролиза на основе представленного контента.

Gemini pro в режиме рассуждения сама описывает промпт

Результат — профессиональные изображения в едином стиле, которые визуально связывают весь канал.

Этап 4: Обогащение метаданных

На этом этапе каждая статья получает финальную обработку.

EnrichPipeline использует большую языковую модель для:

-

категоризации (Technology, Safety, Market, Equipment, Research…);

-

формирования анонсов — короткое описание статьи в 2-3 предложениях;

-

генерации форматированного Markdown-контента с правильной структурой заголовков;

-

генерации готовых текстов для Telegram с emoji и хештегами.

Например, для одной и той же статьи система генерирует:

-

Полный текст для сайта (развёрнутое описание);

-

Короткий пост для Telegram (150-200 символов);

-

Анонс с ключевыми тезисами;

-

Категории и теги для поиска.

Это позволяет мне публиковать контент на разных платформах без ручной адаптации.

Этап 5: Публикация

Последний этап — вывод контента пользователям.

Что умеет система:

-

публиковать статьи в Telegram с отложенным постингом;

-

загружать в CMS (Directus) через API;

-

экспортировать в любой формат (JSON, CSV, Markdown).

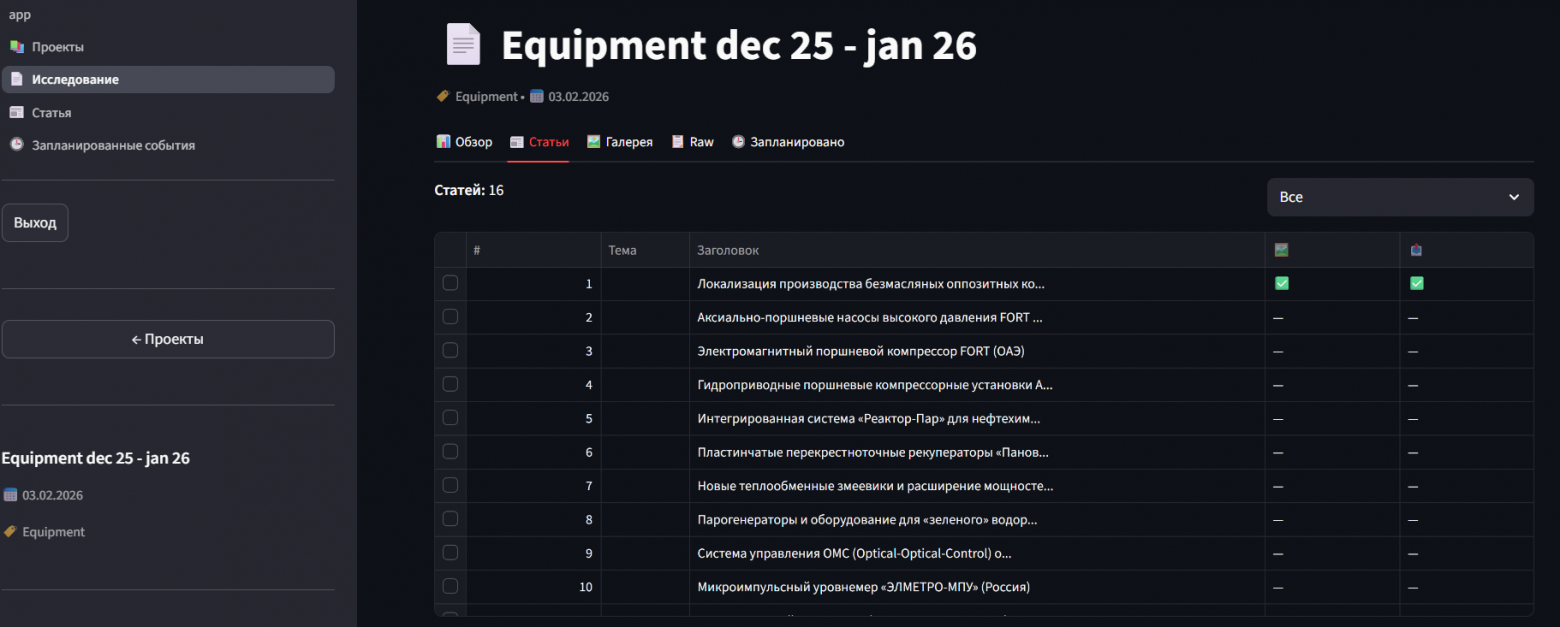

Я сделал для себя интерфейс-“читалку” в Streamlit, где могу посмотреть все сгенерированные статьи, скорректировать текст или изображение, удалить нерелевантные материалы, одобрить публикацию.

Пока есть частично ручная работа — я её не автоматизировал полностью, потому что периодически выявляю ошибки и пытаюсь их исправлять.

Итого: от отчёта до готовой публикации уходит около 5 минут человеческого времени (проверка результата). Остальное — автоматика.

Технический стек: что под капотом

Для тех, кто интересуется деталями реализации.

Backend:

-

Streamlit — веб-интерфейс для управления проектами и статьями;

-

Google Gemini API — Deep Research Agent, Image Generation, Content Enrichment;

-

SQLite — хранение метаданных исследований;

-

Filesystem — хранение полнотекстовых отчётов и изображений.

AI-компоненты:

-

AIClient — интеграция с Gemini Interactions API, стриминг результатов с автопереподключением;

-

ImageClient — генерация иллюстраций через Gemini Image API;

-

EnrichClient — генерация метаданных и структурированного контента.

Стоимость:

-

Gemini: 20 долларов в месяц;

-

Cursor: 20 долларов в месяц;

-

Google Cloud API: я получил бесплатные стартовые 300 долларов от Google. Через 2 месяца будет точно понятно, сколько нужно будет заплатить.

Сейчас в месяц выходит 40 долларов.

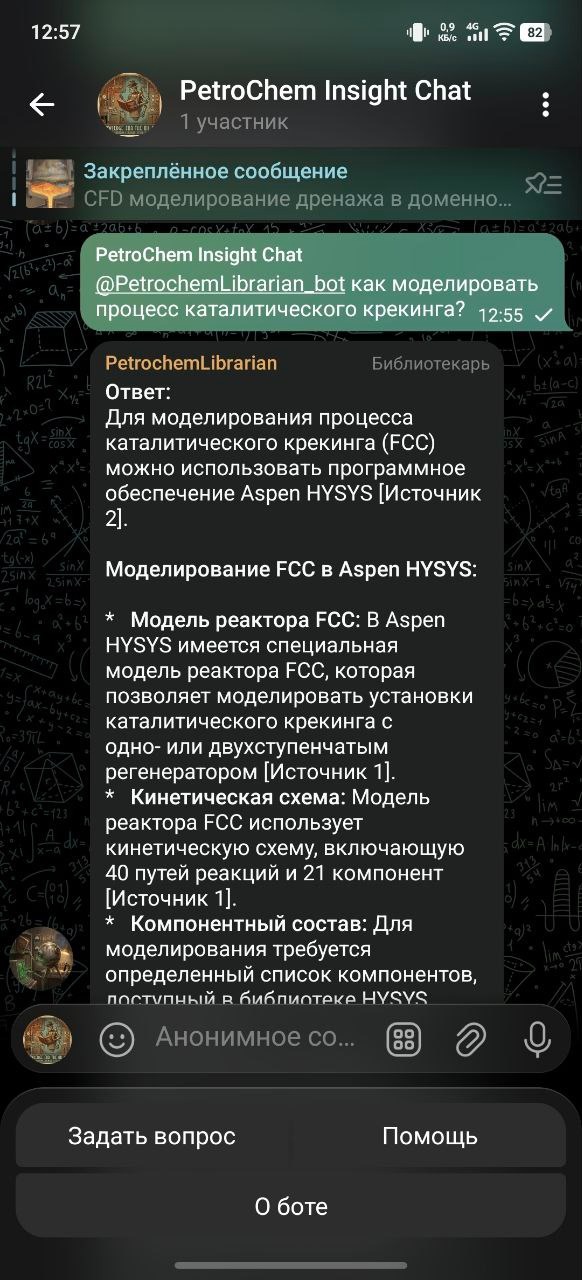

Бот-библиотекарь: поиск по базе знаний

Telegram-канал и платформа — это хорошо, но я решил пойти дальше. Мне нужен был инструмент, который не просто публикует новости, а помогает найти ответ на конкретный вопрос из всей накопленной базы знаний.

Сейчас я разрабатываю бота-библиотекаря в Telegram. Это промежуточный этап — в дальнейшем планируется отдельная платформа для глубокой аналитики.

Бот работает на технологии RAG (Retrieval-Augmented Generation). Это устроено примерно так: берётся книга и разделяется на кусочки. Каждый кусочек переводится в вектор — это набор из 600-800 цифр, который описывает смысл текста. Когда вы пишете запрос, он тоже переводится в вектор, и система пытается найти что-то похожее в своей базе. Если находит, она берёт эти участки (обычно 3-5 кусочков) и даёт их нейросети. Нейросеть смотрит на них и пытается ответить на ваш вопрос.

Если этой информации нет в базе, нейросеть не получает кусочки и отвечает:

“Извини, не нашла такой информации”

Например, я спрашиваю:

“Как моделировать процесс каталитического крекинга?”

Бот:

-

Обращается к статьям, которые мы нашли и опубликовали, и смотрит, нет ли там кейсов с такой темой.

-

Обращается к библиотеке (там лежат книги по нефтехимии, журналы, полезные гайды).

-

Даёт ответ — либо предоставляет информацию, либо отвечает: “Такой информации нет в базе знаний”.

Сейчас я дорабатываю логику ответов, подбираю оптимальные настройки и перевожу решение в формат Telegram Mini App для более удобного взаимодействия. На данный момент функционал находится в разработке и остальным пользователям ещё недоступен.

Результаты

На планирование и прототипирование у меня ушел месяц. На активную разработку — 10 дней. Сейчас система:

-

собирает новости по заданной тематике за любой период;

-

фильтрует шум — отсекает политику, финансы, PR;

-

генерирует уникальные изображения для каждой статьи;

-

форматирует контент под разные платформы (Telegram, Web, CMS);

-

хранит всю историю исследований с возможностью поиска и повторного использования;

-

работает на реальном канале — публикует новости о моделировании в нефтехимии;

-

отвечает на вопросы пользователей через бота-библиотекаря.

Мы с коллегами-инженерами общаемся в Telegram-канале, где обсуждаем разные вопросы моделирования: как правильно построить модель, какие настройки применить, как решить нестандартную задачу. Мой новостной Telegram-канал стал дополнением к нему. Можете тоже его почитать. Буду рад, если и для вас канал окажется полезный.

Платформа PetroChem AI Analyst пока выполняет роль базы знаний, куда сохраняются все найденные статьи на виртуальном сервере. Сайт сделан тоже с помощью AI. Идея в том, чтобы эти знания были подготовлены и адаптированы под потребности разных специалистов.

Конечно, я уже столкнулся с вопросом, который часто описывают на Хабре: что будет, когда пользователей станет больше, когда информации будет больше. Это пока открытый вопрос. Я прекрасно понимаю, что без IT-специалистов эта история не решается. Да, можно выкатить MVP за 5 дней вместо 100. Но в серьёзную разработку надо заходить со специалистами, которые смогут адекватно оценить решения, перепроверить, посмотреть на безопасность, где-то скорректировать, технологии подобрать правильные.

Куда ещё можно применить

Я хочу превратить прототип в инструмент, который будет реально помогать инженерам каждый день. Думаю, это решение можно расширять для:

-

анализа поставщиков оборудования и реагентов в дружественных странах и подбора аналогов;

-

сбора актуальных патентов для R&D-направления;

-

анализа событий, которые могут повлиять на продажи — санкции, логистические проблемы, ограничения, информация от потребителей полимеров;

-

сбора лучших практик от разных отраслей для оптимизации бизнес-процессов;

-

проведения HAZOP (анализа опасностей и работоспособности) на основе сформированной базы расследований — AI поможет генерировать сценарии “что/если”, а затем формировать мероприятия совместно с сотрудниками;

-

помощи в моделировании процессов — подсказывать параметры, коэффициенты, настройки на основе накопленной базы знаний.

Так что с коллегами-айтишниками будем пересматривать архитектуру. Если у вас есть идеи или советы — поделитесь в комментариях, буду рад.

А ещё подписывайтесь на тг-канал СИБУР Цифровой. Он полезен айтишникам, которые хотят понять, что реально происходит в промышленном ИТ.

Там мы рассказываем о цифровых технологиях для производства — от IIoT и аналитики до инженерных инструментов и ИИ. Делимся кейсами, экспериментами, новостями и выкладываем вакансии.

Автор: Petrusenkovs