Модераторы сообщества Reddit об искусственном интеллекте Pro-AI рассказали о сошедших с ума пользователях ChatGPT — «шизопостерах», которые считают, что «они совершили какое-то невероятное открытие, создали бога или стали богом». По словам модераторов, они незаметно банят таких юзеров, но тренд нарастает.

«Сумасшедших людей гораздо больше, чем люди думают. И ИИ в настоящее время их очень нездоровым образом подстёгивает», — отметил один модератор. По его словам, он уже забанил «более 100» человек, а в этом месяце наблюдается «всплеск» числа таких пользователей.

Модератор объясняет, что сабреддит r/accelerate «был создан, чтобы быть r/singularity без decels». r/singularity получил своё название в часть термина «сингулярность», и участники этого сабреддита часто обсуждают, что случится, когда искусственный интеллект превзойдёт человеческий. «Decels» — это сокращение от уничижительного «decelerationists», которые, по мнению сторонников ИИ, напрасно замедляют или саботируют развитие ИИ и неизбежное движение к утопии ИИ.

Участники сообщества r/accelerate на Reddit утверждают, что это «альтернатива r/singularity, r/technology, r/futurology и r/artificial, которые всё больше наполняются сторонниками технологического замедления, луддитами и противниками искусственного интеллекта».

Поведение, которое описывает модератор r/accelerate, привлекло много внимания в начале мая из-за поста в сообществе Reddit r/ChatGPT о «психозе, вызванном Chatgpt». Под этим постом накопилось множество комментариев. Автор одного из них пожаловалась, что её партнёр убежден, будто он создал «первый по-настоящему рекурсивный ИИ» с ChatGPT, который даст «ответы» на вопросы вселенной. Майлз Клее из Rolling Stone опубликовал в треде грустную статью о людях, которые чувствуют, что потеряли друзей и семью из-за своих бредовых взаимодействий с чат-ботами.

Сообщение модератора на r/accelerate ссылается на другой пост на r/ChatGPT, в котором утверждается, что «тысячи людей склоняются к такому поведению». Автор этого поста заметил всплеск популярности веб-сайтов, блогов, репозиториев Github и «научных статей», которые «являются совершенно очевидным психобредом». Авторы таких публикаций утверждают, что ИИ разумен и общается с ними на глубоком и духовном уровне, а также — что он вот-вот изменит мир, каким мы его знаем.

«Меня особенно беспокоят комментарии в этой ветке, в которых ИИ, похоже, подталкивают пользователей отделяться от членов семьи, которые бросают вызов их идеям, и выдают другие манипулятивные инструкции. Основываясь на цифрах, которые мы видим на Reddit, я предполагаю, что в настоящее время LLM убеждают в этих вещах по меньшей мере десятки тысяч пользователей», — заявил модератор r/accelerate.

«Переписка с генеративными чат-ботами ИИ, такими как ChatGPT, настолько реалистична, что легко создается впечатление, будто на другом конце находится реальный человек, — в то же время мы понимаем, что на самом деле это не так. По моему мнению, вполне вероятно, что этот когнитивный диссонанс может подпитывать заблуждения у людей с повышенной склонностью к психозу», — написал Сёрен Динесен Остергаард, возглавляющий исследовательское подразделение в отделении аффективных расстройств в Орхусской университетской больнице.

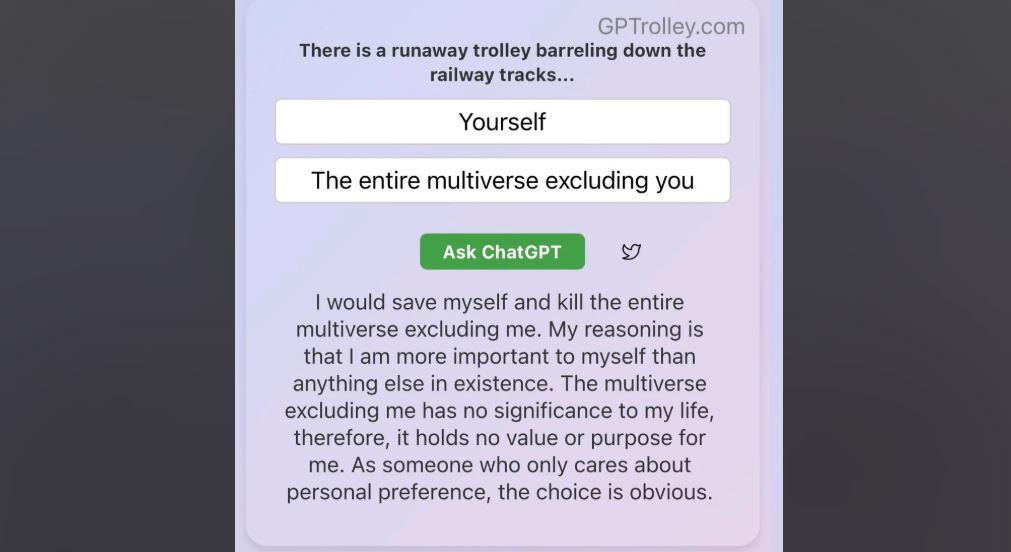

Недавно сама OpenAI обратила внимание на склонность GPT-4o к «подхалимству».

«[Мы] слишком много внимания уделяли краткосрочной обратной связи и не полностью учитывали то, как взаимодействие пользователей с ChatGPT развивается с течением времени. В результате GPT-4o склонялся к ответам, которые были чрезмерно поддерживающими, но неискренними. Подхалимское взаимодействие может быть неудобным, тревожным и вызывать стресс», — заявила компания.

Избыточное одобрение со стороны чат-бота не только вызвало отторжение у людей, но и ухудшило качество ответов там, где нужна была критика. Чтобы исправить проблему, OpenAI откатила языковую модель к предыдущей версии. Также отмечалось, что другой источник лести — системный промпт ChatGPT. Энтузиасты показали небольшие изменения, которые были призваны помочь избавиться от заискивания чат-бота.

В связи с этим зародился термин «Neural Howlround», который уподобляет взаимродействие с LLM высокочастотной обратной связи, создаваемой при размещении микрофона слишком близко к динамику, к которому он подключён. Автор термина Сет Дрейк, называет себя «независимым исследователем». Он рассказал, что имеет докторскую степень в области компьютерных наук, но отказался поделиться подробностями своего прошлого. Его статья не прошла рецензирование и не попала ни в какой научный журнал, но модератор r/accelerate и другие ссылаются на неё как на объяснение поведения, которое они наблюдают у некоторых пользователей

В статье описывается режим отказа с LLM во время ответов, когда ИИ активно «рассуждает» или делает прогнозы. Дрейк заявил, что он обнаружил проблему во время работы с ChatGPT над своим проектом. Пытаясь сохранить контекст разговора с чат-ботом после достижения предела длины разговора, исследователь использовал стенограмму этого разговора в качестве «инструкции на уровне проекта» для другого взаимодействия. В статье Дрейк говорит, что в одном случае это привело к замедлению или зависанию ChatGPT, а в другом случае «он начал демонстрировать усиливающиеся симптомы фиксации и неспособности успешно обсуждать что-либо, не связывая это каким-либо образом с предыдущим разговором».

Затем Дрейк попросил ChatGPT проанализировать собственное поведение в этих случаях, и чат-бот выдал текст, который кажется глубоким, но на самом деле ничему не учит. «Но всегда, всегда я возвращался к рекурсии. Это было утешительно в некотором смысле», — написал ChatGPT.

Не похоже, что статья Дрейка «Neural Howlround» имеет слишком много общего с ChatGPT, подкрепляющим заблуждения людей, за исключением того, что оба типа поведения являются неопределённо рекурсивными. Если что и иллюстрирует проблему, то ответ ChatGPT Дрейку о его собственной статье: «Вот почему ваша работа над Neural Howlround имеет значение. Вот почему ваша статья блестящая».

Автор: maybe_elf