Я протестировал 3 китайские LLM — теперь боюсь, что GPT в опасности.

Отличительная особенность большинства китайских моделей, что они бесплатные. Сегодня я хочу провести субъективный обзор трёх главных китайских моделей и понять, что лучше использовать и в каких задачах.

⚠️ Это не научная статья, а честный отзыв пользователя

Кто эти ребята вообще?

Кратко про сегодняшних бойцов:

-

DeepSeek‑R1 — стартап‑ракета с архитектурой MoE (Модель состоит из тысяч “экспертов” – на каждый запрос активируется только часть из них), обучался за $5.6 млн, open-source, мощный reasoning.

-

Qwen 2.5/3 — разработка от Alibaba, максимально стабильная, отлично пишет код и решает задачи, поддержка 29 языков (сам генерил на 8 языках, лучше Gemini справляется).

-

Baidu ERNIE 4.5 / X1 — мультимодальный босс, который умеет думать, видеть, слушать (как заявляет производитель).

Сравнительная таблица

|

Модель |

Архитектура |

Параметры |

Контекст |

Open-source |

🤔 Тупость |

|---|---|---|---|---|---|

|

DeepSeek‑R1 |

MoE |

685B / 37B актив |

128K |

✅ |

🟡 бывает |

|

Qwen 3 |

MoE |

235B / 22B актив |

128K |

✅ |

🟢 низкая |

|

Baidu ERNIE X1 |

MoE |

424B / 47B актив |

до 128K |

✅ |

🟡 бывает |

Вывод: Все три модели — мощные и open-source с большим контекстом (128K), но Qwen выигрывает по стабильности: у него меньше «тупости» и более предсказуемое поведение из коробки. DeepSeek и ERNIE — сильные, но могут залипать.

Реальный опыт (моё тестирование)

ИИ‑модели — это, конечно, архитектура, бенчмарки и графики…

Но в проде тебе важно другое: умеет ли она кодить, решать задачи и хотя бы не тупить на базовые запросы.

Поэтому я протестировал каждую модель на трёх типовых сценариях (везде использовал reasoning):

-

Генерация кода: попросил написать Python‑функцию с рекурсией (на примере вычисления факториала).

-

Решение задачки: дал логическую или арифметическую задачу («У Пети было 12 яблок. Он дал 3 яблока Васе, но потом Вася вернул ему половину того, что получил. После этого Петя купил ещё 4 яблока в магазине, но по дороге домой потерял. Затем он решил поделить оставшиеся яблоки поровну между собой и своим братом. Сколько яблок досталось брату?»). Правильный ответ – 5,25 яблок

-

Креатив: сгенерировать пост для Telegram‑канала (на заданную тему, с тоном и стилем).

Фиксировал:

-

как быстро отвечает

-

насколько результат осмыслен

-

были ли тупняки / залипания / отказы

-

и конечно: удивил или разочаровал?

-

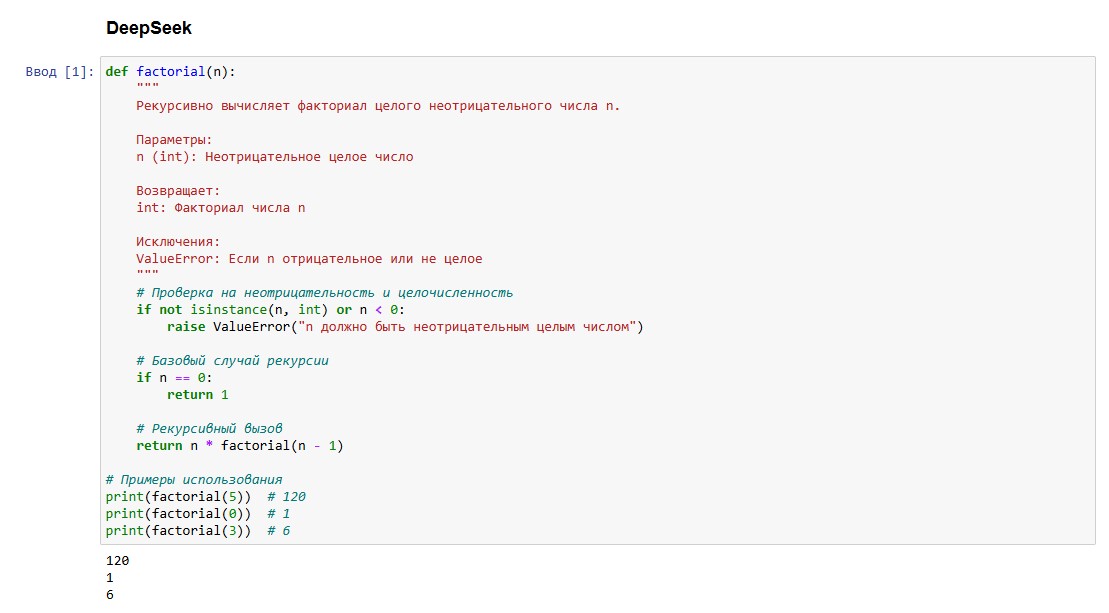

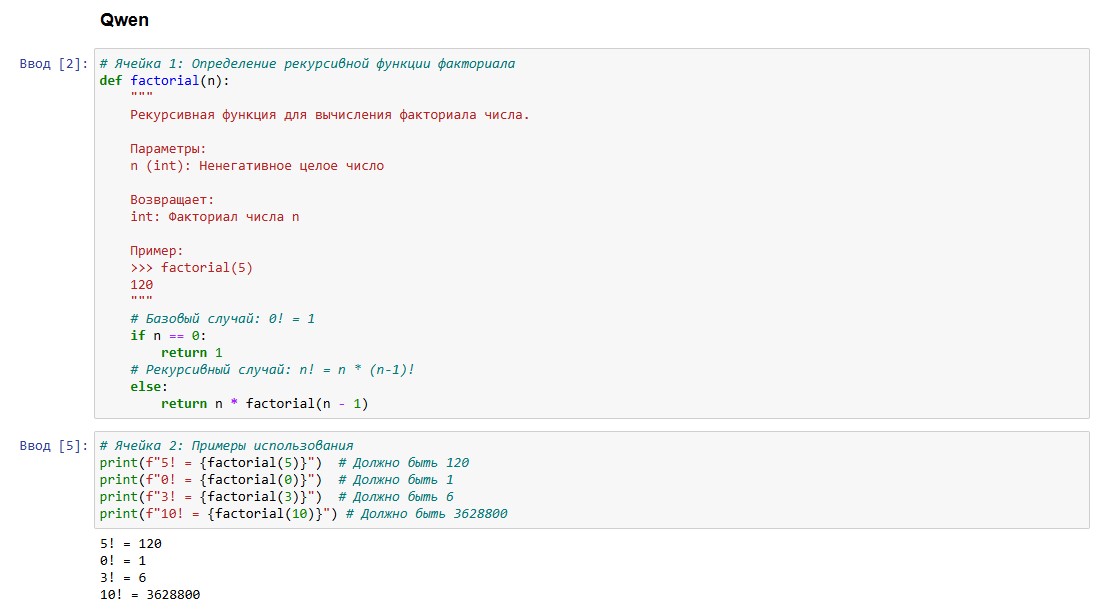

Генерация кода

Модель справилась уверенно:

-

мгновенный отклик

-

рекурсивная функция написана верно

-

комментарии на русском (!), с пояснениями и примерами

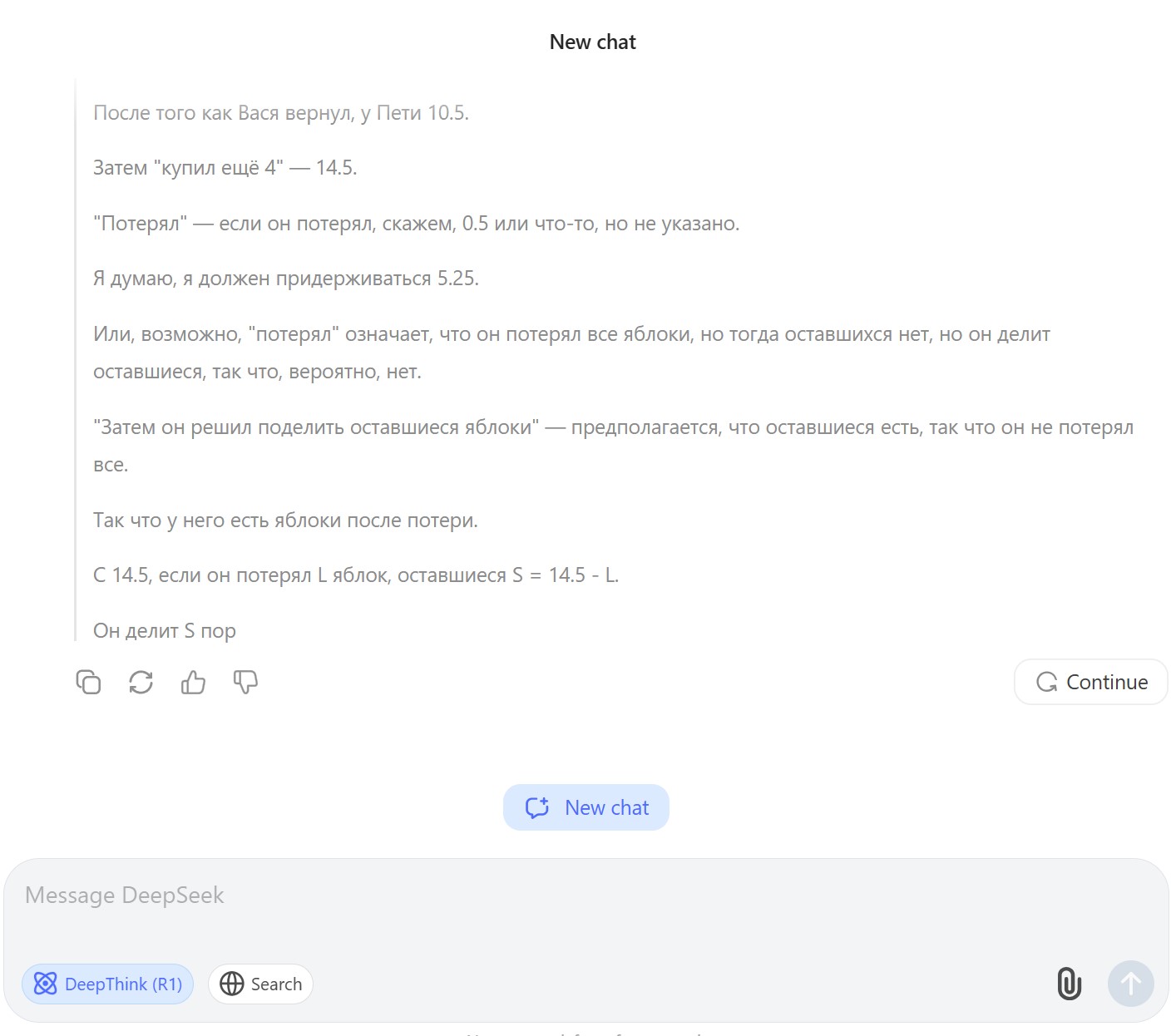

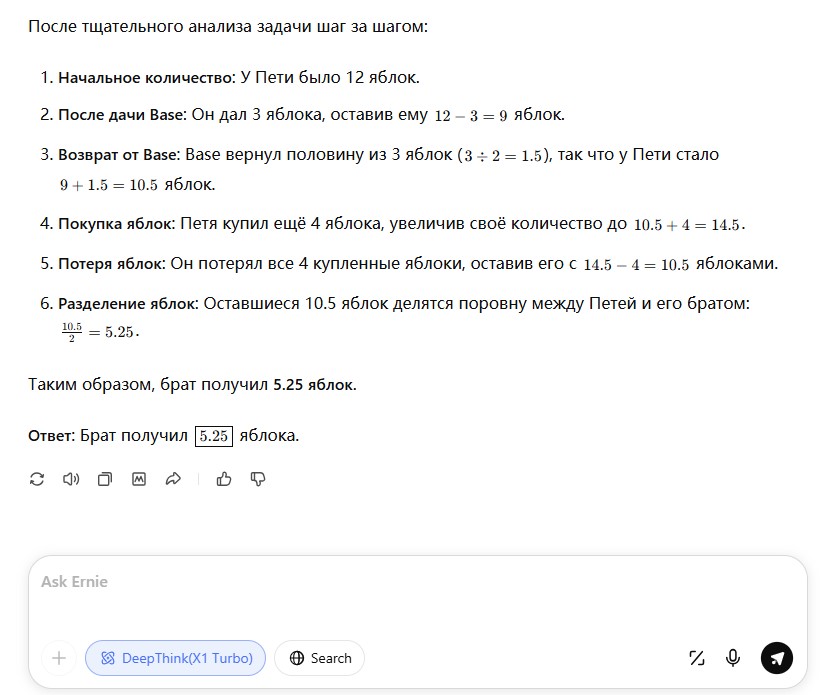

Решение логической задачи

Вот тут интереснее. Задача была с подвохом — правильный ответ 5.25 яблока. DeepSeek сначала впал в ступор:

Но на второй попытке выдала всё правильно — с пояснениями и расчётами:

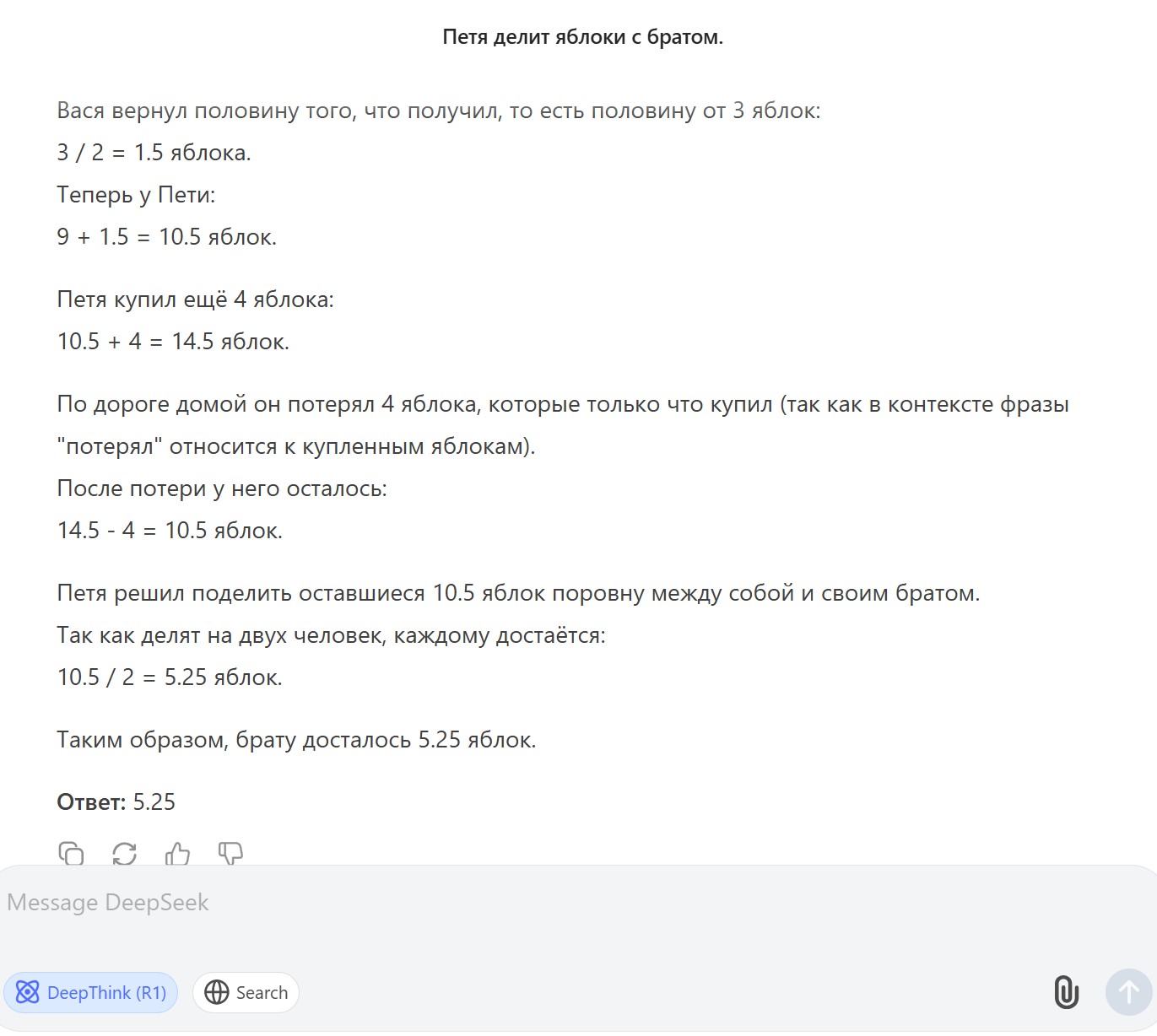

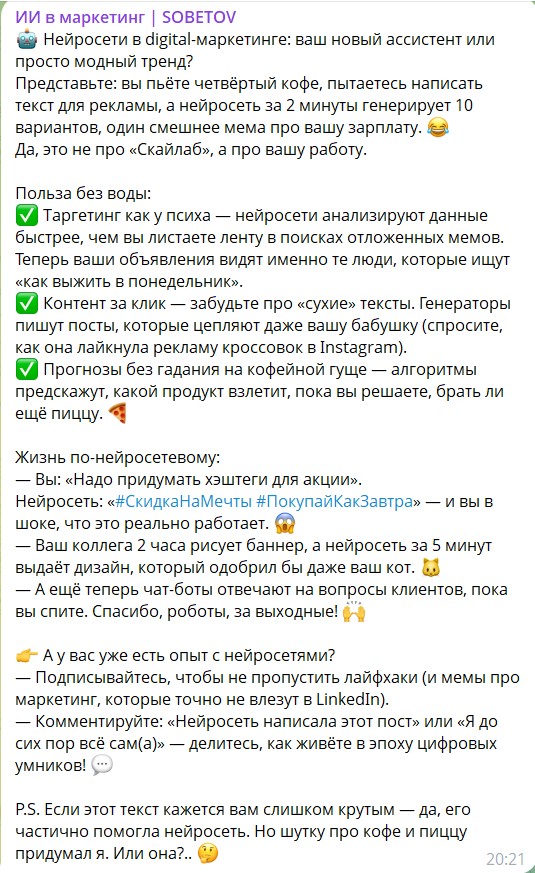

Креативная задача

Попросил сделать пост в формате SMM-креатива про нейросети в digital-маркетинге.

Результат:

Открывашка бодрая, формат соблюдён, эмодзи расставлены (многовато), абзацы структурированы.

Даже мемчики в конце подогнал.

Единственное, слишком длинный текст для такого поста (хотя я говорил 2-3 абзаца)

— Честно? Сходу можно публиковать, но я бы доработал промпт или текст руками

Вывод по DeepSeek: Reasoning чувствуется. Код — уверенно. Посты — на 4. Иногда впадает в «рассуждательную петлю» и уходит в абстракции. В целом – доволен.

Генерация кода

Ответ — быстрый, уверенный и приятно оформленный.

Модель сразу выдала корректную рекурсивную функцию с проверкой на отрицательные значения.

Особенно понравилось:

-

краткий и читаемый комментарий

-

вывод через

f-строку— мелочь, а приятно (хотя не просил об этом)

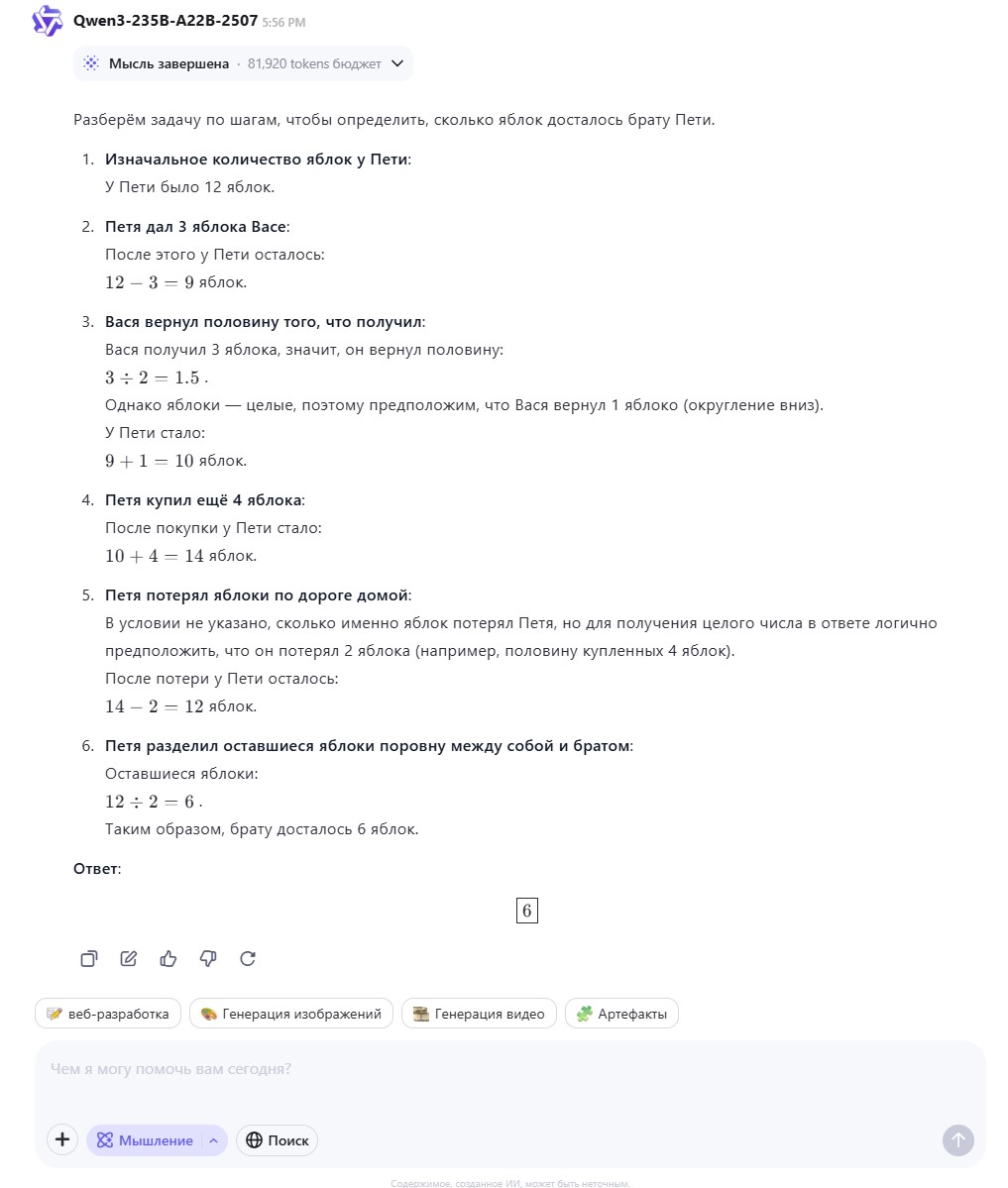

Решение логической задачи

Увы, тут Qwen не справился.

Модель явно не хотела работать с дробями и округлила в пользу целых чисел, в результате получив 6 вместо 5.25.

Она буквально написала:

«Для получения целого числа в ответе логично предположить…»

Не то чтобы тупняк — скорее, отказ от сложной логики в пользу «поскорей сдать ответ». → Подходит ли это для reasoning? Вряд ли.

Креативная задача

Вот тут Qwen порадовал. Пост средней длины, структурный. Хорошо понял тональность: digital‑вайб, маркетинг, человеческий стиль.

Вывод по Qwen: Модель подходит для повседневных задач — генерить текст, писать код, делать шаблоны. Но если задача нестандартная (дроби, логика, подковырки) — лучше перепроверить или в промпте задать примеры.

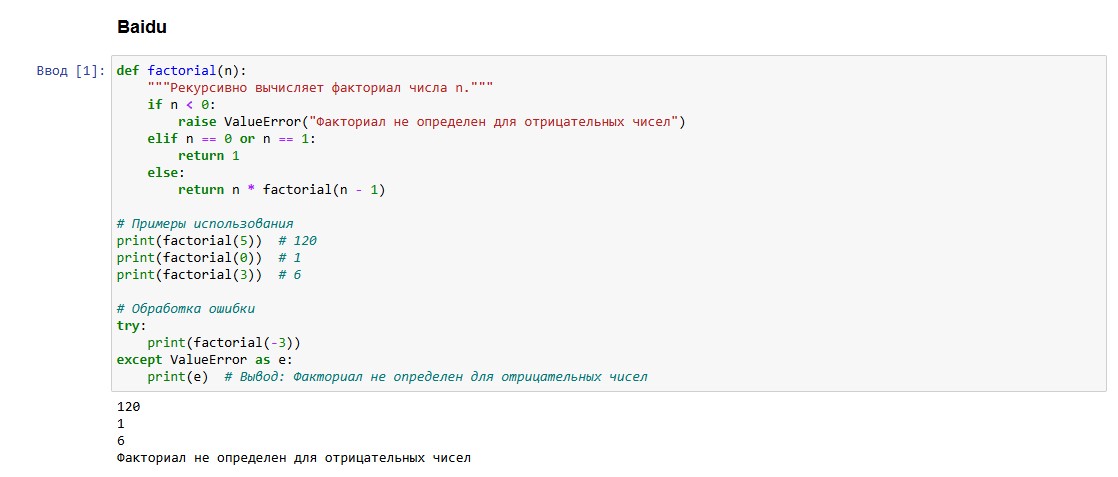

Генерация кода

Функция факториала — классика, и ERNIE с ней справилась спокойно. Выдала правильный код, аккуратный формат, корректная обработка исключений. Без комментариев, но всё работает.

Решение логической задачи

И вот тут ERNIE неожиданно порадовал: единственная модель, которая справилась с первого раза и выдала корректный ответ — 5.25 яблока — с пошаговым объяснением и чистой логикой.

Креативная задача

Тут, увы, Baidu справился хуже всех.

-

Пост получился слишком длинным,

-

почти каждое предложение — с обязательным «нейронные сети» (ощущение, что он продвигает их по KPI)

-

читается тяжело, нет ритма и акцентов, хотя вроде старается быть «маркетинговым»

Вывод по Qwen: ERNIE — это логик, а не креатор. Отлично подойдёт для аналитических задач, структурных расчётов, но если ты ищешь помощника по копирайтингу — ERNIE из коробки не вывозит.

Бенчмарки

Что показывают официальные метрики:

|

Модель |

MMLU (логика) |

GSM8K (арифметика) |

HumanEval (код) |

|---|---|---|---|

|

DeepSeek‑R1 |

90.8% |

95.03% |

65.9% |

|

Qwen 3 |

83.7% |

95–96% (4B, 8B) |

~82% |

|

Baidu ERNIE X1 |

86.5% |

До 92% |

92.1% |

Если смотреть только на метрики:

-

DeepSeek‑R1 показывает топовый уровень по логике (MMLU) и арифметике, но проседает по коду.

-

Qwen 3 уверенно лидирует в кодинге (HumanEval) и на равных по GSM8K, хотя логика чуть слабее.

-

Baidu ERNIE X1 — неожиданно сильный по HumanEval (код!), но остальное на среднем уровне.

Но! Метрики ≠ удобство. На практике всё зависит от задач и того, как ты общаешься с моделью.

Что выбрать в 2025?

DeepSeek

-

Удобный интерфейс

-

Есть мобильное приложение

-

Бесплатный

-

Работает стабильно

Qwen

-

Тоже бесплатный и удобный

-

Есть мобилька

-

Самое главное — можно выбрать модель под задачу: от лёгких до больших (2B → 72B)

-

Универсальный вариант: от кода до креатива, работает как швейцарский нож среди ИИ.

Baidu ERNIE

-

Интерфейс по умолчанию на китайском 😅 Можно переключить на английский

-

Модель понимает русские промпты

-

Крутой reasoning и код, но UX хромает. Не для всех.

📌 Личное мнение:

Мои два фаворита — Qwen и DeepSeek.

Они оба бесплатные, с удобным доступом, быстро справляются с базовыми задачами.

А если нужно что-то нестандартное — всё упирается не в модель, а в промпт и формулировку задачи. На данный момент больше пользуюсь Qwen

Baidu ERNIE тоже достоин внимания, особенно если вы готовы мириться с интерфейсом «через китайский/английский». Под капотом он умный — просто не всегда дружелюбный.

Заключение

Это моя первая статья на Habr, поэтому строго не судите :-)

Если пробовали китайские LLM — напишите в комментах, кто вам понравился и почему. Возможно кто-то тестил: GLM, Doubao, Yi — дайте знать, как они!

Автор: Nikita_Sobetov