На протяжении более десяти лет графические процессоры Nvidia лежали в основе практически всех значимых прорывов в современной сфере искусственного интеллекта. Но теперь эта позиция впервые оказалась под серьезным давлением.

Фронтирные модели, такие как Gemini 3 от Google и Claude 4.5 Opus от Anthropic, были обучены не на оборудовании Nvidia, а на новейших Tensor Processing Units компании Google — TPUv7 на базе архитектуры Ironwood. Это показывает: жизнеспособная альтернатива GPU-центричному стеку ИИ уже существует — и она способна заметно изменить экономику и архитектуру обучения моделей предельного масштаба.

Дисклеймер: это вольная пересказ колонки Дэвида Чена. Перевод подготовила редакция «Технократии». Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» — мы регулярно рассказываем о новостях про AI, а также делимся полезными мастридами и актуальными событиями.

CUDA (Compute Unified Device Architecture) — программная платформа Nvidia, обеспечивающая доступ к массивному параллелизму GPU, — вместе с инструментами вокруг нее создала то, что многие называют «крепостью CUDA». Стоит один раз построить конвейеры на CUDA, и переход на другую платформу становится крайне дорогим из-за зависимости от программного стека Nvidia.

TPU же изначально создавались как специализированные чипы для задач машинного обучения. С каждым новым поколением Google продвигалась дальше в направлении ускорения крупномасштабных ИИ-вычислений, но теперь, став основой для двух самых мощных моделей в истории, TPUv7 демонстрируют явный стратегический шаг: попытку изменить баланс сил на рынке, доминируемом Nvidia.

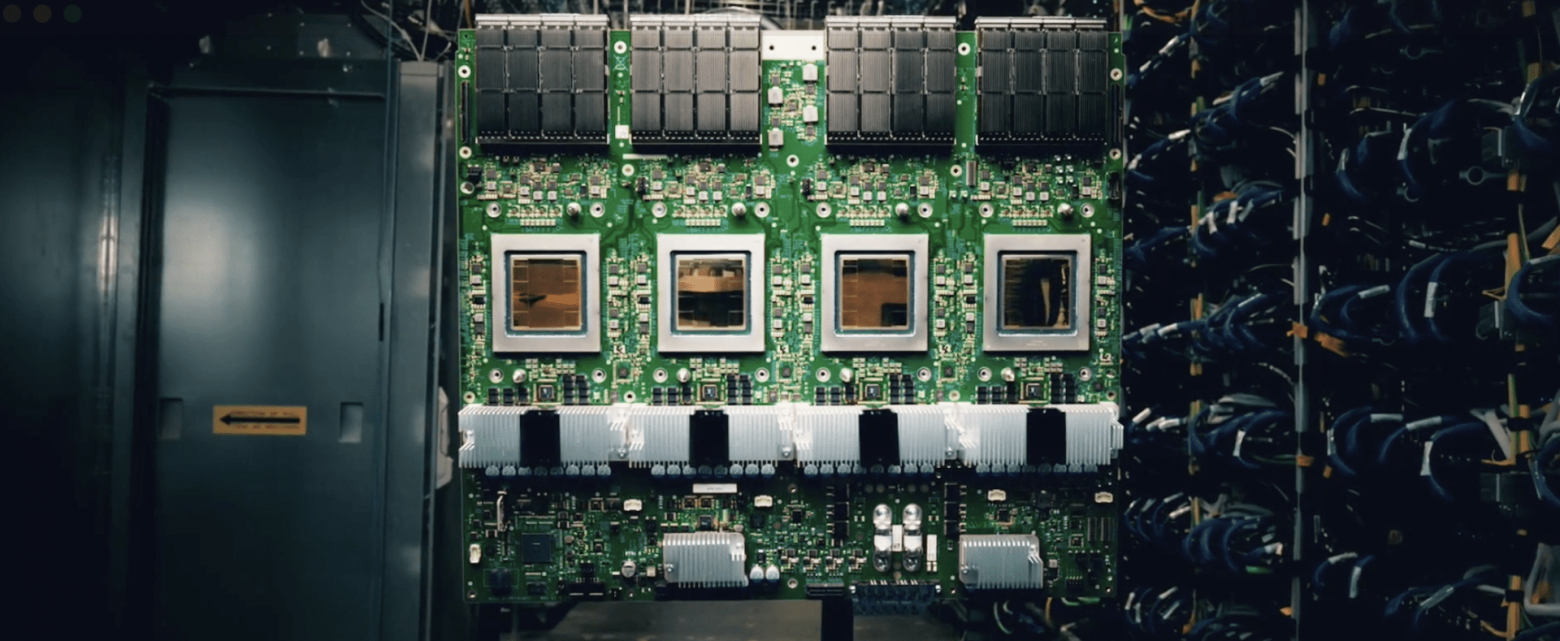

И GPU, и TPU ускоряют обучение моделей, однако они выражают разные философии дизайна. GPU — универсальные параллельные процессоры, тогда как TPU — специализированные системы, оптимизированные почти исключительно под крупные матричные операции. В TPUv7 Google продвинула эту идею дальше, встроив высокоскоростные межсоединения прямо в кристалл, благодаря чему массивы TPU масштабируются как единый суперкомпьютер — без тех затрат и задержек, которые характерны для кластеров на GPU.

«TPU создаются как полноценная система, а не просто как чип», — сказал в интервью VentureBeat Вал Берковичи, директор по ИИ в компании WEKA.

Коммерческий разворот Google: от внутреннего использования — к индустриальному стандарту

Исторически Google предоставляла доступ к TPU исключительно в аренду через Google Cloud Platform. Но в последние месяцы компания начала продавать оборудование напрямую, фактически разделив чип и облачную услугу. Теперь клиенты могут выбирать: использовать вычисления как операционные расходы, арендуя мощности в облаке, или как капитальные — приобретая оборудование. Это снимает серьезный барьер для крупных ИИ-лабораторий, которые предпочитают владеть инфраструктурой и хотят избежать «арендной надбавки» облаков.

Ключевым шагом новой стратегии стал крупный контракт с Anthropic: создатель Claude 4.5 Opus получит доступ до 1 миллиона TPUv7 — что эквивалентно более чем одному гигаватту вычислений. Через Broadcom, давнего партнера Google, Anthropic напрямую покупает около 400 тысяч чипов. Остальные 600 тысяч — арендует у Google Cloud. Этот контракт приносит Google миллиарды долларов и одновременно привязывает одного из ключевых конкурентов OpenAI к экосистеме Google.

Как рушится «крепость CUDA»

Годами Nvidia уверенно лидировала в инфраструктуре для ИИ. Помимо мощного железа, платформа CUDA включает богатую библиотеку оптимизированных ядер и инструментов. Огромное количество разработчиков, знакомых с этим стеком, и колоссальная установленная база сделали CUDA фактическим стандартом, отступление от которого выглядело нецелесообразным и слишком затратным.

Одним из факторов, сдерживающих распространение TPU, была экосистемная инерция. TPU долгие годы лучше всего работали с JAX — собственной библиотекой Google для численных вычислений и ML-исследований. Однако основная масса индустрии использует PyTorch, тесно связанный с CUDA.

Google взялась устранить этот барьер. TPUv7 получили полноценную нативную поддержку PyTorch: eager execution, распределённые API, torch.compile, а также поддержку пользовательских TPU-ядр под PyTorch toolchain. Цель — чтобы запуск PyTorch на TPU был таким же простым, как на GPU Nvidia.

Google также активно вносит вклад в vLLM и SGLang — популярные open-source фреймворки для инференса. Оптимизируя их под TPU, компания упрощает миграцию: разработчикам не нужно переписывать весь код.

Плюсы и минусы TPU по сравнению с GPU

Для компаний, сравнивающих TPU и GPU для крупномасштабных ML-задач, ключевыми метриками являются стоимость, производительность и масштабируемость. SemiAnalysis недавно опубликовали подробный анализ, сравнивающий эти параметры.

Благодаря более узкой специализации и высокой энергоэффективности, TPUv7 обеспечивают значительно более высокий показатель «пропускная способность за доллар» как для обучения, так и для инференса при больших объемах. Это снижает расходы на питание, охлаждение и дата-центры. По оценке SemiAnalysis, совокупная стоимость владения (TCO) сервером на Ironwood примерно на 44% ниже, чем у аналогичного GB200 Blackwell от Nvidia. Даже с учетом прибыли Google и Broadcom, внешние клиенты, такие как Anthropic, получают выигрыш в районе 30%. «Когда важна стоимость, TPU — логичный выбор для ИИ-проектов гигантского масштаба. TPU позволяют гиперскейлерам и лабораториям снизить TCO на 30-50%, что означает экономию в миллиарды», — отмечает Берковичи.

Это преимущество уже влияет на рынок. Сам факт появления альтернативы позволил OpenAI добиться примерно 30%-й скидки на закупки GPU Nvidia. Помимо этого, OpenAI в этом году добавила TPU Google через Google Cloud, чтобы удовлетворить растущие вычислительные потребности. Meta также, по сообщениям, ведет переговоры о закупке TPU для своих дата-центров.

Однако Ironwood — не «идеальный чип для всех». TPU блестяще справляются с глубоким обучением, но гораздо менее гибки, чем GPU, которые подходят для куда более широкого спектра задач, включая не-ИИ-вычисления. Если завтра появится новый метод машинного обучения, GPU сможет выполнить его сразу. Поэтому GPU — лучший выбор для компаний с разнородными вычислительными нагрузками.

Переход с GPU на TPU также может оказаться затратным и сложным: многие команды зависят от CUDA-конвейеров, кастомных GPU-ядер или фреймворков, которые пока не оптимизированы под TPU.

Берковичи рекомендует компаниям выбирать GPU «когда нужно двигаться быстро, и скорость вывода продукта на рынок критична. GPU используют стандартную инфраструктуру, имеют крупнейшую экосистему разработчиков, легко справляются с динамичными и сложными задачами, и могут быть развернуты в существующих дата-центрах без перестройки питания и сетевой архитектуры».

Кроме того, специалистов по TPU гораздо меньше. «Чтобы раскрыть потенциал TPU, компании нужна глубокая инженерная экспертиза — способность нанимать и удерживать редких инженеров, которые пишут собственные ядра и оптимизируют компиляторы», — добавляет он.

На практике преимущества Ironwood проявляются в первую очередь у компаний с крупными Tensor-насыщенными нагрузками. Тем, кому важна гибкость железа, гибридные облачные стратегии или энтерпрайз-задачи HPC-класса, GPU подойдут лучше. Во многих случаях наиболее разумным оказывается гибрид: сочетание TPU и GPU.

Будущее архитектуры ИИ

Борьба за доминирование на рынке ИИ-ускорителей стремительно обостряется, но говорить о победителе пока рано — возможно, его и не будет вовсе. При текущих темпах инноваций со стороны Nvidia, Google и растущей конкуренции со стороны Amazon, высокопроизводительные системы будущего, вероятно, будут гибридными, объединяя TPU и GPU.

«Мы видим ускоряющийся спрос на наши собственные TPU и на GPU Nvidia», — сообщил представитель Google VentureBeat. — «В результате мы значительно расширяем предложение GPU Nvidia, чтобы удовлетворить растущие потребности клиентов. На практике большинство наших клиентов Google Cloud используют и GPU, и TPU. Благодаря широкому выбору новейших GPU Nvidia и семи поколениям кастомных TPU мы можем предложить гибкость, позволяющую оптимизировать системы под конкретные задачи».

Автор: madballer34