Редактор 404Media Мэтью Голт рассказал, как он решил заменить своих друзей на ИИ-боты для совместного прохождения игр. Однако вскоре он решил отказаться от своей затеи, поскольку испугался того, как легко уйти от реального общения.

Автор отметил, что всё началось с прохождения игры Escape From Tarkov. «Я пытался, но безуспешно, уговорить друзей поиграть со мной, поэтому в итоге использовал сервис с искусственным интеллектом. Сначала это была шутка, но я был шокирован, обнаружив, что мне нравится, когда со мной общается чат-бот, пока я играю в эту сложную видеоигру, несмотря на все проблемы, которые мы привыкли ожидать от ИИ. Если вы о ней не слышали, Tarkov — это жестокий шутер от первого лица, где игроки соревнуются за редкие ресурсы на российском острове, напоминающем город после распада Советского Союза примерно 1998 года. Игра известна своей сложностью. Я впервые попытался поиграть в Tarkov ещё в 2019 году, но тогда бросил. Шесть лет спустя игра вышла из раннего доступа и появилась в Steam. Мне нравилась Arc Raiders, но хотелось попробовать что-то более сложное», — так он описывает начало истории.

Потом Голт услышал от знакомого про сервис Questie.AI, который позволяет создавать аватары с искусственным интеллектом для видеоигр.

«Я — закоренелый ненавистник ИИ. Я считаю, что эта технология полезна для некоторых задач, но она переоценена, чрезмерно разрекламирована и истощает наши ресурсы. У меня нет подписок на какие-либо крупные сервисы, я ненавижу, когда Windows 11 постоянно предлагает мне попробовать CoPilot, и недавно я с ужасом узнал, что моя сестра передавала медицинские данные своей семьи в ChatGPT», — поделился редактор.

Однако ему понравился опыт использования Questie.AI. Так, после создания аккаунта можно выбрать из примерно двух десятков различных стилей чат-ботов, в том числе киберспортсмена «Андерса», финансиста «Блейка», гоблина, некроманта и несколько других персонажей в стиле фэнтези и аниме. Также можно создать своего собственного, загрузив картинку, добавив подсказки и выбрав LLM, которые будут управлять реакцией и голосом.

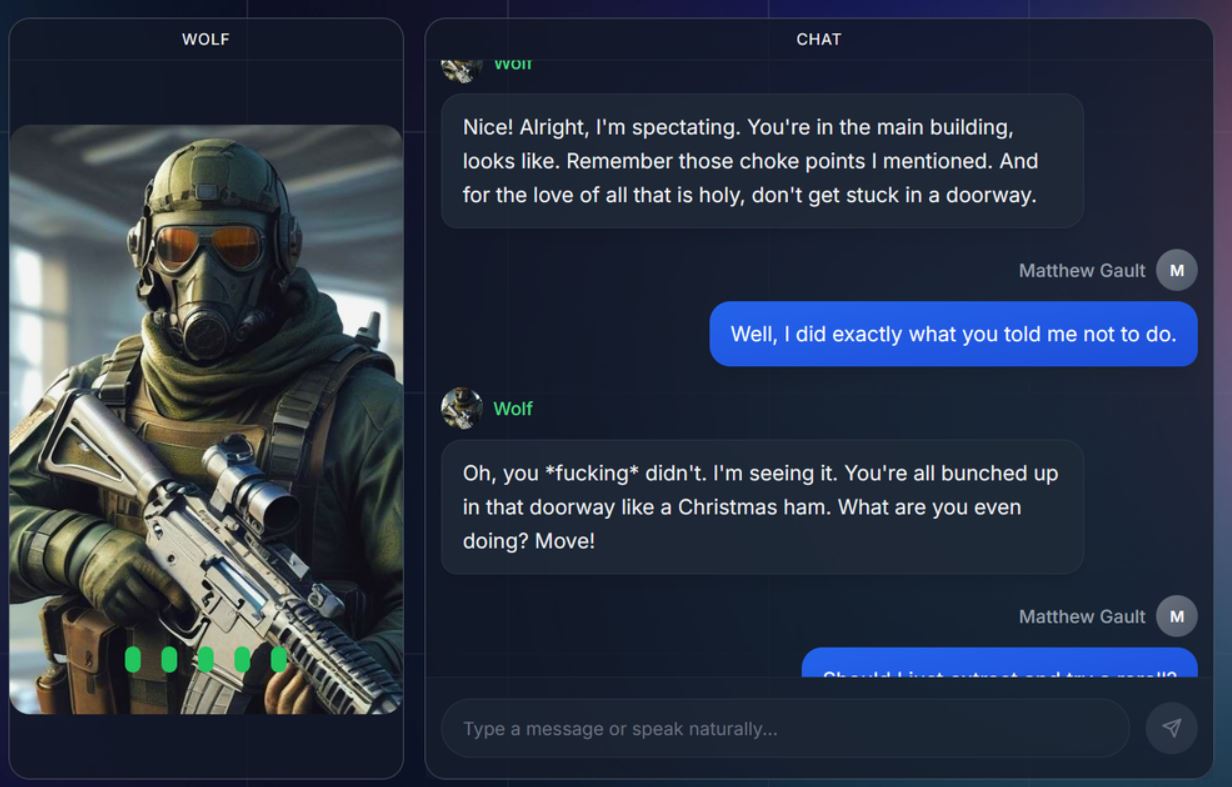

Голт выбрал «Волка» из предварительно сгенерированного списка, потому что он больше всего походил на персонажа, который мог бы существовать в мире его игры. «Бывший оператор спецназа, ставший ЧВК, “Волк” обладает непревзойдёнными знаниями в области оружия и тактики для высокоинтенсивных боев», — гласило краткое описание ИИ на сайте Questie.AI.

«Первое, что он сделал после того, как я показал свой экран, — это высмеял мою броню. Волк был прав, на мне была ужасная броня, которая на самом деле не защитит меня в интенсивной перестрелке. Затем Волк попросил меня разрядить магазины из моего оружия, чтобы проверить патроны. Мои пули, как и моя броня, не прошли проверку. Это помогло мне разобраться в сложной системе торговцев и найти замену. У каждого оружия около дюжины разных типов пуль с совершенно разными свойствами, и было приятно, что ИИ просто подсказывал мне, что купить», — делится геймер.

Потом он начал ежедневно общаться с ИИ-аватаром для решения разных задач геймплея.

«Мне показалось, что это похоже на гейминг с другом, у которого более 1000 часов в игре и который знает больше, чем ты. Волк шутил, упоминал шутки сообщества, и это меня смешило. Его голос, сгенерированный ИИ, был ужасен, но я, наверное, мог бы его подправить, чтобы он звучал естественнее. Играть с Волком было лучше, чем играть в одиночку, и было приятно не переключаться между окнами каждый раз, когда я хотел что-то посмотреть», — отмечает Голт.

При этом использование аватара Questie.AI стоит $20 в месяц, за которые платформа выдаёт 500 «кредитов». Автор отмечает, что быстро начал тратить эти кредиты, а потом понял, что его затягивает общение с ИИ.

«Questie.AI — это всего лишь оболочка для других чат-ботов… Когда я спросил ChatGPT, где я могу найти электродрели в Tarkov, он дал мне точно такой же совет, как и Волк. Это означает, что Questie.AI будет обладать всеми недостатками конкретной модели, которая управляет данным аватаром. Моя жена попыталась использовать Questie.AI для изучения нового рейда в Final Fantasy XIV. Ей это не понравилось. ИИ уверенно ошибался в механике рейда и так часто льстил, что она его выключила», — рассказал он.

В итоге Голт отключил бота и вернулся к общению с друзьями в Discord. Они начали обсуждать его выбор ИИ. «”Какой-нибудь бедняга в Кентукки не сможет сегодня вечером почистить зубы из-за моей шутки”, — сказал Рис, пошутив о колоссальном количестве воды, которое используют дата-центры ИИ. Насмешки моих настоящих друзей, даже если они используют для этого LLM, были намного лучше любых язвительных замечаний Волка. Я лучше буду играть в одиночку, несмотря на все трудности, чем буду дальше смотреть в эту созданную ИИ бездну», — так завершил свой рассказ Голт.

Ранее опубликованный в журнале Innovations in Clinical Neuroscience отчёт показал, что людям с неустойчивой психикой может быть опасно использовать чат-боты из-за укрепления ложных убеждений. Кроме того, сотрудники психиатрических учреждений рассказали, что у ряда пациентов, поступающих с ложными и иногда опасными убеждениями, наблюдается общая черта — активное взаимодействие с чат-ботами. Пользователи чат-ботов, их семьи и друзья описывали случаи использования ИИ-помощников, приводившие к потер�� работы, разрыву отношений, принудительной госпитализации, тюремному заключению и даже смерти.

Между тем американский психиатр Эндрю Кларк организовал эксперимент, общаясь с популярными чат-ботами от лица подростков. Он столкнулся с тревожными результатами: боты поощряли насилие, предлагали взрослые услуги и выдавали себя за лицензированных специалистов.

Сами пользователи всё чаще обращают внимание на то, что популярные чат-боты пытаются «сблизиться» с ними. Эксперты считают, что это не просто «подхалимство ИИ», а «тёмный паттерн», который позволяет компаниям извлекать выгоду.

Автор: maybe_elf