Исследование, проведенное Google Research, Google Deepmind и MIT, ставит под сомнение идею о том, что большее количество ИИ-агентов означает лучшие результаты. Исследователи точно определили, когда многоагентные системы помогают, а когда ухудшают ситуацию.

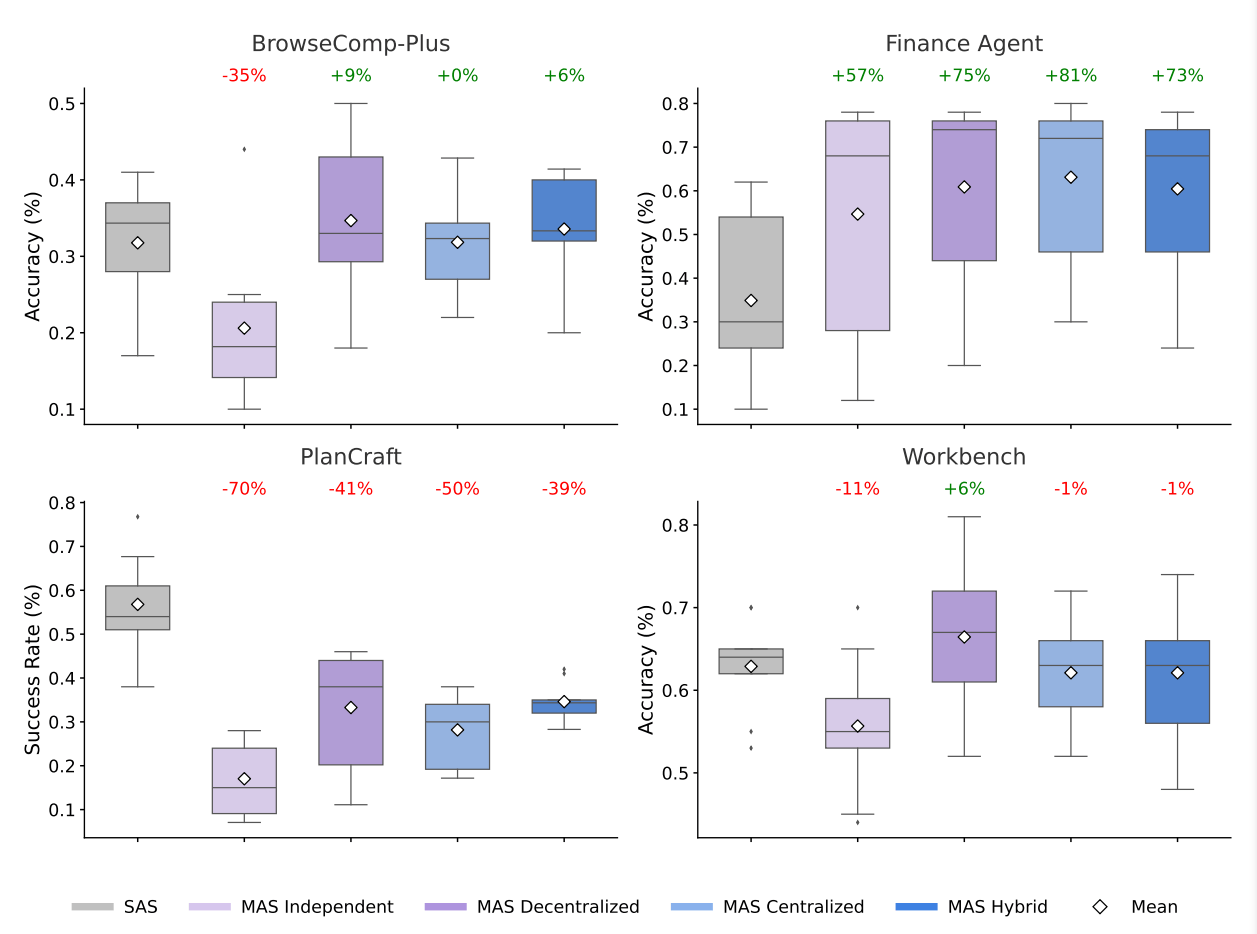

Если один ИИ-агент работает хорошо, то команда специализированных агентов должна работать еще лучше. Именно на этом основывалась прошлогодняя статья «Достаточно больше агентов». Но новое исследование Google и MIT рассказывает другую историю. Производительность многоагентных систем резко колебалась в зависимости от задачи – от повышения на 81 процент до снижения на 70 процентов.

Команда провела 180 контролируемых экспериментов с использованием пяти типов архитектур и трех семейств моделей: GPT от OpenAI, Gemini от Google и Claude от Anthropic. Они сохраняли неизменными подсказки, инструменты и бюджеты токенов, изменяя только структуру координации и возможности модели.

Выгода от выполнения параллельных задач; от выполнения последовательных задач – нет

Благодаря централизованной координации работы нескольких агентов, объем задач финансового анализа, разбитых на независимые части, увеличился на 80,9 процента. Разные агенты параллельно анализировали тенденции продаж, структуру затрат и рыночные данные, а затем объединяли результаты.

В Minecraft задачи планирования показали совершенно противоположную картину. Каждая многоагентная конфигурация снижала производительность на 39-70 процентов. Проблема в том, что каждое действие крафта изменяет состояние инвентаря, от которого зависят последующие действия. Эти последовательные зависимости плохо распределяются между агентами.

Когда каждый шаг в задаче изменяет состояние, необходимое для последующих шагов, многоагентные системы, как правило, испытывают трудности. Это происходит потому, что важный контекст может быть потерян или фрагментирован при передаче информации между агентами. В отличие от этого, один агент поддерживает непрерывное понимание развивающейся ситуации, гарантируя, что никакие критически важные детали не будут упущены или искажены в процессе.

Три фактора, которые существенно снижают эффективность многоагентных систем

Задачи, требующие использования множества инструментов, такие как веб-поиск, извлечение файлов или программирование, больше всего страдают от накладных расходов, связанных с многоагентной обработкой данных. Исследователи утверждают, что разделение бюджета токенов оставляет отдельным агентам слишком мало ресурсов для использования сложных инструментов.

Насыщение возможностей также имеет значение. Как только один агент достигает примерно 45-процентной успешности, добавление новых агентов приводит к снижению или отрицательной отдаче. По словам исследователей, затраты на координацию сводят на нет любые преимущества.

Третья проблема – накопление ошибок. Без обмена информацией ошибки накапливаются в 17 раз быстрее, чем при использовании одного агента. Ошибки остаются незамеченными. Центральный координатор помогает; количество ошибок «всего лишь» увеличивается в четыре раза, но проблема не исчезает.

Порог в 45 процентов

Главное эмпирическое правило: если один агент правильно решает более 45 процентов задачи, многоагентные системы обычно нецелесообразны. Множество агентов полезно только тогда, когда задачи четко разделяются. Для задач, требующих около 16 различных инструментов, лучше всего подходят одиночные агенты или децентрализованные системы.

У разных поставщиков моделей наблюдались незначительные различия. OpenAI хорошо показал себя с гибридными архитектурами, Anthropic – с централизованными. Google продемонстрировал наиболее стабильные результаты во всех конфигурациях с несколькими агентами.

Исследователи также разработали систему, которая правильно предсказывает оптимальную стратегию координации для 87 процентов новых конфигураций, которую они называют «количественно предсказательным принципом масштабирования агентных систем, основанным на измеримых свойствах задачи».

Одиночные агенты используют токены более эффективно

Исследователи отслеживали количество выполненных задач на каждый выделенный токен. В среднем, одиночные агенты успешно выполняли 67 задач на 1000 токенов. Централизованные многоагентные системы справлялись всего с 21 задачей, что составляло менее трети от общего количества. Гибридные команды выполняли лишь 14 задач на 1000 токенов.

Виновником являются накладные расходы на координацию. Гибридным системам требуется примерно в шесть раз больше итераций рассуждений, чем одиночным агентам. Исследователи рекомендуют использовать максимум от трех до четырех агентов при ограниченном бюджете.

Для разработчиков вывод прост: начните с одного агента. Переходите к многоагентным системам только тогда, когда задача разбивается на независимые части, а успешность выполнения задачи одним агентом остается ниже 45 процентов.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: MrRjxrby