Мы уже видели, как языковые модели решают задачки, над которыми профессора чесали головы годами. Видели, как они не решали задачу, а просто находили ответ, потому что знали, где копать (и не ленились, в отличие от нас, смертных). А теперь Claude Code от Anthropic залез в криптографию и починил реализацию постквантового алгоритма.

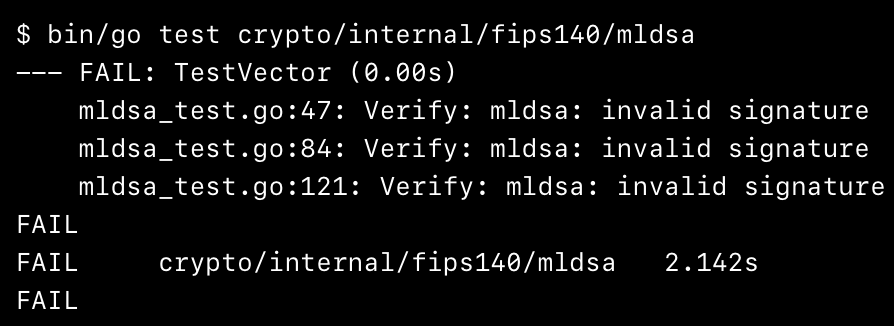

Инженер писал на Go реализацию ML-DSA, всё шло по плану, пока проверки не начали сыпаться с “invalid signature”.

Дальше — классика: часы дебага, кофе, отчаяние. И вот Filippo, автор кода, решает: “а пусть Claude посмотрит”. Через несколько минут LLM спокойно отвечает:

Ты дважды взял high bits

И оказывается права. Баг нашёл не эксперт, а языковая модель.

Самое интересное — как именно Claude работал. Он вёл себя, как живой разработчик: ставил printf, гонял тесты, отслеживал неверные значения, искал закономерности. И, что важно, нашёл ошибку быстрее человека.

А под конец Filippo выдал отличную идею:

А что, если бы у нас был инструмент, который автоматически запускал LLM, когда падают тесты, и просто сообщал: “я нашёл причину”? Если модель справилась быстрее — класс, если нет — ничего страшного, продолжаем сами. Такой сценарий звучит куда реалистичнее, чем “сделай PR” или “реши задачу целиком”.

Русскоязычное сообщество про AI в разработке

Друзья! Эту новость подготовила команда ТГК «AI for Devs» — канала, где мы рассказываем про AI-ассистентов, плагины для IDE, делимся практическими кейсами и свежими новостями из мира ИИ. Подписывайтесь, чтобы быть в курсе и ничего не упустить!

Автор: python_leader